剖析存储芯片及技术在AI领域的应用

描述

2025 年下半年以来,全球 DRAM 内存价格大幅上涨,部分型号售价一度达到往常的两倍以上。业内分析普遍认为,这场涨价潮主要由 AI 算力需求的爆炸式增长与供应链调整共同推动,且这一趋势预计将持续。在此背景下,深入理解驱动 AI 革命的存储技术变得至关重要。本文将系统梳理与 AI 紧密相关的核心存储芯片及技术,剖析它们如何在不同场景下支撑起智能计算的海量数据需求。

提到存储,多数用户首先会想到硬盘(SSD)或内存(DRAM)。从云端 AI 服务器到边缘智能设备,都离不开这两大基石。从技术本质看,硬盘领域的 SATA / NVMe 接口 SSD,乃至手机中的存储芯片,均基于 NAND Flash(非易失性存储器)技术。它通过晶体管存储电荷来记录数据,断电后信息依然保留。为突破物理平面极限,当前主流技术已演进至 3D NAND,通过纵向堆叠存储单元,在同等芯片面积下实现了更高的存储密度、更低的功耗、更佳的耐用性与更快的读写速度,同时有效降低了单位成本。

与 NAND 作为“数据仓库”的角色不同,DRAM(动态随机存取存储器)充当了系统的“工作台”。它通过电容存储数据,但由于电容会自然放电,需要定期刷新,因此属于易失性存储器,断电后数据会丢失。在 AI 服务器和个人电脑中,DRAM 最常见的形态是内存条,其采用 DDR(双倍数据速率)技术。 DDR 能够在带宽、延迟、容量和成本间取得平衡,因此被广泛用作系统主内存,目前主流已进入 DDR5 时代。

除了 DDR 内存,在 AI 领域应用同样广泛的还有 GDDR(Graphics Double Data Rate)——这是独立显卡(GPU)的专用显存。无论是 AI 计算场景,还是图形渲染任务,GPU 都需要显存提供高速的数据存储与读取支持;若显存带宽不足,将直接制约整体计算效率的提升。

例如,NVIDIA RTX PRO 5000 Blackwell 配备 48GB 超高速 GDDR7 的内存,有助于加速台式电脑上的 AI 开发、LLM 推理和生成式 AI 工作流,以及高保真仿真、视频制作和复杂 3D 建模等操作。借助 RTX PRO 5000 可以无缝运行本地 AI 助手,通过神经网络渲染制作逼真的视觉效果,并优化工程和科学研究所需的精度关键型仿真,所有这些操作都以卓越的稳定性高速运行。

在 AI 领域,除了 GDDR 显存类型的存储芯片外,一些高端的数据中心 GPU 比如 H20、H200 等型号,它采用的是 HBM 内存(High Bandwidth Memory),HBM 和 GDDR 最大的不同是采用了 3D 堆叠技术,GDDR 可以理解为平铺在 PCB 上,互联方式采用 PCB 主板走线通信,而 HBM 则是将多个 DRAM 核心摞起来,堆叠的各层之间通过贯穿硅片的微型垂直通道—硅通孔连接,提供了短且多的内部互联通道,目前最新的 HBM3e 可以实现 8TB / 秒的显存带宽,高于 GDDR 方案数倍,多适用于超大规模的 AI 训练与 HPC 业务。

并非所有 AI 场景都需要如此卓越的性能,在边缘计算和桌面工作站等场景中,功耗、散热和空间限制同样关键。此时,LPDDR 技术(Low Power Double Data Rate SDRAM)便成为理想选择。它通过降低工作电压、引入精细的电源状态管理,实现了出色的能效比。NVIDIA DGX Spark 便是一例:它采用 Grace CPU + Blackwell GPU 的 GB10 超级芯片,并创新性地配备了 128GB LPDDR5x 统一内存供 CPU 与 GPU 共享。这种设计大幅减少了数据搬运延迟,使得开发者能在单台最大功耗仅 240W 的桌面设备上,对参数高达 2,000 亿的大模型进行微调与推理。

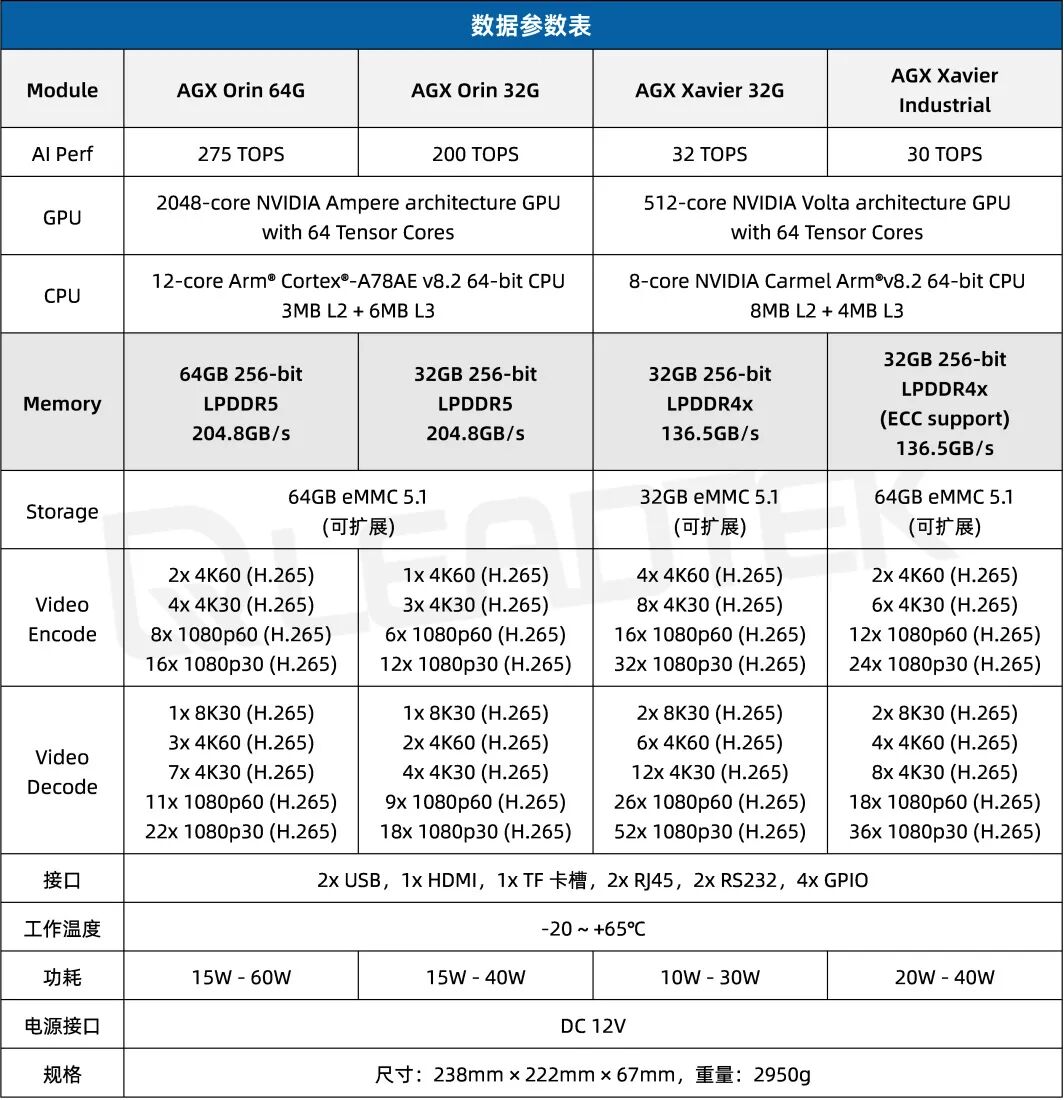

在更严苛的边端场景,比如生产车间、码头、工地这些工业场景,同样需要使用到 AI 算力进行目标检测,人脸识别,危险预警等业务,这种场景下更考验能耗散热,因为设备往往需要放置在弱电箱内。在此场景下丽台科技基于 NVIDIA Jetson 系列产品进行开发,提供了多种场景可选的 AI 工控机,涵盖 NVIDIA Jetson Orin、NVIDIA Jetson Thor 系列,此系列产品全部是采用了 LPDDR5 技术的显存。下面以 LEADTEK 丽台 嵌入式工控机 8F5E2 为例。

► LEADTEK 丽台 嵌入式工控机 8F5E2

基于 NVIDIA Jetson AGX Orin/AGX Xavier 开发,算力高达 275 TOPS,被动式散热,I / O 接口丰富,可扩展性强,多场景灵活部署。

应用场景:车路协调、机器视觉、安防边检、智慧物流、工业自动化。

▲ 嵌入式工控机 8F5E2

注:搭载 AGX ORIN 时支持 USB 3.1 功能,并向下兼容。搭载 AGX Xavier 时,仅支持 USB 2.0 功能

AI 的蓬勃发展并非仅依赖于处理器算力单点突破,更得益于一个多层次、协同高效的存储生态系统。从数据中心里提供高带宽的 HBM,到显卡中负责高吞吐的 GDDR;从服务器内平衡全能的 DDR,到边缘设备中能效优先的 LPDDR,再到所有数据的最终归宿——海量、非易失的 NAND Flash,每一种存储技术都在自己最擅长的位置上,解决了 AI 在不同规模、不同场景下面临的特定数据挑战。

-

雷军都喊贵!存储芯片涨价风暴,手机电脑集体涨价#芯片#存储芯片#AIjf_15747056 2025-10-28

-

存储芯片从无到有的全过程,这些技术细节你肯定没听说过2025-10-24 741

-

划片机在存储芯片制造中的应用2025-06-03 829

-

划片机在存储芯片切割中的应用优势2024-12-11 1161

-

存储芯片有哪些类型2024-07-24 9862

-

三星电子存储芯片涨价,AI需求激增提振业绩预期2024-06-27 1392

-

存储芯片减产,AI芯片暴增!2023-09-08 1299

-

ai芯片和存储芯片的区别2023-08-09 6996

-

存储芯片的原理_分类及应用2023-06-02 18468

-

数据与存储芯片之间有什么关系?2021-06-18 6791

-

传统存储芯片到达技术节点2020-12-06 4248

-

长江存储128层NAND flash存储芯片 中国存储芯片国际领先2020-04-14 14802

-

存储芯片厂商有哪些_八大存储芯片厂商排名2018-04-08 115527

-

存储芯片入门漫谈2016-08-16 10607

全部0条评论

快来发表一下你的评论吧 !