摩拜一下他的开挂人生,6篇论文入选NIPS 2018

电子说

描述

世界上总有一群人,过着开挂的人生。

很不幸,我不是这样的人。

根据 Google Scholar Metric 的最新榜单,NIPS 是 Artificial Intelligence 下排名最高的学术会议,它的 h5-index 为 134,h5-median 为 221,可见含金量之高。

而 IBM 工程师 Inkit Padhi 统计的数据显示,在这样一个有影响力的会议上,作为第一作者被接收的论文最多的是一个中国小哥——朱泽园(ZEYUAN ALLEN-ZHU),其 6 篇论文有 4 篇都是第一作者。

就在去年的 ICML 2017 上,也就是 Google Scholar Metric 里排名第二的 AI 会议,朱泽园也是一作最多的作者,一共有 5 篇一作论文被接收。

这位小哥到底是何方神圣,首先让我们来摩拜一下他的开挂人生。

朱泽园是个 80 后,南京人,从小就属于别人家的小孩。

据说,还在小学六年级的朱泽园参加初中组的数学竞赛就获得了全省第 5。

小学毕业后,朱泽园作为特长生被招进南京外国语学校。

这里不是打广告,但是网上流传着一种说法,南外是南京的伊顿公学,教育界的 urban legend,南外人的成绩就像神一样的存在。

不过,牛人众多的南外也没能阻止朱泽园继续开挂。

给大家展示一下朱泽园 2000-2006 就读于南外期间所斩获的奖项,其中曾两次获得国际信息学奥林匹克竞(IOI)赛金牌。

看看下面这些奖状和徽章,简直让邻居家的小孩闻风丧胆。

除了上面的这些竞赛成绩,小哥各种奖学金也是拿到手软,而且还是那种巨不好拿的奖学金。要知道,在中学期间,家境不太宽裕的的朱泽元为了补贴家用,还做过好几份家教。

除了各种获奖,朱泽园在中学期间就展现出过人的科研天赋,比如下面的这些文章。

其中New Algorithm for Half-plane Intersection and its Practical Value不仅是英文撰写,而且还在封面用红字写着“献给我心爱的母亲”。

看看人家的文章标题,看看人家的孝心。你再想想,18 岁的你在干些什么?(捂脸)

邻居家的小孩当然不是白叫的。很多人小时候都幻想过长大了是选北大(青鸟)还是青华(职校)的时候,凭借着出类拔萃的成绩,朱泽园在初三时就已经获得了清华大学的保送资格。

消息来源:

http://www.mydrs.org/list-id=599.htm

总有人会说,小时了了,大未必佳。抱歉,朱泽园让这些人失望了。

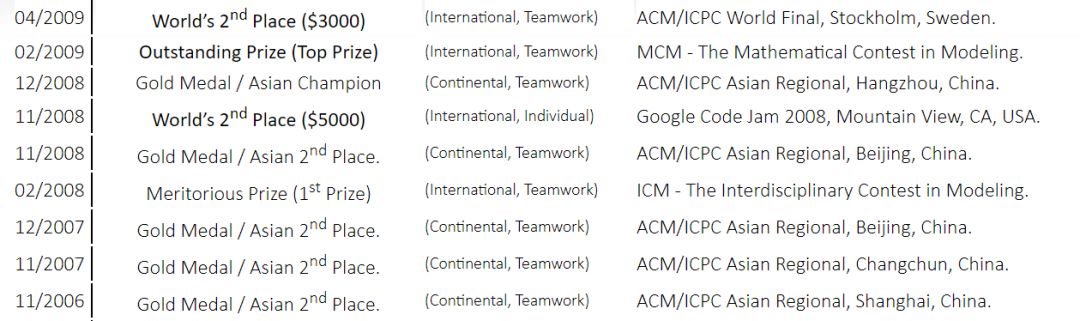

2006 年,朱泽园进入清华大学,攻读数学和物理专业,各种竞赛奖项依然拿到手软,更是 5 次获得 ACM/ICPC Asian Regional 的金牌。

奖状和徽章一张截图根本放不下。

当然,还有各种听过名字和没听过名字的奖学金。

不仅如此,朱泽园还在本科期间获得了各种科研奖金。

2010 年,朱泽园赴美留学,在 MIT 攻读硕士和博士学位。仅仅 5 年时间,朱泽园就从 Bachelor 变成了 Doctor,而且还是 MIT 的 Doctor。

在美国读过博士的,都应该知道朱泽园的速度有多快,那都不是高铁,而是磁悬浮列车。

2015 年,拿到 MIT 博士的朱泽园进入普林斯顿高等研究所做博士后项目。中国人都知道 MIT,但是了解普林斯顿高等研究的并不多。

给大家列一串名字,爱因斯坦、哥德尔、冯·诺伊曼、奥本海默、小平邦彦、杨振宁、李政道,这些都是普林斯顿高等研究所的历史名人。

现在你知道能加入这个机构到底有多牛了吧。

2017 年,朱泽园正式加入微软,做人工智能相关的研究。

目前,朱泽园主要致力于机器学习和优化问题的数学基础的相关研究,并将它们应用于深度学习、理论计算机科学、运筹学和统计学。

而且小哥还说了,自己对物理、社会、经济和生物系统的数学建模也很感兴趣。嗯,这些兴趣还真是……让我等凡人望而生畏。

当然,科研成绩得靠论文来说话。

朱泽园在自己的主页上列出了从 2009 年至今已经发表的论文,一共 50 篇,其中一作或者等同于一作的论文数量 49 篇(only(equal)first-author papers),而且是各种顶会随便发。

论文详细地址:

http://people.csail.mit.edu/zeyuan/publications.htm

而且,小哥的手速越来越快。营长粗略的统计了下,2018 还没过完,朱泽园就已经发表了 9 篇论文,简直不要太高产。

我们来看看这次小哥发表在 NIPS 2018 上的 6 篇论文。为了锻炼大家的英语水平,我们就不翻译了。(笑脸)

1、Is Q-Learning Provably Efficient?

2、Optimal Byzantine-Resilient Stochastic Gradient Descent

3、NEON 2: Finding Local Minima via First-Order Oracles

4、The Lingering of Gradients: How to Reuse Gradients Over Time

5、Natasha 2: Faster Non-Convex Optimization Than SGD

6、How To Make the Gradients Small Stochastically

看到这些论文标题,营长觉得自己回炉再重造 100 次也是没办法理解了。

现在很多企业招算法工程师都要求在 AI 顶会上发表过论文,相比起一些人的囊中羞涩,捉襟见肘,小哥可以直接甩给面试官一沓,都不带怵的。

这,就是,人与神之间的,差距。

最后,趁着中秋佳节,给大家拜个早年。并为大家献上小哥的学神照,保佑考试的不挂科,就业的找个好工作。祝大家阖家幸福,万事如意!

全部0条评论

快来发表一下你的评论吧 !