详细阐述黑盒机器学习模型的术语概念以及相关方法

电子说

描述

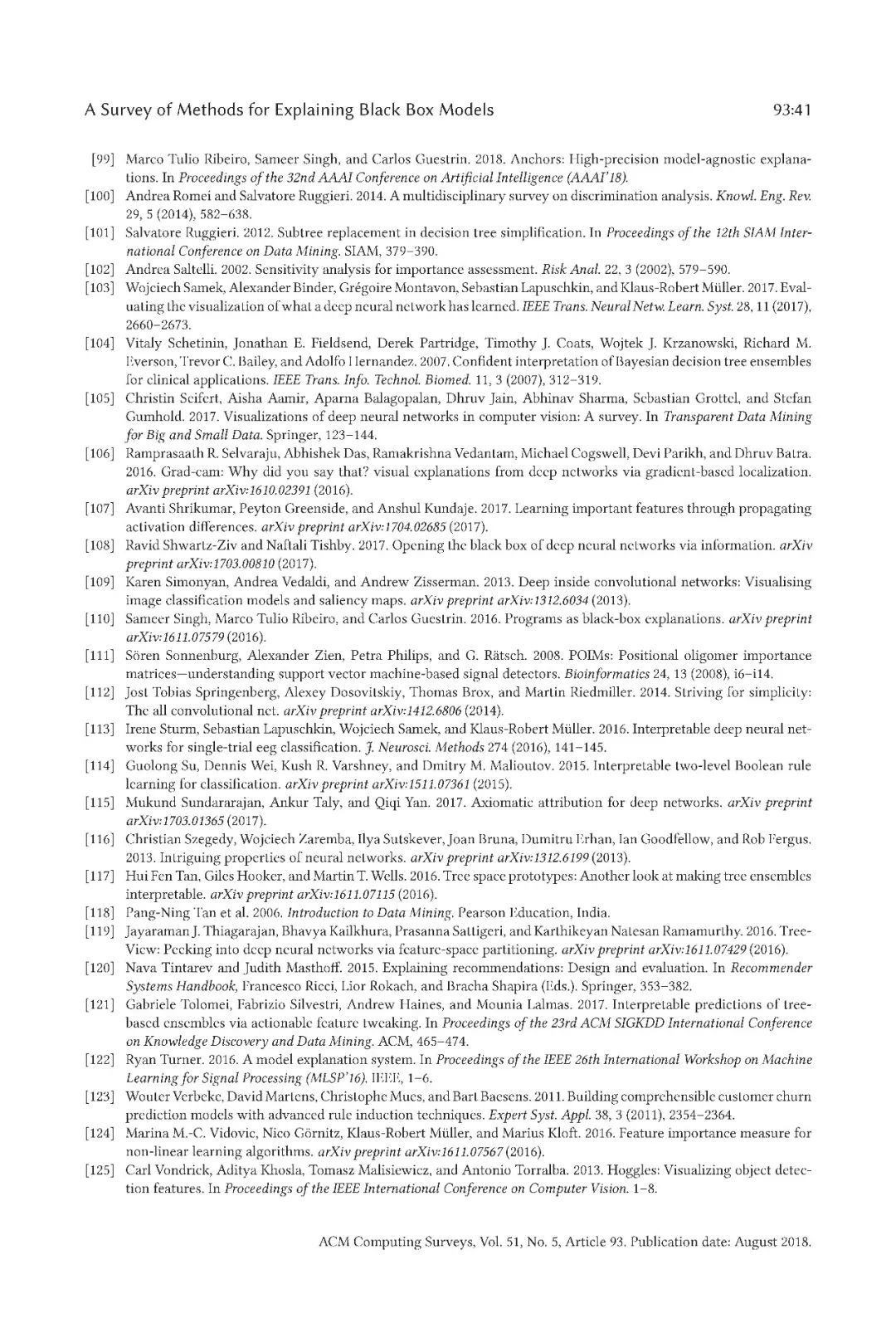

最近一期的计算机顶级期刊ACM Computing Surveys (CSUR)出版,包含了来自意大利比萨大学的研究人员发布的一篇构建机器学习可解释性综述论文《A Survey of Methods for Explaining Black Box Models》,详细阐述了解释黑盒机器学习模型的术语概念以及相关方法,是构建可解释模型的重要指南。

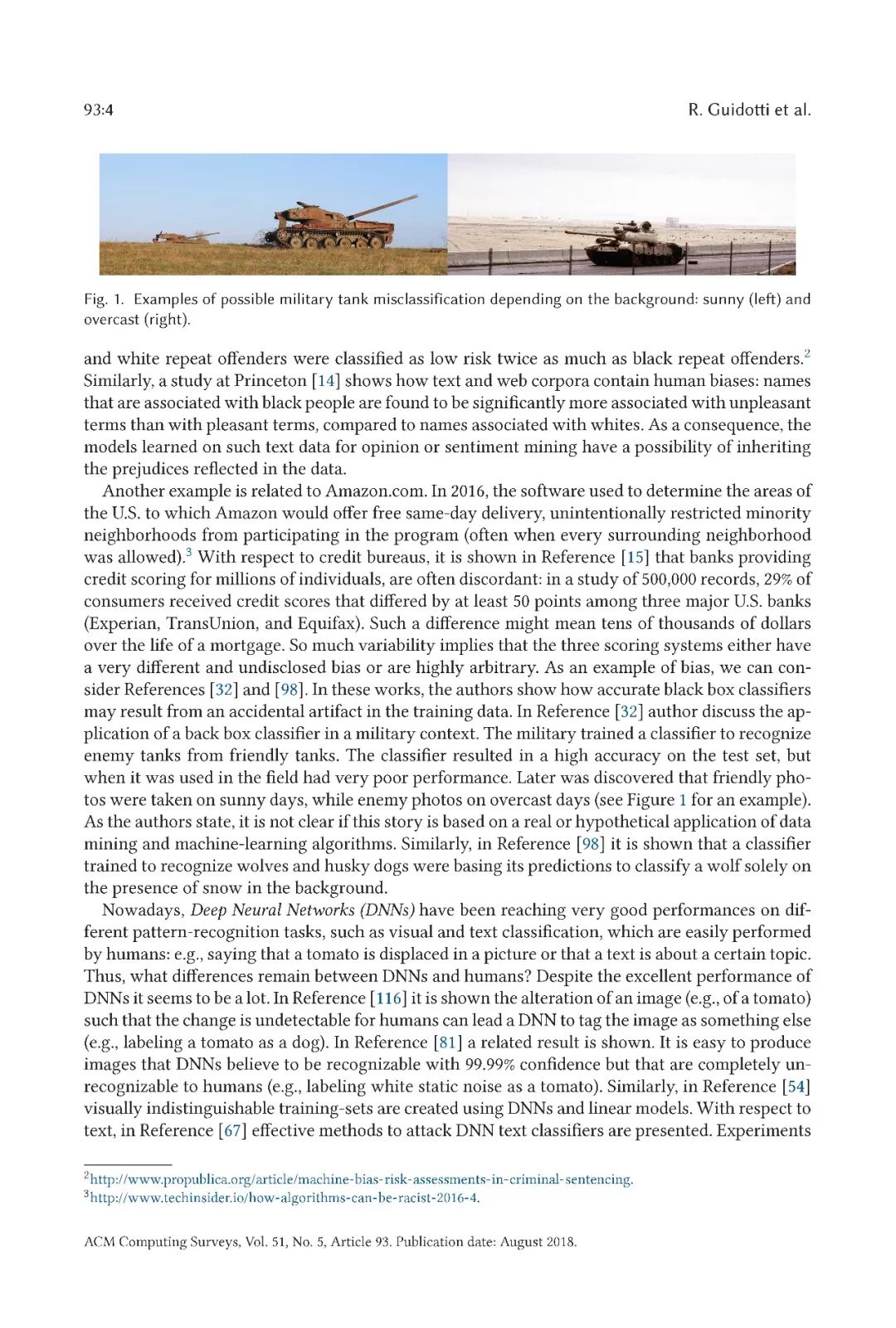

近年来,许多准确的决策支持系统被构建为黑盒子,即向用户隐藏其内部逻辑的系统。缺乏解释性既是实际问题,也是道德问题。这篇综述文献报道了许多旨在克服这一至关重要弱点的方法,有时以牺牲准确性为代价来提升可解释性。可以使用黑盒决策系统的应用是多种多样的,并且每种方法通常被开发以提供针对特定问题的解决方案,并且因此,其明确地或隐含地描绘其自身对可解释性的定义。

本文的目的是提供调研文献中关于解释概念和黑匣子系统类型的主要问题的分类。给定问题定义,黑匣子类型和所需解释,此综述应该有助于研究人员找到对他自己工作更有用的建议。所提出的黑匣子模型分类方法也应该有助于对许多研究开放性问题。

文章导读

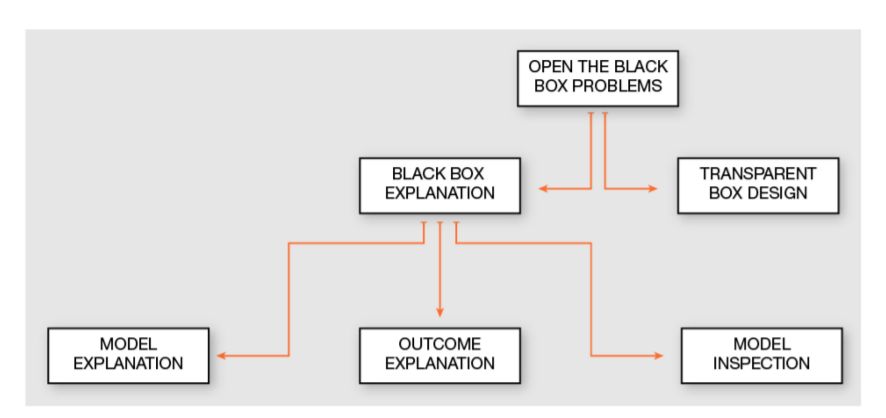

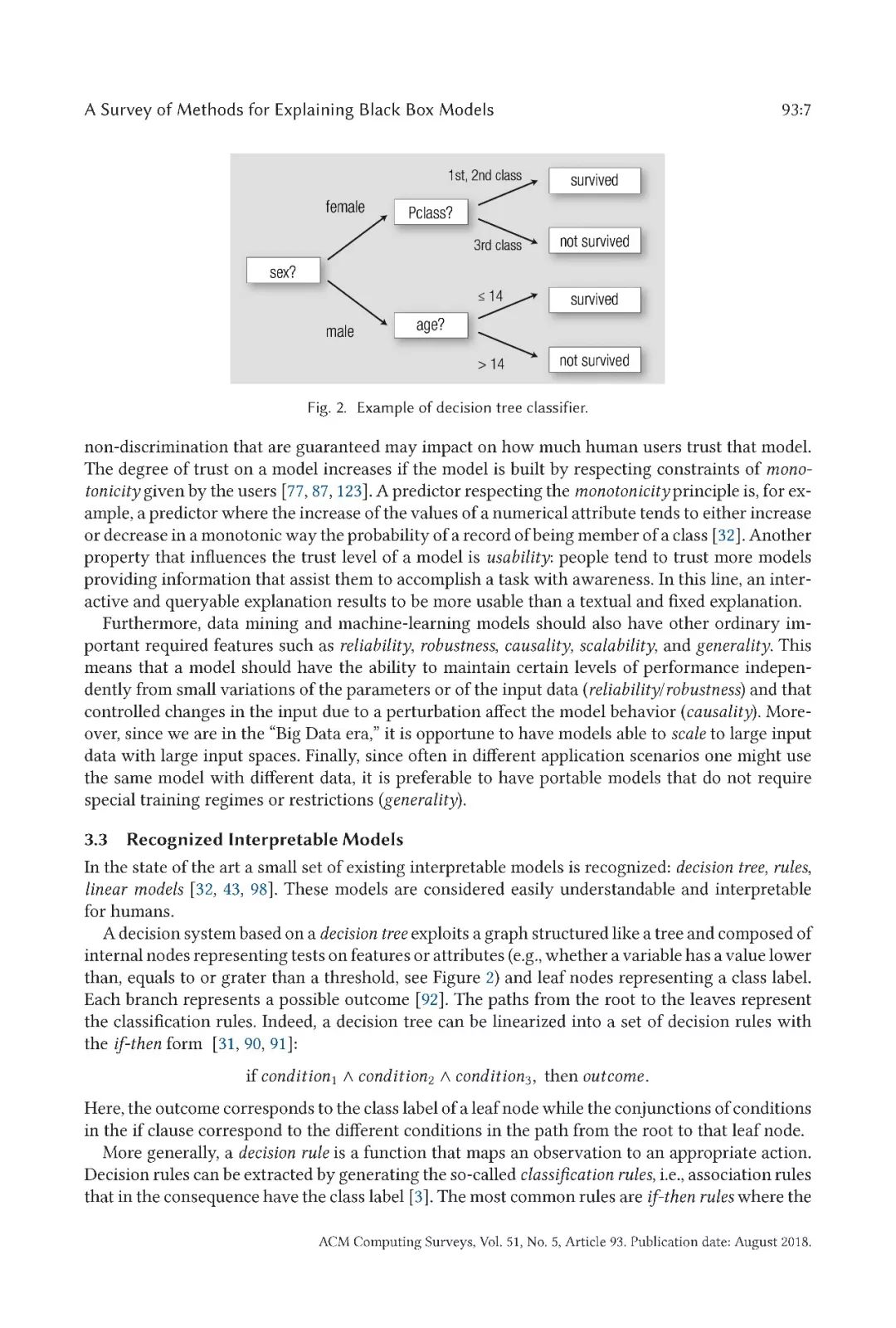

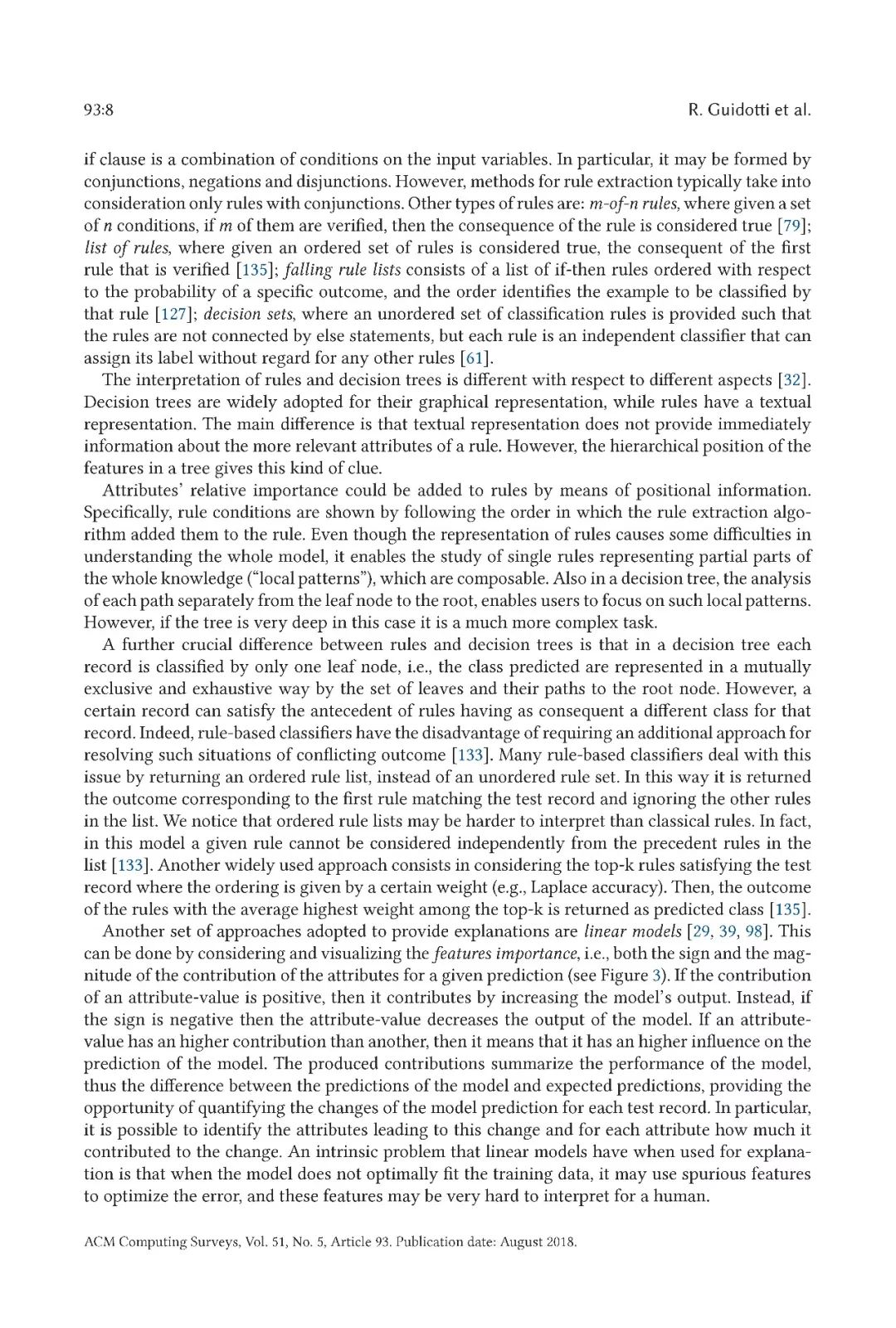

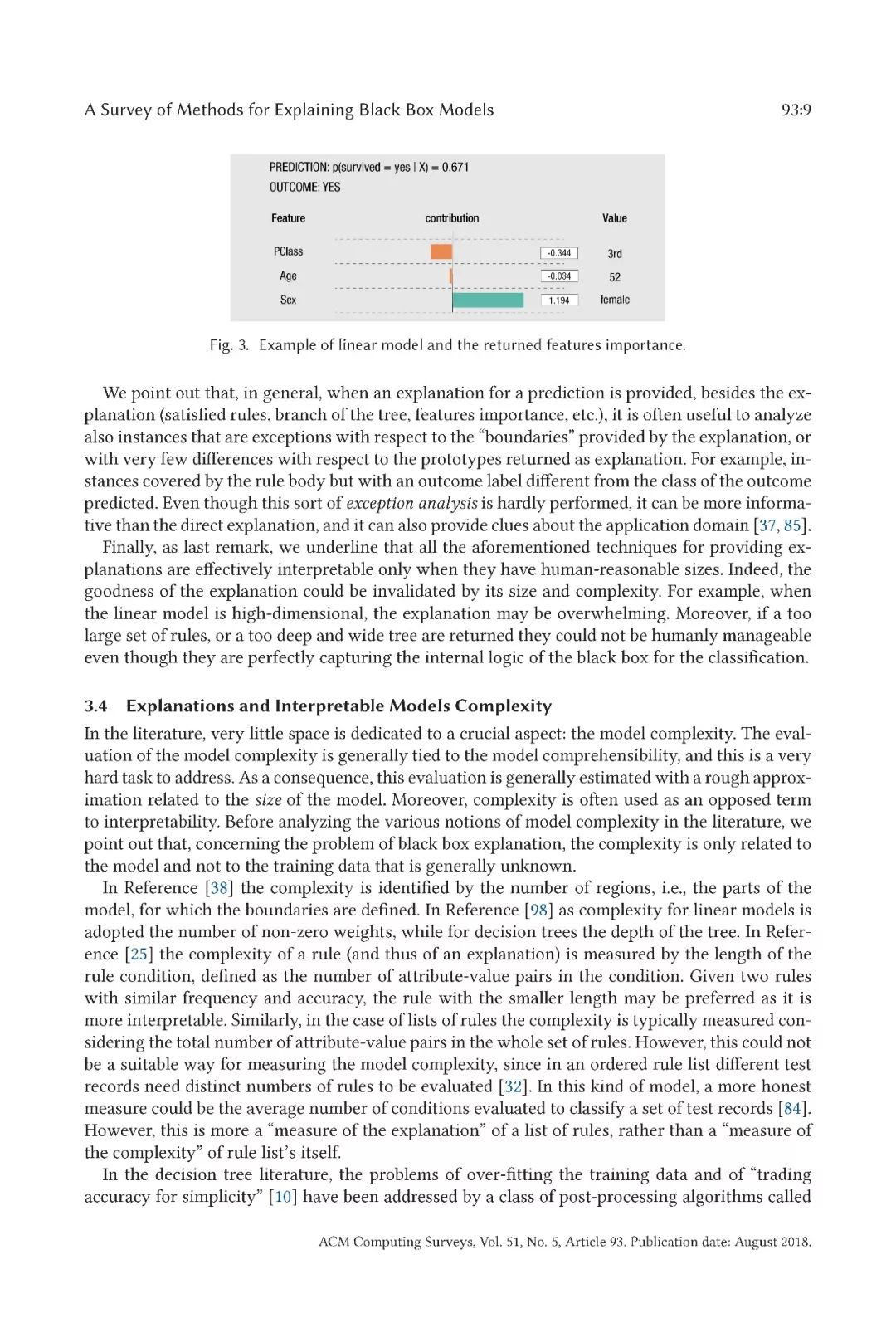

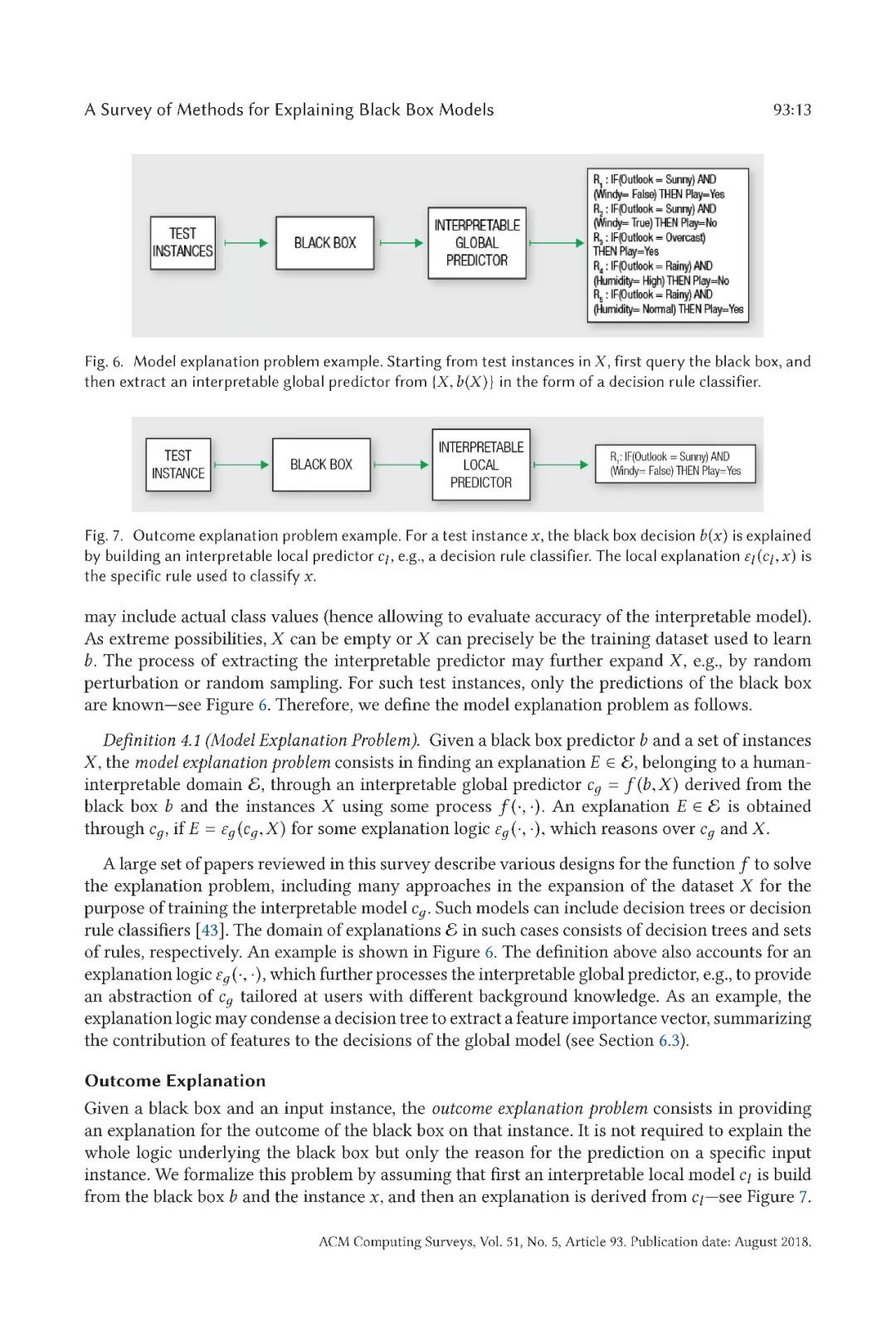

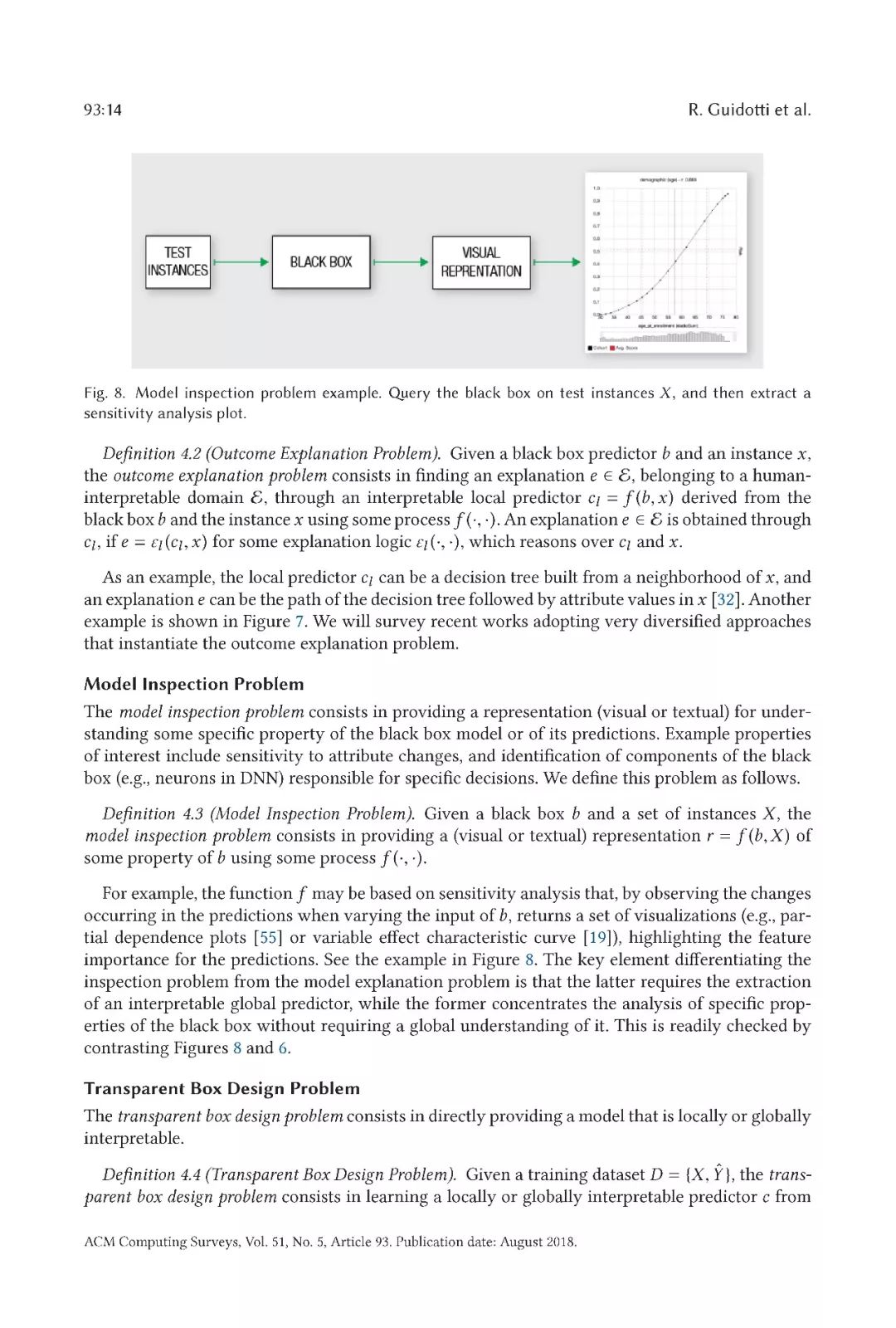

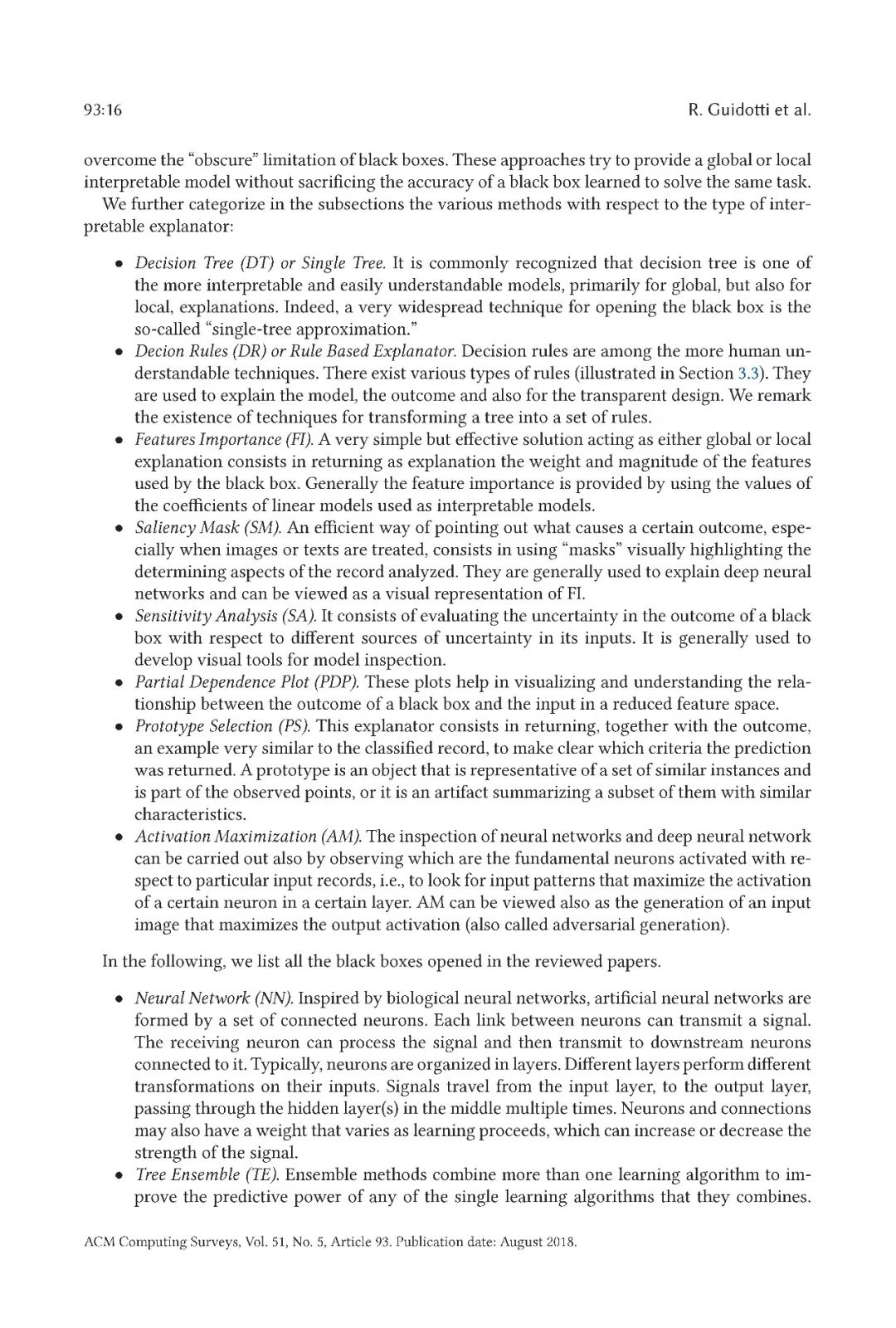

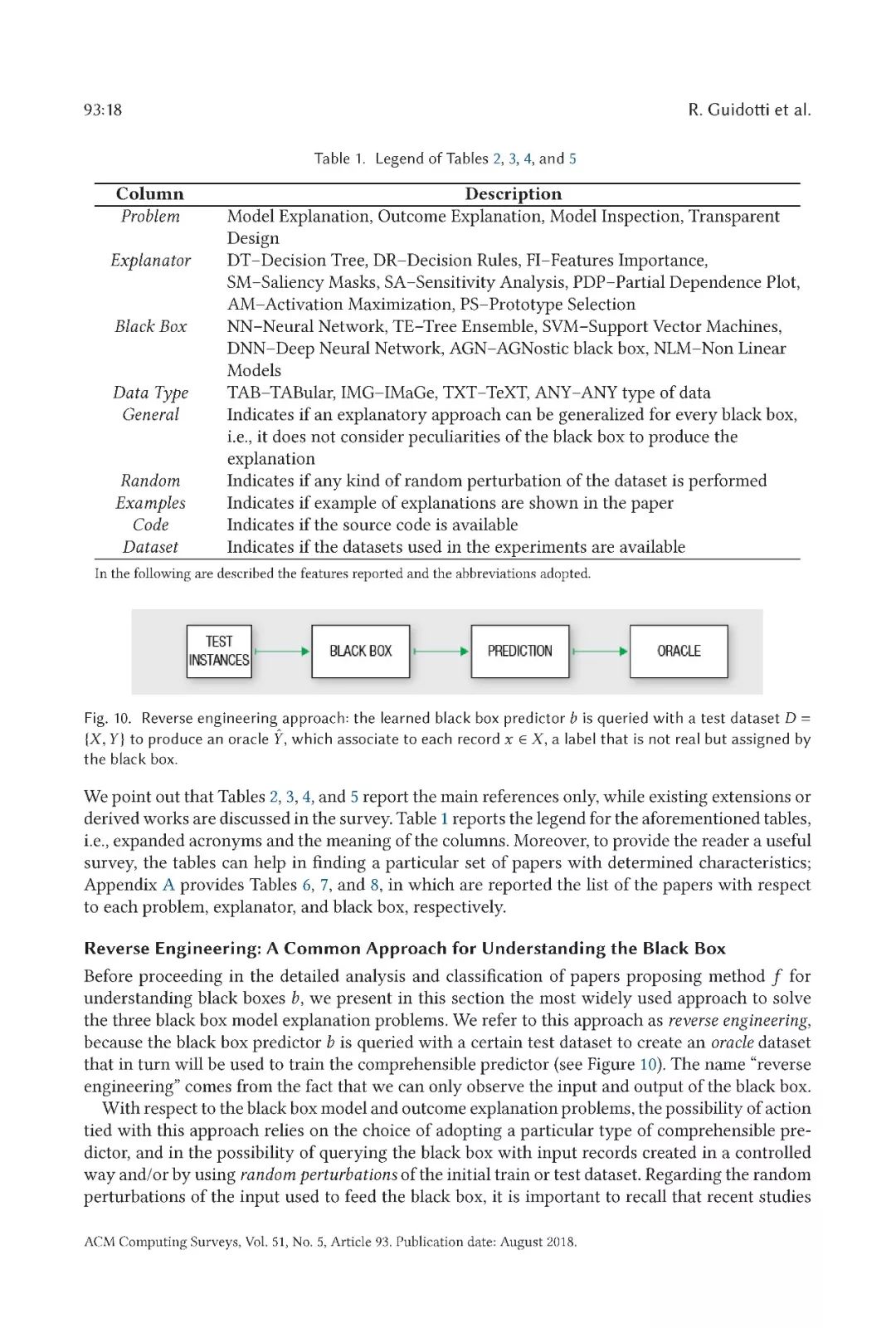

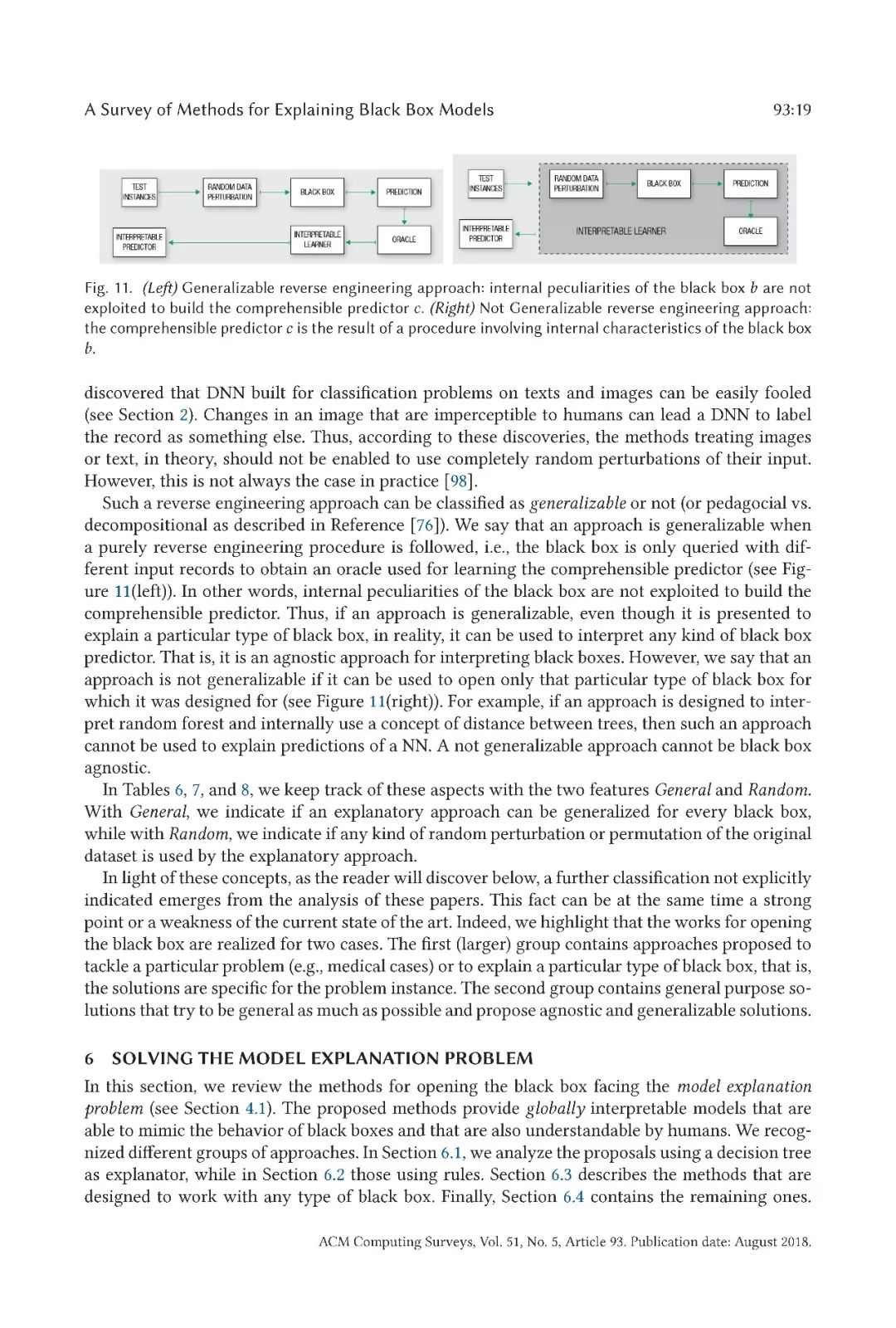

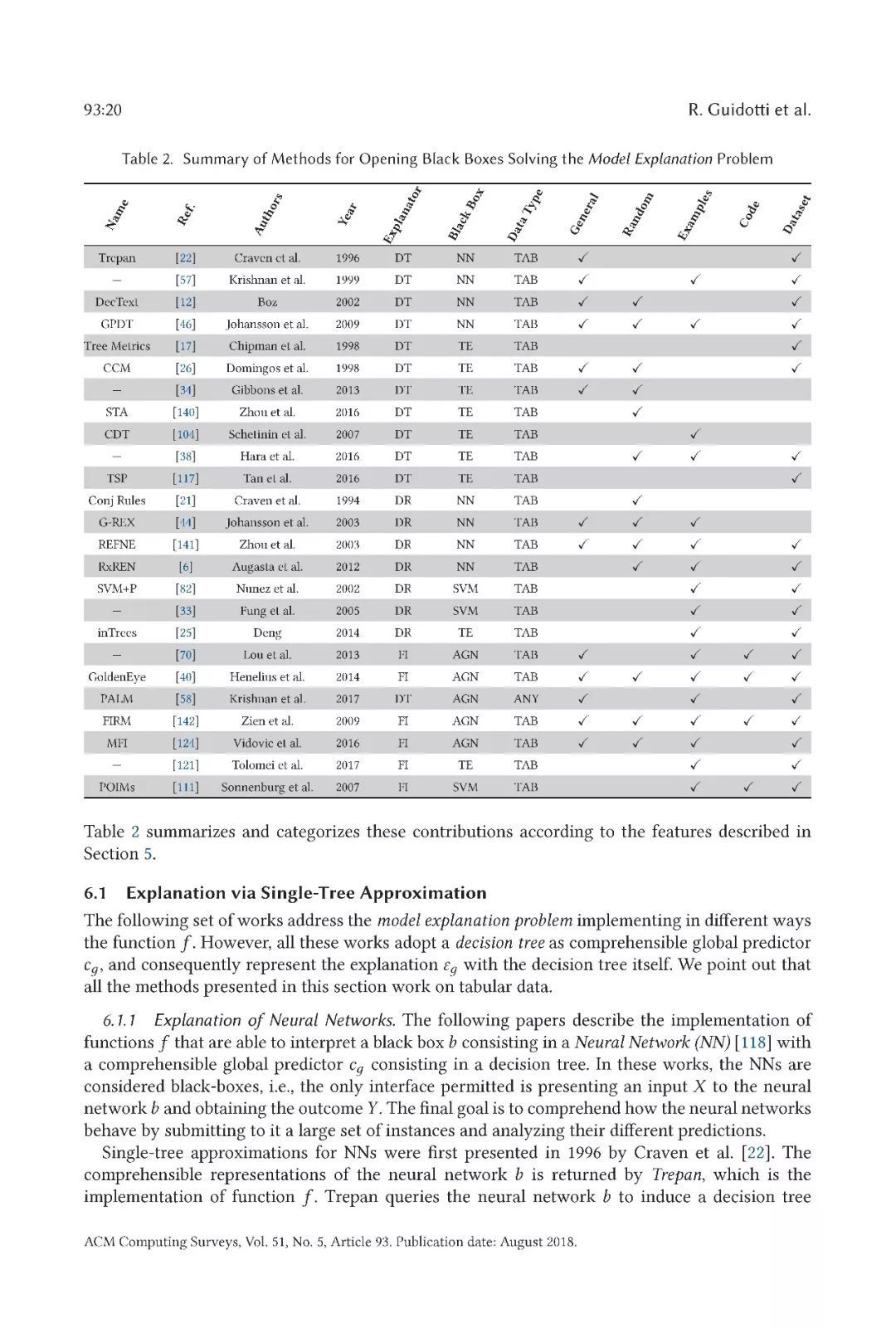

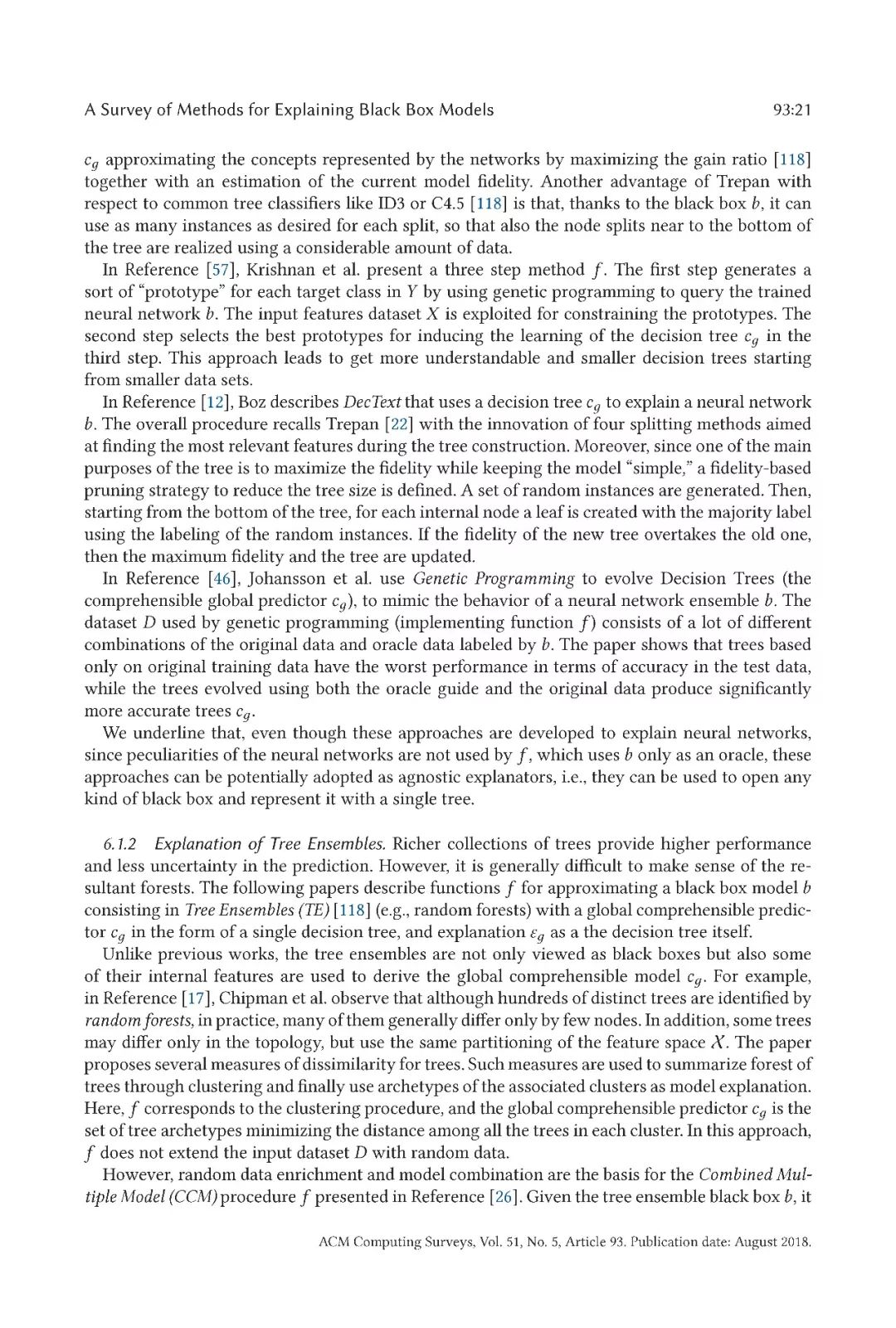

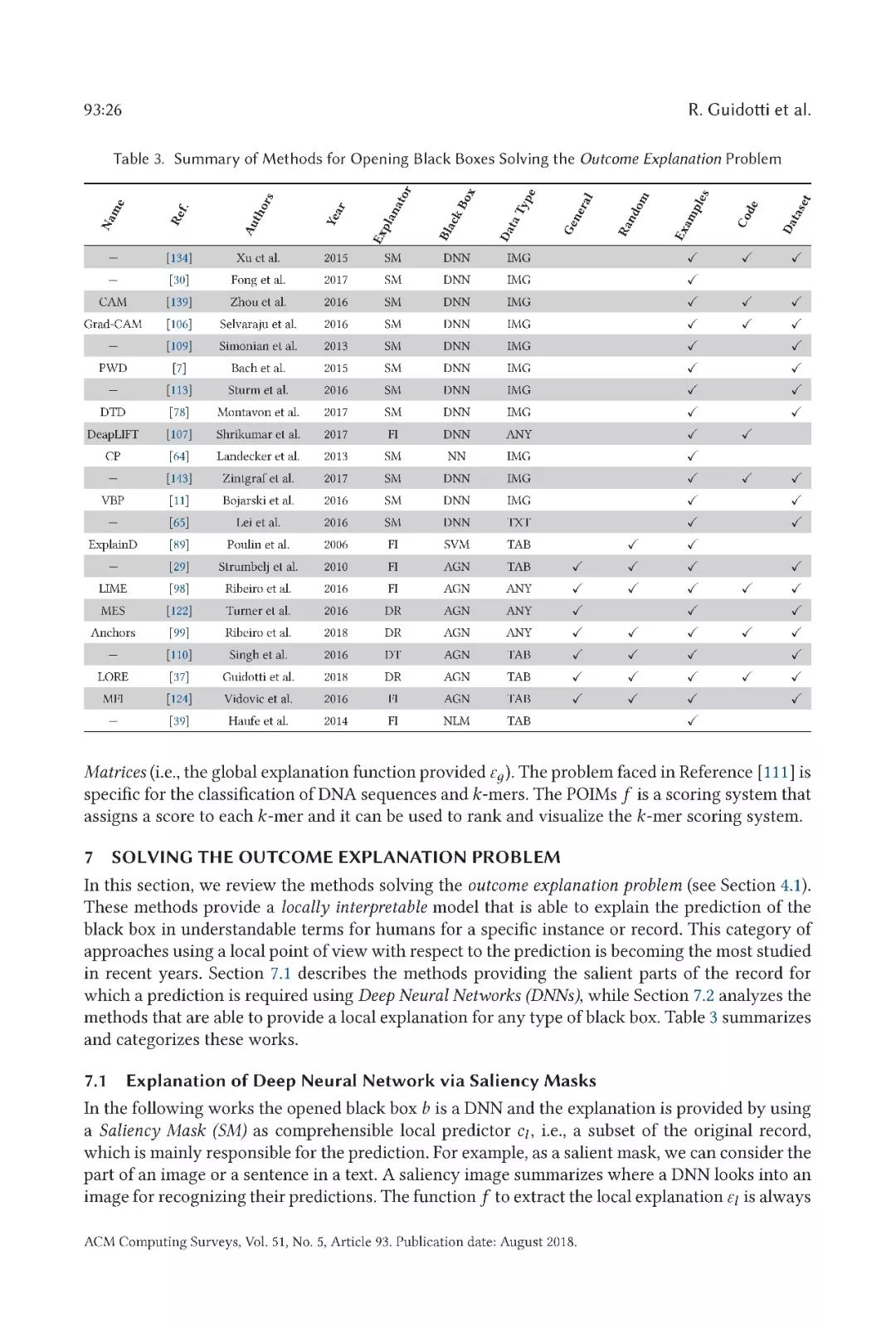

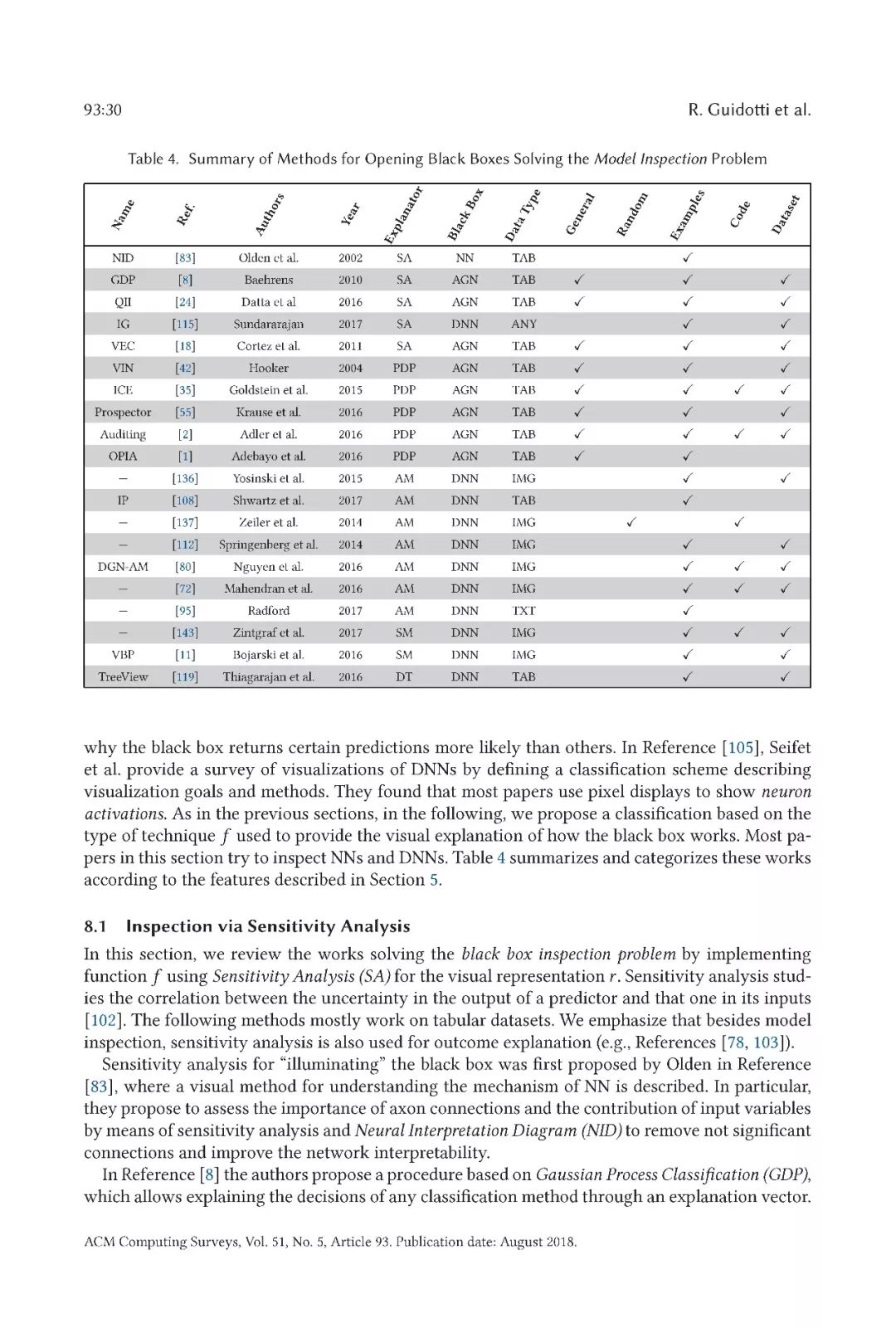

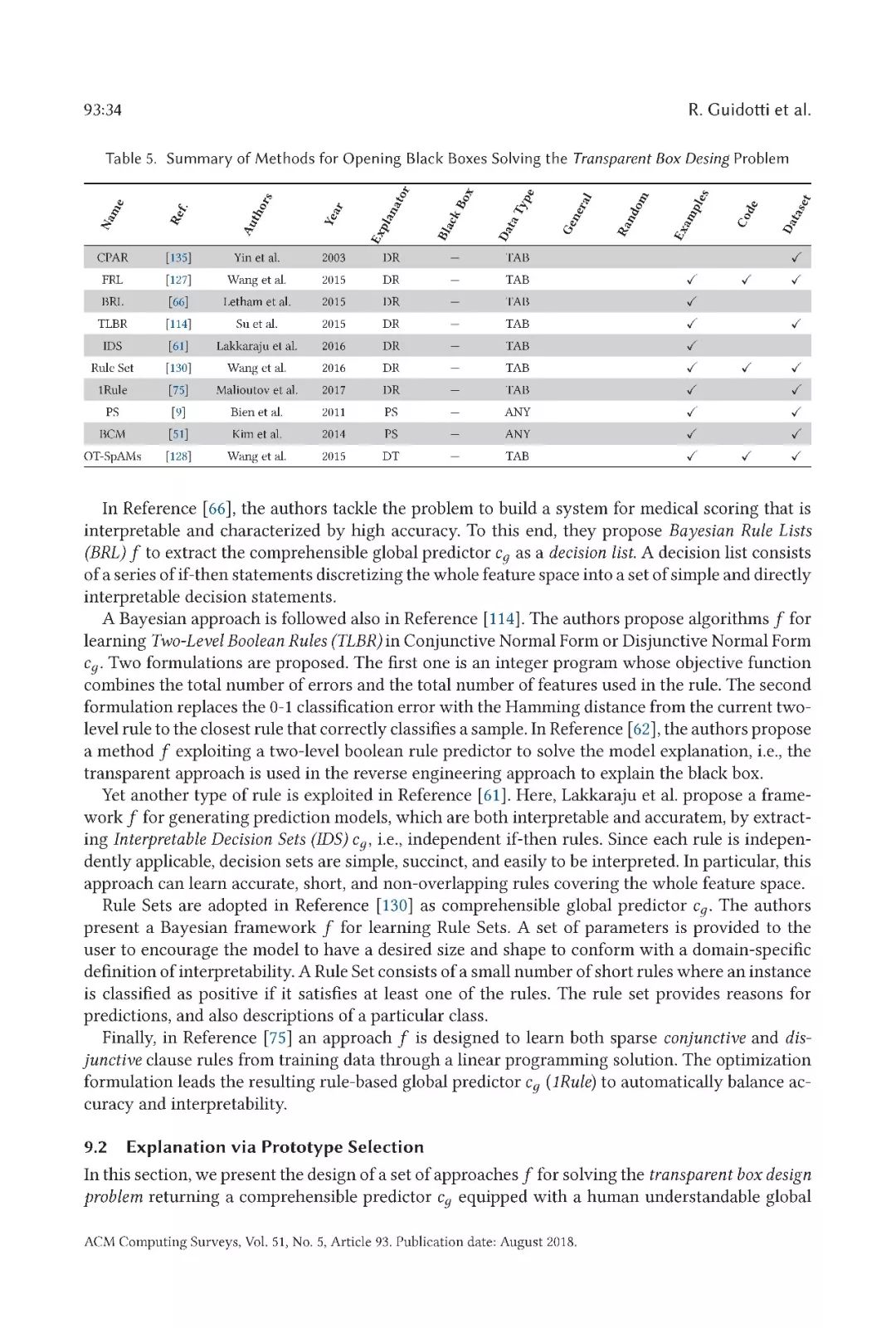

在本文中,我们对文献中提出的用于解释基于不透明和模糊机器学习模型的决策系统的方法进行了全面的概述。首先,我们确定了解释问题的不同组成部分。特别是,我们提供了属于该范畴的每个问题的正式定义,为每个问题捕获了适当的特性。我们将这些黑箱问题命名为:模型解释问题、结果解释问题、模型检查问题、透明箱设计问题。然后,我们提出了文献中研究的方法的分类,这些方法考虑了以下几个方面:解决的具体解释问题,采用的解释器的类型,打开的黑箱模型,以及黑箱模型输入的数据的类型。

文章内容

-

【《大语言模型应用指南》阅读体验】+ 基础篇2024-07-25 621

-

机器学习中的数据分割方法2024-07-10 3945

-

机器学习模型可解释性的结果分析2023-09-28 1685

-

什么是机器学习? 机器学习基础入门2022-06-21 2931

-

机器学习简介与经典机器学习算法人才培养2022-04-28 30384

-

人工智能基本概念机器学习算法2021-09-06 2672

-

阐述机器学习如何与机器学习相互作用2020-07-28 1179

-

机器学习的模型评估与选择详细资料说明2020-03-24 1254

-

基于Eclipse的IDE相关的术语和概念介绍2019-06-10 3611

-

让机器学习模型不再是”黑盒子“2019-03-12 5334

-

从概念和特点上阐述机器学习和深度学习的关系2019-01-24 8907

-

详细阐述机器学习及基本概念2018-07-07 5484

-

《机器学习与数据挖掘:方法和应用》2018-06-27 942

-

【下载】《机器学习》+《机器学习实战》2017-06-01 193845

全部0条评论

快来发表一下你的评论吧 !