探索可解释的人工智能推理

电子说

描述

引言

推理是人类智能活动的重要组成部分,一直以来是人工智能研究的核心内容。人工智能进入了以深度学习技术为主导的新时代, 无论是计算机视觉、语音识别、语言理解、机器翻译、对话系统等,似乎无处不是数据驱动下深度学习的“功劳”。从推理的视角来看,从已知的事实(有标注的数据),得出未知的结论,就是推理。但对智能系统做出的推理结果,需要有一个行为的解释机制。

深度学习是一个黑箱,最大的弊端是缺乏对其结果的解释能力。回想在知识工程时代,基于规则的专家系统技术,其结果却具有很好的解释性。受此启发,我们提出这样一个问题:在解决“可解释”的推理上,传统的知识工程技术是否可以继续发挥作用?可解释的人工智能未来的发展方向是什么?

基于知识工程的可解释推理

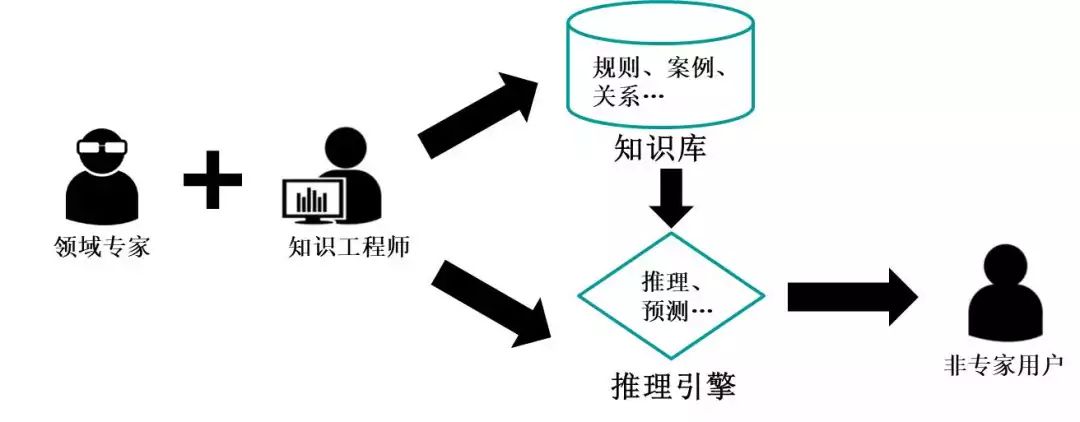

让我们回顾一下人工智能推理的早期阶段——知识工程时代。知识工程包括知识的获取、表达和推理,其本质是将数据转换为易于机器处理的结构化知识。一个典型的专家系统由知识库与推理机组成,前者需要专家人工构建(见图1)。知识工程的代表——专家系统,可以顺着推理机使用到的规则, 表现出很好的解释能力。从20 世纪90 年代后期开始,知识工程因以下一些困扰而进入了低潮。

图1:传统知识工程的组成

1. 知识获取困难。知识库构建过程中依赖专家人工构建的方式。如Cyc[1] 在2000 年,积累了160 万条常识性知识,在耗费了350 人/ 年的成本后最终失败。

2. 构建专家系统需要完备的领域知识(包括常识),对于大部分问题本身具有的不确定性,要从专家的经验中构建推理引擎非常困难,这限制了专家系统的应用。

尽管知识工程这个名词已不再流行,但知识工程将数据转换为易于机器处理的结构化知识的本质,其自顶向下的演绎推理方式可能是解开目前可解释性缺失困扰的途径之一。目前已经出现的一系列研究正在弥补传统知识工程的缺陷,并努力将知识引导与数据驱动这两种知识获取与推理方式进行融合,其中一个典型的代表就是CMU 的永不停息语言学习者NELL[2]。NELL 通过机器学习、NLP 等数据驱动手段并结合人工介入,来从互联网网页中析取断言式知识(beliefs),形成海量的通用知识图谱,这从一定程度上解决了解释性中知识来源的问题,改善了传统知识工程知识获取困难的问题。在基于知识的推理方面,IBM 的Watson 系统[3] 在Jeopardy 挑战中战胜了两位人类冠军,其核心算法Deep QA 通过生成问题答案的候选(假设),在非结构化数据中收集证据,并用机器学习模型对证据进行评分,最后利用聚合算法实现对假设的排序。这种方式借鉴了专家系统中推理引擎的推理流程,实现了数据驱动算法与推理流程的有机融合。图神经网络[4] 等研究也正尝试将传统的贝叶斯网络和知识图谱,与深度学习相融合,来探索深度学习的可解释机制。

未来与展望

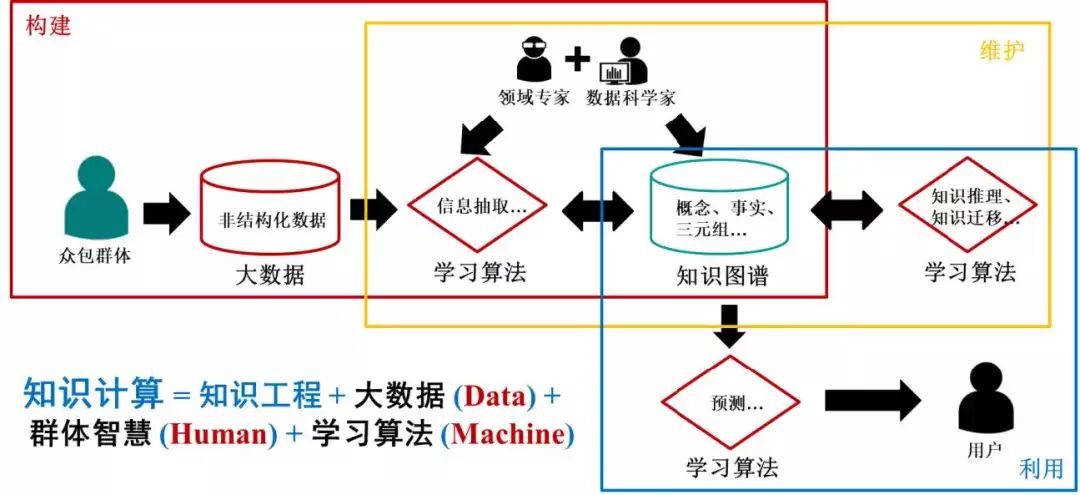

可解释性的问题正在引起各界的关注。2017 年7 月美国国防部高级研究计划署启动了7 000 万美元的可解释性人工智能计划(XAI)[5] 旨在对军事领域智能算法的认知进行理解。欧盟在2018 年生效的通用数据保护法中引入解释的权力[6],旨在处理算法不可解释带来的问题。学术界也正从多个不同的角度入手开展研究,出现了反事实探测[7]、可视化[8]、转移学习[9] 等一系列基于事后解析的方法。在实时分析方面,则出现了多跳注意力[10]、推导过程生成[11],以及可解释性网络[12] 等一系列研究。其中知识计算延续了知识工程的目标,是一种融合实时与事后可解释性分析的计算框架,是传统知识工程与大数据、算法与群体智慧融合后的产物。知识的获取已不单纯依靠从专家的经验中总结出来, 而是综合应用多种“计算”手段而获得的(见图2)。

图2:知识计算框架

知识计算人在回路的架构,为可解释的人工智能的实现提供了框架,是大数据下的新型知识工程。未来在探索可解释的人工智能推理的研究中,我们仍需在此基础上建立知识、数据和反馈于一体的人工智能理论和模型,有机协调“知识指导下的演绎”、“数据驱动中的归纳”与“行为强化内的规划”。 知识工程从提出至今,作为早期的知识推理手段对后续的一系列研究产生了深远的影响,从这个意义上讲,知识工程并没有过时,在未来将继续在人工智能研究中扮演重要的角色。

参考文献

[1] Lenat, D.B., M. Prakash, and M. Shepherd, CYC: Using common sense knowledge to overcome brittleness and knowledge acquisition bottlenecks. AI magazine, 1985. 6(4): 65.

[2] Carlson, A., et al. Toward an architecture for never-ending language learning. in AAAI. 2010. Atlanta.

[3] Ferrucci, D.A., Introduction to “this is watson”. IBM Journal of Research and Development, 2012. 56(3.4): 1: 1-1: 15.

[4] Battaglia, P.W., et al. Relational inductive biases, deep learning, and graph networks. arXiv preprint arXiv:1806.01261, 2018.

[5] Gunning, D., Explainable artificial intelligence (xai). Defense Advanced Research Projects Agency (DARPA), nd Web, 2017.

[6] Goodman, B. and S.R. Flaxman, European Union regulations on algorithmic decision-making and a. 2017.

[7] Ribeiro, M.T., S. Singh, and C. Guestrin. Why should i trust you?: Explaining the predictions of any classifier. in Proceedings of the 22nd ACM SIGKDD international conference on knowledge discovery and data mining. 2016. ACM.

[8] Zeiler, M.D. and R. Fergus. Visualizing and understanding convolutional networks. in European conference on computer vision. 2014. Springer.

[9] Wang, H., et al. Emergent Predication Structure in Hidden State Vectors of Neural Readers. arXiv preprint arXiv:1611.07954, 2016.

[10] Shen, Y., et al. Reasonet: Learning to stop reading in machine comprehension. in Proceedings of the 23rd ACM SIGKDD International Conference on Knowledge Discovery and Data Mining. 2017. ACM.

[11] Ling, W., et al. Program induction by rationale generation: Learning to solve and explain algebraic word problems. arXiv preprint arXiv:1705.04146, 2017.

[12] Zhang, Q., Y.N. Wu, and S.-C. Zhu. Interpretable convolutional neural networks. in The IEEE Conference on Computer Vision and Pattern Recognition (CVPR). 2018.

-

解读人工智能的未来2018-11-14 0

-

人工智能医生未来或上线,人工智能医疗市场规模持续增长2019-02-24 0

-

人工智能上路需要知道什么常识2019-05-13 0

-

人工智能:超越炒作2019-05-29 0

-

路径规划用到的人工智能技术2021-07-20 0

-

人工智能芯片是人工智能发展的2021-07-27 0

-

物联网人工智能是什么?2021-09-09 0

-

可解释的人工智能会加速人们对AI的使用2018-06-08 4465

-

在将可解释的人工智能变成现实之前 需要了解以下四件事2019-05-09 506

-

什么是可解释的人工智能,它的定义如何2020-01-30 6711

-

如何实现可解释的人工智能?2020-09-20 3561

-

人工智能可解释性规制面临的问题分析2022-08-09 1500

-

人工智能未来十年会怎样发展2022-09-22 1659

-

文献综述:确保人工智能可解释性和可信度的来源记录2023-04-28 1315

-

可信人工智能研究方向与算法探索2023-05-24 615

全部0条评论

快来发表一下你的评论吧 !