机器人具有灵敏触觉是怎样的?伯克利提出新型传感器

电子说

描述

我们拥有灵巧的双手,可以在键盘上优雅的舞蹈、可以在摇杆上精确的控制、甚至可以在设备上进行精密的装调,这一切都离不开敏锐准确的触觉。对于机器人来说,仅仅依靠视觉和力传感对于很多复杂任务是远远不够的。没有触觉它们就无法准确感知边缘的位置、表面的强度和接触点的质地,此外很多时候相机的视线还会挡住无法进行视觉伺服。但为机器人赋予优异的触觉感知却不是一件容易的事,科学家们尝试了多种不同的传感器但每一种都有着各自无法克服的缺点。

近日,来自伯克利的研究人员们结合视觉研发出了一种新型的触觉传感器,并通过强化学习算法指导机器人准确的定位并操作目标,在触觉的帮助下实现了精确的控制。为了给机器人提供准确的触觉感知,研究人员利用柔性的硅胶和彩色LED灯制成了基于视觉的触觉传感器。通过采集物体与传感器表面接触造成的色彩变化图像,来获取触觉信息。这种传感器最大的优势在于可以直接通过视觉提供目标的几何信息,并可基于几何信息推断接触力的大小。上图中我们可以明显的看到传感器与管子接触时产生的形变,这种形变与目标外形可力相关,并可以由传感器上灯光色彩的视觉变化准确的反映出来。

这与上图中MIT之前的传感器GelSight十分类似,都是基于光学手段来记录下接触造成的形变。利用这样的传感器可以帮助机器人寻找合适的抓取位置提高抓取成功率。

类似的触觉传感器GelSight

打造触觉传感器

在研究过程中,科研人员将触觉传感器安放到了下图中三轴移动平台的末端执行器上,传感器的接触面朝下以便与被测物体接触。三轴平台可在相对工作平面的xyz方向由步进电机控制移动,在电机精度的帮助下这一平台可以实现0.04mm的粗略精度,可有效地完成一系列精密操作。

传感器被朝下安放在左上方的末端执行器上。

研究人员对下面三个代表性的操作任务进行了研究:1.重置小球位置:机器人通过传感器表面的感知,将金属小球移动到目标位置。难度主要在于对小球的控制力如果不准确的话会造成它脱离传感器和执行器的控制,滚出控制平面。2.操作游戏手柄杆:游戏控制杆是我们进行游戏操作的常见设备,触觉在其中扮演了重要的角色。这一任务的特殊性在于摇动摇杆时需要接触-离开-再接触的移动过程来得到相应的控制。3.滚骰子:这一任务的目标是滚动20面的筛子,在操作过程中十分容易划出操作平面。不过这个任务的好处在于对应的面有数字,可以通过光学传感器看到对应目标面的数字。

三个任务的示意图

上面的三个任务都是通过与触觉相关的视觉目标图像来控制的,这意味着机器人的目标在于操作物体在触觉硅胶面上产生对应的触觉接触图样,机器人基于这一图像感知到物体的三维位姿并推测出需要的力。

深度触觉模型预测控制

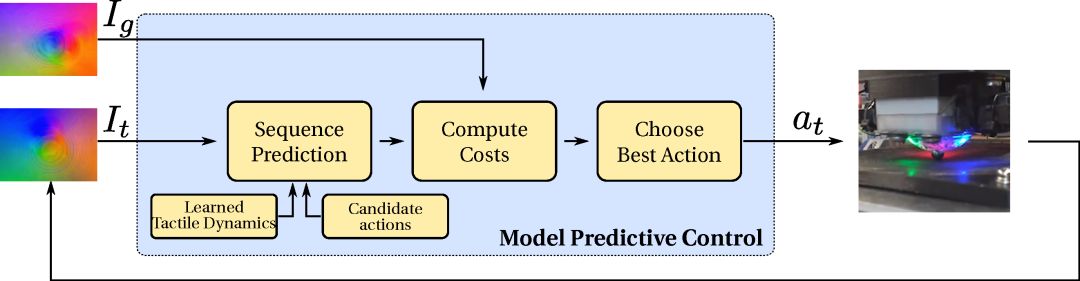

研究人员为了使用高维的图像信息来指导上述的是三个任务,提出了一套通用的强化学习算法——触觉模型-预测控制(tactile MPC)。这套框架建立在先前视觉研究上,通过图像预测任务的路径和目标位置。这三个任务可以使用同一套超参数来完成,无需人工调优的参与。

深度触觉预测控制模型的架构图

触觉算法主要通过行为-条件视觉动力学或自动收集数据上的视频预测模型进行工作。模型从传感器的原始像素中进行学习,基于机器人的预测动作和背景触觉图像就能够预测出未来的触觉图像,无需额外的位置传感器或末端执行器的辅助。

视觉预测模型架构

为了训练一个通用的视觉预测模型,研究人员收集了丰富多样的数据,而这些数据很大程度上是机器人自己收集的。通过一些重置机制保证目标不脱离工作台,机器人可以完全自主的收集数据,记录下瑞吉运动序列的轨迹,以及每一步对应的位置和触觉图样。对于上述的三个任务每一个需要花费36h用于数据收集,但不需要人类的介入。

随机数据的收集

下面展示了模型对于三个任务的表现,输入期望的目标图像模型将输出一系列图像序列轨迹来指导机器人移动。

任务一:滚动小球的操作

任务二:操作游戏摇杆

任务三:滚动筛子

可以看到对于不同的任务可以使用同一套超参数获取达到目标的轨迹序列,证明这套模型具有较强的通用性。研究人员通过这种新型传感器和视觉预测模型的方法解决了机器人控制中的触觉问题,为复杂物体的操作提供了新的思路,未来工作将会拓展到更为复杂的操作任务和通用部件的位置控制及装配上。

-

压电薄膜传感器与倾斜传感器提供灵敏的控制能力2024-04-07 2129

-

工业机器人的触觉传感器有哪些?传感器作用是什么?2024-03-11 2053

-

厦门大学:给机器人穿上灵敏“皮肤”!柔性触觉传感器研究有了重要进展2022-11-17 2304

-

机器人传感器应用2021-09-16 1720

-

加州大学伯克利分校研发可以操控的机器人2019-08-05 1185

-

加州大学伯克利分校的团队给予跳跃机器人更高目标2019-06-13 3929

-

伯克利单腿跳机器人迎来新升级 即将在ICRA2019会议上亮相2019-05-23 3379

-

机器人遭绑架?一男子看不惯在伯克利街道上漫游的送货机器人2019-05-07 3142

-

UC伯克利新机器人成果:灵活自由地使用工具2019-04-15 2970

-

推特公开宣布了伯克利机器人学习实验室最新开发的机器人BLUE2019-04-13 5039

-

机器人传感器的类别和应用原理2018-11-08 2781

-

机器人传感器2018-01-03 3631

-

智能机器人对于传感器的需求2015-01-20 6542

全部0条评论

快来发表一下你的评论吧 !