FAIR何恺明、Ross等人最新提出实例分割的通用框架TensorMask

电子说

描述

FAIR何恺明、Ross等人最新提出实例分割的通用框架TensorMask,首次在定性和定量上都接近于 Mask R-CNN 框架,为探索密集实例分割方法提供基础。

现代实例分割方法主要是先检测对象边界框,然后进行裁剪和分割, Mask R-CNN 是目前这类方法中最优秀的。

近日,来自 FAIR 的陈鑫磊、Ross Girshick、何恺明、Piotr Dollar 等人发表一篇新论文“TensorMask: A Foundation for Dense Object Segmentation”,从一个新的方向解决实例分割问题,并提出了一个名为 TensorMask 的通用框架。

论文地址:

https://arxiv.org/pdf/1903.12174.pdf

作者表示,TensorMask 达到了与 Mask R-CNN 相当的结果,有助于更全面地理解这项任务。

Ross Girshick、何恺明、Piotr Dollar 三人也是 Mask R-CNN 的作者,一作陈鑫磊博士毕业于 CMU,导师是 Tom Mitchell 教授,并曾在谷歌云 AI 李飞飞、李佳的指导下实习。

TensorMask:将实例分割视为4D张量预测

在密集、规则的网格上生成边界框对象预测的滑动窗口目标检测器 (sliding-window object detectors) 已经得到迅速发展,并得到了广泛的应用。

与此相反,现代的实例分割方法主要是先检测对象边界框,然后进行裁剪和分割,Mask R-CNN 推广了这种方法。

在这项工作中,我们研究了密集滑动窗口实例分割 (dense sliding-window instance segmentation) 的范例,令人惊讶的是,这方面的研究十分不足。

我们的核心发现是,这项任务与其他的密集预测任务 (如语义分割或边界框对象检测) 有本质的不同,因为每个空间位置的输出本身就是一个几何结构,具有自己的空间维度。

为了形式化地说明这一点,我们将密集实例分割视为一个 4D 张量 (4D tensors) 的预测任务,并提出了一个名为 TensorMask 的通用框架,该框架显式地捕获这种几何图形,并支持对 4D tensors 使用新的操作符。

图 1:TensorMask 的输出。我们将密集实例分割作为一种基于结构化 4D 张量的预测任务。除了获得具有竞争力的定量结果,TensorMask 还获得了定性上合理的结果。图中小的和大的物体都被很好地描绘出来,并且,重叠的物体也被正确地处理了。

我们证明了 tensor 这种想法可以相比 baseline 获得较大的增益,并且可以得到与Mask R-CNN 相当的结果。这些结果表明, TensorMask 可以作为密集掩码预测的新进展的基础,有助于更全面地理解这项任务。我们将发布本研究的代码。

弥补差距:实例分割中的密集方法

滑动窗口 (sliding-window) 范例 —— 通过查看放置在一组密集图像位置上的每个窗口来查找对象 —— 是计算机视觉中最早、也是最成功的概念之一,并且这个概念自然地与卷及网络相关。

然而,尽管目前性能最好的对象检测器依赖于滑动窗口预测来生成初始候选区域,但获得更准确的预测主要来自对这些候选区域进行细化的阶段,如 Faster R-CNN 和 Mask R-CNN,分别用于边界框目标检测和实例分割。这类方法已经主导了 COCO 目标检测挑战赛。

近年来,诸如 SSD 和 RetinaNet 之类的边界框目标检测器,避开了 “细化” 这个步骤,专注于直接的滑动窗口预测,已经有了复苏的趋势,并显示出有希望的结果。

相比之下,该领域在密集滑动窗口实例分割方面并没有取得同等的进展;对于 mask prediction,没有类似于 SSD / RetinaNet 这样的直接、密集的方法。

为什么密集的方法在边界框检测方面进展迅速,而在实例分割方面却完全缺失?这是一个基本科学上的问题。这项工作的目标就是弥补这一差距,并为探索密集实例分割方法提供基础。

我们的主要观点是,定义 dense mask representations 的核心概念,以及这些概念在神经网络中的有效实现,都是缺乏的。

与边界框不同,边界框具有固定的低维表示而不考虑比例,分割掩码 (segmentation masks) 可以从更丰富、更结构化的表示中获益。例如,每个 mask 本身是一个 2D 空间映射,较大对象的 mask 可以受益于较大空间映射的使用。为 dense masks 开发有效的表示是实现密集实例分割的关键步骤。

为了解决这个问题,我们定义了一组用高维张量表示 mask 的核心概念,这些概念允许探索用于 dense mask prediction 的新颖网络架构。为了证明所提出的表示的优点,我们提出了几个这样的网络并进行了实验。

我们的框架称为 TensorMask,它建立了第一个密集滑动窗口实例分割系统,其结果接近于 Mask R-CNN。

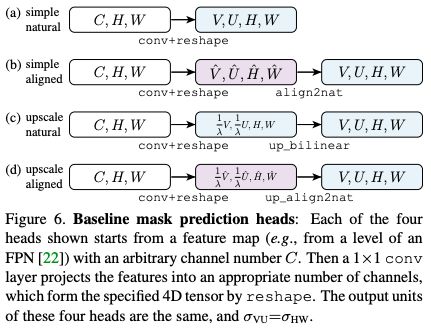

左:自然表示。右:对齐表示 (Aligned representation)。

TensorMask 表示的核心想法是使用结构化的 4D tensors 表示空间域上的 mask。

与以前的面向通道的方法不同,我们建议利用形状 (V, U, H, W) 的 4D tensors,其中(H, W) 表示目标位置,(V, U) 表示对应的 mask 的位置,它们都是几何子张量,也就是说,它们的轴有明确定义的 units 和关于图像的几何意义。

这种从非结构化通道轴上的 encoding masks 到使用结构化几何子张量的视角转变,使得定义新的操作和网络架构成为可能。这些网络可以以几何上有意义的方式直接作用于(V, U) 子张量,包括坐标变换、up-/downscaling 和金字塔的使用。

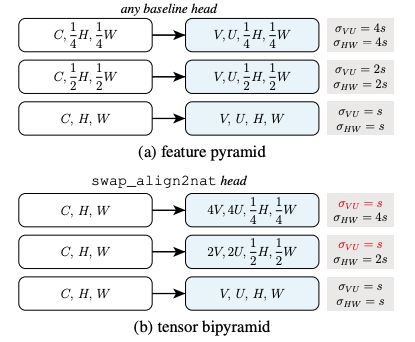

在 TensorMask 框架的支持下,我们在一个 4D tensors 的标度索引列表上建立了一个金字塔结构,我们称之为张量双金字塔 ( tensor bipyramid)。与特征金字塔类似,tensor bipyramid 是一个多尺度特征映射列表,它包含一个形状为 2kV、2ku、12kh、12kw 的 4D 张量列表,其中 k≥0 个索引尺度。这种结构在 (H, W) 和 (V, U) 几何子张量上都呈金字塔形状,但方向相反。这种设计捕捉了大对象具有粗糙空间定位的高分辨率 mask(大 k) 和小对象具有精细空间定位的低分辨率 mask(小 k) 的理想特性。

feature pyramid 和 tensor bipyramid 的比较

我们将这些组件组合成一个网络骨干和训练程序,类似 RetinaNet,其中我们的 dense mask predictor 扩展了原始的密集边界框预测器。

通过详细的消融实验,我们评估了 TensorMask 框架的有效性,并证明了明确捕捉该任务的几何结构的重要性。最后,我们展示了 TensorMask 与对应的 Mask R-CNN 产生了相似的结果 (见图 1 和图 2)。

TensorMask的架构

TensorMask 框架的核心思想是使用结构化的高维张量来表示一组密集滑动窗口中的图像内容 (例如 masks)。

图 2:使用 ResNet-101-FPN 骨干的 TensorMask 和 Mask R-CNN 的示例结果 (与图 6中使用的 Mask R-CNN 的图像相同)。结果在定量和质量上都很相似,表明密集滑动窗口范式确实可以有效地用于实例分割任务。请读者猜猜哪些结果是 TensorMask 生成的(答案见文末)。

TensorMask架构

我们已经展示了采用 TensorMask representations 的模型。这些模型有一个在滑动窗口中生成 masks 的 mask prediction head,以及一个用于预测对象类别的classification head,类似于滑动窗口目标检测器中的 box regression 和 classification heads。

实验和结果

我们报告了 COCO 实例分割的结果。所有的模型都在 ~118k train2017 图像上进行训练,并在 5k val2017 图像上进行测试。最终结果在 test-dev 上。我们使用 COCO mask 的平均精度 (用 AP 表示)。box AP 用 APbb 表示。

TensorMask 表示

首先,我们研究了使用 V =U=15 和 ResNet-50-FPN 骨干的 mask 的各种张量表示。表2 报告了定量结果,图 2 和图 9 显示了定性比较。

表2

与 Mask R-CNN 的比较

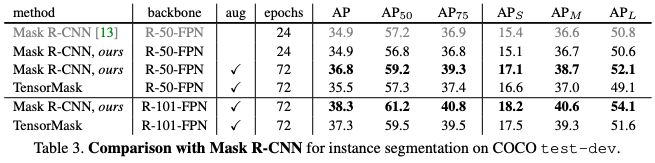

表 3 总结了 test-dev 上最好的 TensorMask 模型,并将其与当前用于 COCO 实例分割的主流方法 Mask RCNN 进行了比较。

表3

如上表所示,最好的 TensorMask 在 test-dev 上达到了 35.5 mask AP,接近于 mask R-CNN 的 36.8。

在 ResNet-101 中,TensorMask 实现了 37.3 mask AP,与 mask R-CNN 相比只有 1.0 AP 差距。

这些结果表明,密集滑动窗口方法可以缩小与 “先检测后分割” 方法的差距。定性结果如图 2、10、11 所示。

结论

TensorMask 是一个 dense sliding-window 实例分割框架,首次在定性和定量上都接近于 Mask R-CNN 框架。TensorMask 为实例分割研究建立了一个概念互补的方向。

(图2答案:第一行是Mask R-CNN的结果,第二行是TensorMask的结果。)

-

图像分割基础算法及实现实例2017-12-18 9636

-

何恺明、Ross Girshick等大神深夜扔出“炸弹”:ImageNet预训练并非必须2018-11-24 7013

-

FAIR何恺明团队最新论文提出“全景FPN”,聚焦于图像的全景分割任务2019-01-11 6848

-

李飞飞等人提出Auto-DeepLab:自动搜索图像语义分割架构2019-01-15 4396

-

何恺明等人再出重磅新作:分割任务的TensorMask框架2019-04-04 4677

-

FAIR何恺明团队近日发表神经结构搜索NAS方面的最新力作2019-04-19 4228

-

Facebook AI使用单一神经网络架构来同时完成实例分割和语义分割2019-04-22 3447

-

什么是图像实例分割?常见的图像实例分割有哪几种?2021-06-17 27661

-

深度学习部分监督的实例分割环境2021-10-21 2333

-

用于实例分割的Mask R-CNN框架2022-04-13 3464

-

基于X光图片的实例分割垃圾数据集WIXRay (Waste Item X- Ray)2022-08-08 2548

-

用于弱监督大规模点云语义分割的混合对比正则化框架2022-09-05 2025

-

基于通用的模型PADing解决三大分割任务2023-06-26 1255

-

基于SAM实现自动分割遥感图像实例2023-07-06 3033

全部0条评论

快来发表一下你的评论吧 !