深度学习、CNN越来越火热,这种热度能够持续多久?

电子说

描述

本文介绍了LeCun和居里夫人、以及原子发展和AI发展的共通之处,试图回答:人工智能处于何种发展阶段、是否会有危险、以及Yann Le Cun是新的Richard Feymann,还是新的Marie Curie,或两者兼而有之?

深度学习、CNN越来越火热,原因之一是它取得了很多令人瞩目的成就。不过,这种热度能够持续多久?深度学习是否在未来几年仍然能够推动人工智能呈指数级增长?恐怕需要我们仔细去思考一下。

美国未来研究院主席罗伊·阿马拉有一条著名的阿马拉定律:“我们倾向于过高估计技术在短期内的影响,而低估它的长期效应”。

所以,深度学习到底是被高估还是低估,就得搞清楚目前深度学习和人工智能发展到了什么程度,站在哪个阶段上。

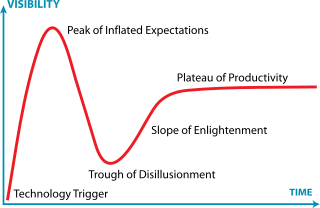

Gartner热度循环曲线

上图中的曲线反应了一项技术在5到10年内关注度的变化,可供企业用来评估该项技术的发展阶段,从而决定是否采用该技术、何时使用等。不过人工智能不仅仅是一项应用于企业的技术,同时是一个独立的科学领域,它的热度周期可能长达50到100。

观察人工智能发展走向的一种方法是将其看做是人类对自我认知的理解,对人类学习系统的探索。从这个角度切入,就可以将我们在人工智能领域的发现,与过去的科学发现进行比较,特别是那些与复杂系统有关的发现:太阳系,进化,电力…以及,原子。

接下来,我们来通过解答一个有趣的问题来尝试揭开当前人工智能的发展阶段,以及30年后我们的后代回顾历史会对现在我们做的事情做出何种评价:天真?还是危险?

这个问题就是:深度学习大牛、CNN之父Yann Le Cun是AI领域的费曼,还是居里夫人,或两者兼而有之?

核物理简史

要解答上述问题,需要对核物理的历史做一个简单的梳理。

研究铀盐磷光现象的Becquerel于1897年偶然发现了铀的放射性,铀被光照后拥有了发射X射线的能力,接着他很快就发现铀不需要外部能源也能发射X射线。之后居里夫人更精心地研究了放射性,并研究了除铀以外的其他天然放射性化合物。

放射性的发现引起了公众的热情;与此同时,放射性是一种新的现象,需要通过理论研究和对原子本身的更好理解来解释。

爱因斯坦在1905年提出了著名的质能等价理论,卢瑟福在几年后通过实验用电子轰击金属板,确定了原子的第一个模型:有核和电子轨道。

这个不完整的原子模型一直沿用了15年。直到1928年现代普遍接受的“自旋”模型的出现,以及1935年强核力理论的提出。

在强核力理论提出4年后,放射性元素第一次落地应用,科学家使用同位素成功进行了癌症化疗;随后,1942年建立了第一个研究核反应堆,1956年建成第一座全规模核能发电厂。

从1897年发现发射线元素,到成功实现落地应用,历时近半个世纪。

人工神经网络是如何开始的

神经网络的概念很早就有了,最初的动机是编写一种模仿突触行为的算法。在1957年讨论了第一个感知器,1965年讨论了第一个多层感知器。

而那个时候的计算机刚刚开始发展,速度非常慢,最简单的网络也得数天才能训练完毕,效率极其低下,因此在接下来的十几年都没有被大量使用。

第一个转机出现在1974年,Werbos发现了反向传播。反向传播使用了神经网络操作具有差异性和可投射性的特点,当网络出错时,可以将错误本身回溯到网络的各层,以帮助它自我纠正。从某种意义上说,它是我们今天称之为深度学习的开始。

几年后,Kunihiko Fukushima推出了Neocognitron,灵感来自视觉皮层中感知细胞的工作模式。有了Neocognitron,才有了后来广为人知的CNN。

神经网络的重大发展,源自算力的提升,这要感谢现代GPU、TPU等。

Yann Le Cun:让人工智能看到了一束光

在Yann Le Cun将神经网络第一次落地之前,AI正在经历漫长的寒冬期。

Yann Le Cun通过反向传播和CNN来识别用于邮件路由的邮件上的邮政编码,虽然结果喜人,然而距离深度学习成为主流还需要20年左右的时间。

三个G:Google,GAN和GPU

2014年,Ian Goodfellow与蒙特利尔大学的同事们在酒吧里激烈争吵。有关自动生成逼真图像的能力以及如何教导神经网络做到这一点。喝大了的Ian诞生了一个疯狂想法,让两个神经网络互殴,第一个网络生成图像,第二个网络“调教”第一个。

现在仍然不清为什么让两个神经网络并行运行会有效,这个问题仍然亟待解决。GAN是过去几年出现的有关机器学习的一个例子,但其他包括:

学习(可解释以及好奇心)人工智能系统本身缺乏好奇心,不会学到新东西,缺乏可解释性

深度双重Q-Learning(DDQN),深度学习网络尝试去学会一个策略(例如,玩Atari Pong)。两个网络分别评估特定步骤是否智能和相互关联的结果

YOLO(You Look Only Once)对象检测算法,以奇怪的方式检测图像中的对象,但速度超快

回顾有关人工智能的各种概念的提出,例如反向传播、CNN、GAN,RNN,LTSM等,可以和原子的发展历程进行类比。

Atom和Deep Learning / AI

30年后的人工智能

未来很难预测,不过可以通过根据过去的科学发现,尝试做出一些假设,并找出真正在AI上取得重大进展需要做些什么:

更多理论:人工智能现在阶段,类似自旋模型出现之前的阶段。

也许未来可能建立一个适用的学习理论,其中包含驱动因素(如好奇心,概括能力等),并将这些概念融合在一起

更多工业化:工程领域需要通用以及可重用的组件。这一点已经从核工业中得到证实。在深度学习中,嵌入和可重用的表示正在成为一种趋势

更多落地商用:人工智能目前主要在虚拟世界、而非真实世界中运行,这限制了它的一些实际应用。一些新出现的概念,例如“数字孪生工厂”,人工智能可以在其上运行并进行优化的见解

更多硬件:放射性是在建造静电计的时候偶然发现的。而AI是在当前硬件(包括GPU和TPU)上开发的,所以,未来可能需要量子计算机

如果至少上述任何两个“预测”都成为现实,30年后当我们的后代回顾21世纪初的深度学习研究领域是,可能会说:是的,也许Yann Le Cun是AI领域的居里夫人!

-

IC datasheet为什么越来越薄了?2024-03-06 4759

-

嵌入式会越来越卷吗?2024-03-18 8974

-

新人报道,祝论坛越来越旺2012-04-02 1545

-

蓝牙技术越来越鸡肋2012-09-16 2361

-

为什么红外热像仪越来越受欢迎2014-09-12 3138

-

大功率开关电源并联均流为什么越来越流行?2016-04-07 4863

-

为什么RF滤波器越来越重要?2019-07-30 1389

-

极光64b66b中S_AXI_TREADY越来越低2020-03-31 1755

-

labview实现深度学习,还在用python?2020-07-23 3340

-

USB产品的应用越来越广泛,USB仪器逐步确立主流地位2021-05-12 1285

-

在仿真电路中的INL为什么越来越差?有人知道问题大概在哪里吗2021-06-24 1929

-

MCU和MPU之间的区别变得越来越模糊2021-11-01 1293

-

什么是深度学习?使用FPGA进行深度学习的好处?2023-02-17 2009

-

未来的智能住宅计划正在慢慢变得越来越可行2018-05-18 7299

-

随着智能家居概念越来越火热,中国智能门锁产业也被推到了风口浪尖2018-09-22 1687

全部0条评论

快来发表一下你的评论吧 !