ACL 2019 论文接收结果终于放榜!

电子说

描述

ACL 2019录取结果今天放榜了!就投稿数量来说,这是历史上最火的一届NLP顶会,有效投稿达到2694篇,相比去年的1544篇增加了75%。此外,本届ACL的评审质量也受到颇多吐槽。你的论文入选了吗?

今天,ACL 2019 论文接收结果终于放榜!

尽管录取率尚未公布,不过就投稿量来说今年 ACL 大会规模是史上最大的,录取难度应该不小。

2018-2019 对于 NLP 领域无疑是一个突破性进展的时期,作为 NLP 领域的学术顶会,今年 ACL 的论文备受关注。

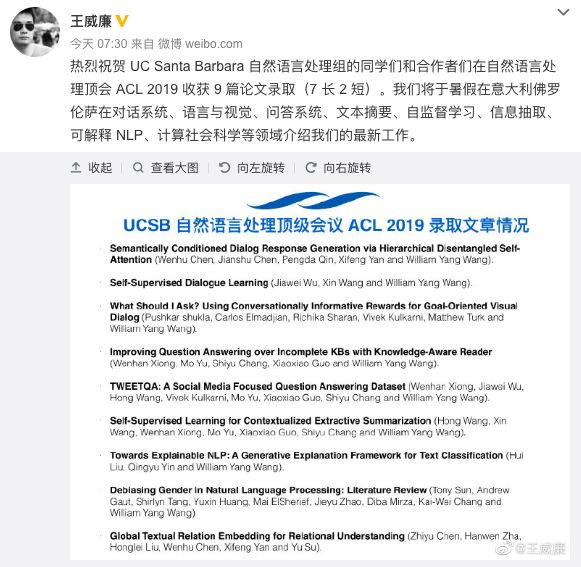

推特上已经有许多作者欢欣鼓舞自己的论文 “中了!” 比如加州大学圣芭芭拉分校王威廉老师所在的自然语言处理组有 9 篇论文被录取。王威廉也是 ACL 19 机器学习的领域主席。

UC Santa Barbara 自然语言处理组 9 篇论文录取

本文将列举一些被接收的论文,供大家参考。

今年以来,几乎所有 AI 顶会都报告了创纪录的论文提交数量,包括 AAAI、ICLR、IJCAI 等等。

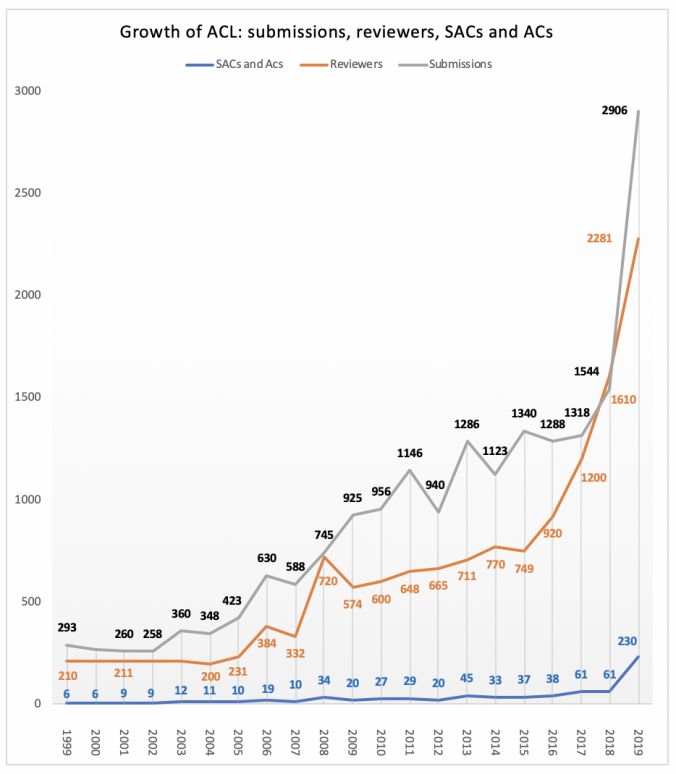

NLP 领域今年尤其火爆,ACL 2019 出现了史上最大的增长:论文提交数量飙升到 2906 篇,其中有效提交 2694 篇,相比 2018 年的 1544 篇,增长了 75%!

下图显示了 ACL 在过去 20 年里的论文投稿情况,包括提交数、评审人数和 SAC 和 AC 的人数。

无疑,这是有史以来最火、规模最大的一次 NLP 会议。

在介绍 ACL 2019 录用论文之前,让我们先看看今年 ACL 的一些数据。

有效投稿2694篇,中美投稿最多

截止到提交截止日期,ACL 2019 收到了多达 2906 份提交论文。这比 ACL 2018 增加了 75% 以上,是ACL 相关会议的历史记录!

一下是一些基本的统计数据:

2906 篇提交论文中,有 120 篇被作者撤回,92 篇因重复提交、剽窃或不符合提交准则等问题而被拒绝。

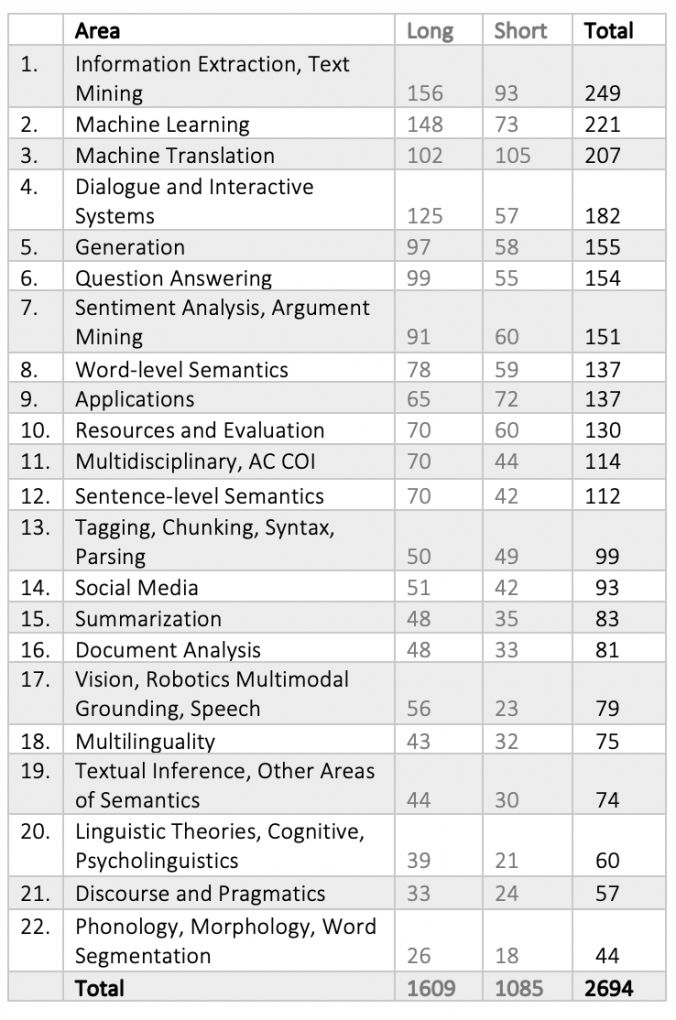

送交评审的是一共2694 篇有效论文,包括 1609 篇长论文和 1085 篇短论文。

每篇论文被分配到 22 个领域中的其中一个进行评审。每个区域由 2-4 名高级领域主席 (SAC) 领导,以及 3-15 位区域主席 (AC) 协助。取决于提交论文的数量,不同领域有 59-319 名审稿人。今年 ACL 的项目委员会共有 2256 人:46 位 SAC, 184 位 AC,以及 2026 位审稿人。

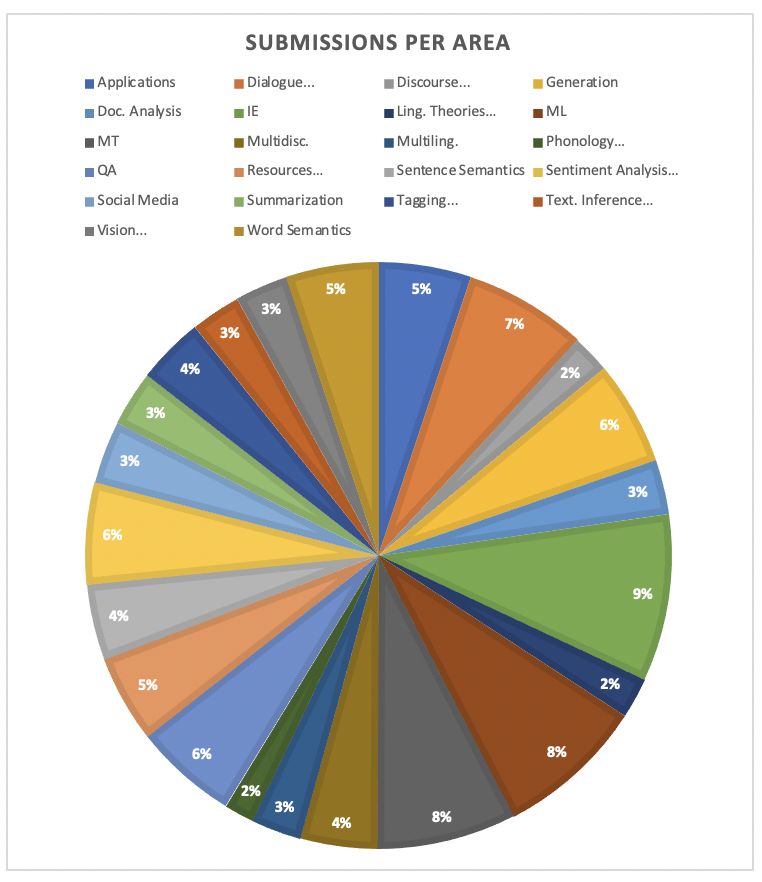

下表显示了每个领域的提交数量 (长论文、短论文和总数)。

其中,投稿最多的 3 个领域与 ACL 2018 相同:

信息提取和文本挖掘(占所有有效提交的 9.2%,ACL 2018 的这一比例为 11.5%。不过,由于今年的会议增加了一个 “应用” 领域,百分比不完全具有可比性)

机器学习(占比 8.2%,2018 ACL 为 7.4%)

机器翻译(占比 7.7%,ACL 2018 为 8.3%)

此外,对话和交互系统也进入了前 5 大领域。

不过,去年排名第四的文档分析,今年只排在第 16 位,而去年排名第 14 位的 Generation (去年收到 59 篇投稿),今年排到了第 5 位,收到 156 篇投稿。

另一个令人惊讶的是语言学理论、认知建模和心理语言学,这个领域显然越来越受欢迎:去年投稿数是 24 篇,今年增加到 60 篇。

下图展示了所提交的论文在不同子领域的占比。

论文长度方面,今年的投稿中 60% 是长论文,而去年 66% 是长论文。所以今年短论文更受欢迎。各个子区域的情况如下:

显然,短论文比长论文更受欢迎的领域只有一个:应用。

这两种类型的论文在机器翻译和标记、分块、语法、句法分析这几个子领域的数量接近。

最喜欢长篇论文的领域包括机器学习、视觉、机器人多模态基础、语音、对话和交互系统 (超过 65% 是长论文)。

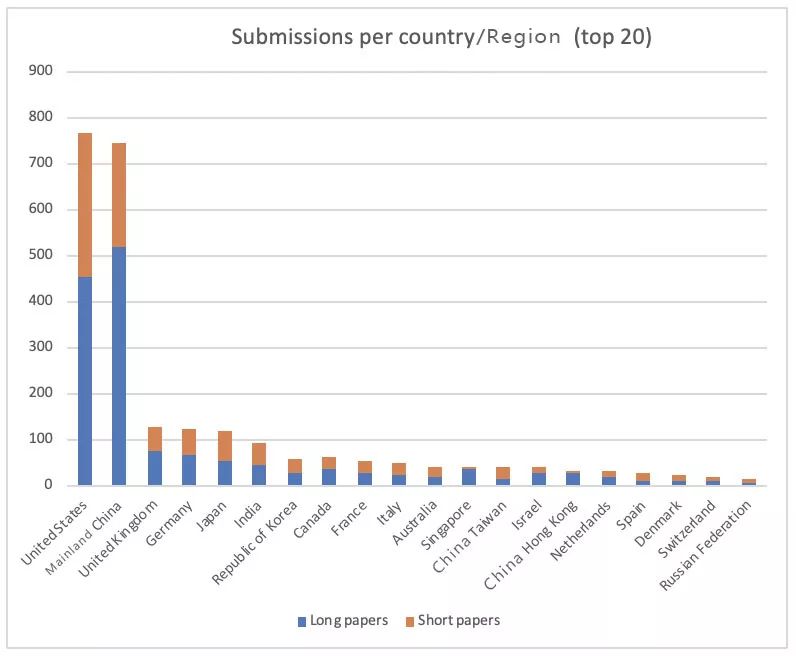

最后,关于论文的地理分布,今年 ACL 收到了来自 61 个国家的论文。

只考虑通讯作者的国家的话,不出所料,美国和中国内地的投稿数量领先,投稿数量分别都超过了 700 篇。英国和德国分别以 129 篇和 126 篇排名第三和第四,日本紧随其后 (120 篇)。

投稿数量Top 20的国家/地区

审稿质量好坏参半,没有rebuttal环节

如此巨大的投稿量,审稿质量控制又是一大难题。

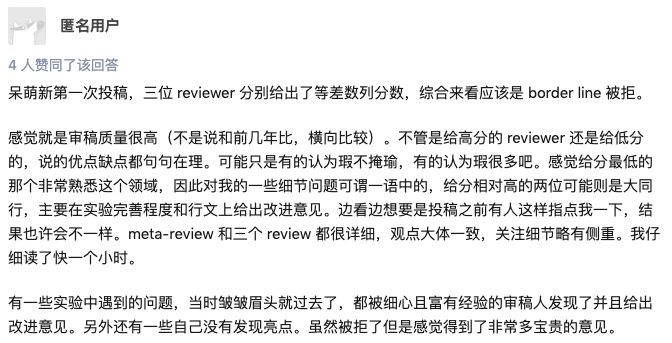

不过,相比 IJCAI 2019 被吐槽 “宇宙最烂” 的评审质量,奇葩审稿太多而登上知乎热榜,这次知乎上对 ACL 2019 审稿质量的讨论还比较温和。

比如,有投稿者表示审稿质量很高,“不管是给高分的 reviewer 还是给低分的,说的优点缺点都句句在理…… 虽然被拒了但是感觉得到了非常多宝贵的意见。”

一位匿名用户对ACL 2019审稿质量的评价

也有人认为本届 ACL 审稿质量严重下滑,比如有人批评:“千篇一律模板回复,什么实验不够详细、创新不够,这几句话复制粘贴有啥意思?求求你们给意见之前先把文章好好看一下。希望各位 PC 珍视学术环境,不要再扔文章给本科生或者低年级研究生审稿了。”

另一方面,今年 ACL 审稿取消了 bid paper 的过程,审稿人要审的稿子都是 AC 给分配的,可能被分配到不感兴趣的论文;取消了 rebuttal 环节,也就是没有了作者响应阶段,也没有公开 review。这些可能是导致部分审稿质量不如人意的原因。

不过,ACL 官方对取消 rebuttal 的解释是:“作者响应阶段最开始是审稿流程优化的产物,后来被证明耗时巨大(不仅仅作者,还包括审稿人与主席的时间),而且起到的作用很有限。因此,比起作者的回应,我们决定将更多时间和精力投入在促进项目委员会的内部讨论上,以确保所有的讨论、论文与评审结果都得到领域主席们的充分关注。”

ACL 2019录取论文抢先看

由于今年 ACL 对投稿、评审和引用规则进行了修订,其中一项是要求匿名投稿论文在投稿截止日期前的一个月内不允许上传到非匿名预印本平台(比如 arXiv);直到论文评审结果公布后才可以公开上传(揭开匿名)。

因此,尽管不少作者宣布自己的论文被接收了,大部分还没有公开上传。

下面我们列举了从社交媒体收集到的一些录取论文标题,供读者参考。

1、Gender-preserving Debiasing for Pre-trained Word Embeddings

2、Relational Word Embeddings

3、leveraging explanations for Commonsense Question Answering

4、Unsupervised Bilingual Word Embedding Agreement for Unsupervised NMT

5、NMT with Reordering Embeddings

6、Sentence-Level Agreement for NMT

7、Lattice-Based Transformer Encoder for NMT

8、Heuristic Authorship Obfuscation

9、Celebrity Profiling

10、Bias Analysis and Mitigation in the Evaluation of Authorship Verification

11、Multi-task Pairwise Neural Ranking for Hashtag Segmentation

https://cocoxu.github.io/publications/ACL2019_HashtagMaster.pdf

12、Learning Word and Sense Representations from a Large Semantically Annotated Corpus with LSTMs

13、An Investigation of Transfer Learning-Based Sentiment Analysis in Japanese

14、Fine-grained spoiler detection from large-scale review corpora

15、Evaluating cross-lingual word embeddings using a graph-based metric

16、Massively Multilingual Transfer for NER on 41 languages

https://arxiv.org/abs/1902.00193

17、Unsupervised Neural Single-Document Summarization of Reviews via 18、Learning Latent Discourse Structure and its Ranking

19、Unsupervised Text Classification Leveraging Experts and Word Embeddings

20、Correlating neural and symbolic representations of language

https://openreview.net/forum?id=ryx35Ehi84

-

毕业论文终于做完了2014-05-31 2548

-

什么是接入控制表(ACL)2010-04-06 1404

-

ACL公布的论文计算机语言学最前沿研究的详细资料概述2018-06-12 4845

-

ACL是什么?ACL有什么用?2018-09-30 47677

-

历史上最大规模NLP会议要来了!论文提交数量将在2800左右2019-03-07 3091

-

2019计算机视觉领域顶级会议的论文《非视距物体识别技术》被收录2019-03-22 2275

-

KDD 2019录取论文终于放榜了!你的论文“中奖”了吗?2019-05-05 8874

-

ICLR 2019在官网公布了最佳论文奖!2019-05-07 4942

-

几个主要机构在ICML 2019投递的论文中重点关注的方向2019-05-25 4644

-

中国AI的底牌与前路:王海峰团队十篇论文入选ACL的价值释读2019-07-01 741

-

语音识别重大突破!快商通&新加坡国立大学联合论文入选ACL 20202020-04-21 2499

-

ACL资源不足时该如何去优化?2021-05-06 4018

-

ACL2021的跨视觉语言模态论文之跨视觉语言模态任务与方法2021-10-13 3303

-

OpenHarmony程序分析框架论文入选ICSE 20252025-01-02 1934

-

云知声四篇论文入选自然语言处理顶会ACL 20252025-05-26 1124

全部0条评论

快来发表一下你的评论吧 !