伯克利打造AI识别系统,DeepFake不再可怕!精准判断真伪

电子说

描述

DeepFakes技术的安全性已然成为舆论的焦点。而近日,来自加州大学伯克利分校和南加州大学的研究人员打造了一款AI识别系统,能从Deepfake制假者未注意到的面部细节入手,准确"揪出"假视频。

DeepFake假视频的泛滥早已经不只是恶搞和娱乐的问题了!这些假视频衍生出的假新闻可能会成为2020美国大选的一场噩梦。

目前,越来越多的研究人员在努力寻找准确识别Deepfake的假视频的方法。这场斗法已经成为一场维护新闻真实性、甚至是关乎国家安全的一场军备竞赛。

近日,来自加州大学伯克利分校和南加州大学的研究人员在这场竞赛中暂时走在了前面。他们打造的AI识别系统,能从Deepfake制假者未注意到的面部细节入手,准确"揪出"假视频。

现在使用神经网络和深度学习伪造的视频,其质量和生产速度可能让即将到来的总统大选成为一场噩梦。但是,利用当前深度技术中被忽视的一些东西,研究人员发现了一种自动识别这些虚假视频的新方法。

DeepFake不再可怕,精准判断真伪

利用Deepfake生成视频现在还远远算不上完美。这些视频是利用互联网上抓取的海量图像库创建的,早期生成的视频分辨率一般很低(因为更容易隐藏缺陷),而且是过度压缩的。但Deepfake技术的发展速度非常惊人,而且这个过程中,不断改进生成视频中的缺陷,比如假视频中人物从不眨眼的缺陷,很快得到了改善,使这些生成的假视频变得越来越逼真可信。

早期的Deepfake生成的假视频缺陷明显,比如人物说话时从不眨眼,现在这个缺陷已被修复

假视频的生成与识别已经成为一场军备竞赛,任何一方都不会很快彻底打垮对手。不过最近,来自加州大学伯克利分校和南加州大学的研究人员在这场战斗中开发了出了新的武器,可以更加准确地识别伪造的视频。研究人员利用前总统奥巴马的现有视频,使用类似的过程来创建假视频,训练AI来寻找每个人的“软性生物识别”标签。

这听起来很复杂,其实这东西我们并不陌生。每当我们开口说话时,都会以微妙但独特的方式来移动身体,我们的头、手、眼睛甚至嘴唇都会产生这样的运动。这一切都是在潜意识里完成的,你没有意识到你的身体正在做这件事,大脑也没有立刻意识到身体其他部位的运动发生在何时,但从结果上看,这是一个目前Deepfake在创造假视频时的时候没有考虑到的因素。

在实验中,这款新的AI准确发现伪造视频的几率达到了92%,实验对象包括使用多种技术创建的假视频,以及由于视频文件被过度压缩导致图像质量下降的视频。

下一步,研究人员还打算通过识别人声的独特节奏和特征,来进一步提高AI识别假视频的成功率。但目前的实际情况是,Deepfake的发展和改进速度非常快,可能会在2020年之前迎头赶上,成功欺骗目前的AI识别工具。这可能是一场旷日持久的战斗,最终谁会获胜现在还很难讲。

深度学习的最新进展使得创建复杂且引人注目的假视频变得更加容易。现在,普通人就可以利用相对适度的数据和计算力,炮制出一段名人的演讲视频,这些所谓的“Deepfake”视频可能会对国家安全和社会构成重大威胁。为了应对这种日益严重的威胁,本文提出了一种技术,可以模拟人物说话时潜在的面部表情和动作。虽然这些动作看上去不显眼,但制造假视频的方法没有注意这一点,因此可用于验证视频的真假。

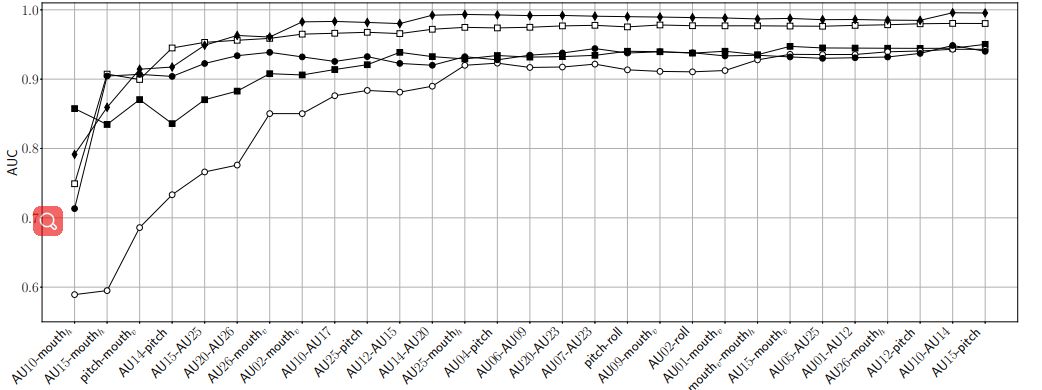

我们假设,当一个人说话时,会做出不同的(但可能不是唯一的)面部表情和动作。给定单个视频作为输入,首先跟踪面部和头部运动,然后检测并提取特定动作单元的存在性和强度。由此可以构建一个能够区分真假视频的新的检测模型。

图1 上面所示是来自250帧剪辑片段中的五个等距帧,显示了对OpenFace的跟踪结果。下半部分为此视频剪辑上测量的一个动作单元AU01(眉毛抬起)的程度。

我们使用开源面部行为分析工具包OpenFace2 来提取视频中的面部和头部运动。该数据库为给定视频中的每帧提供2-D和3-D面部地标位置、头部姿势、眼睛注视和面部动作单元。提取量度标准如图1所示。

具体来说,首先要明确的是,不同的人在说话时会表现出相对不同的面部和头部运动模式。而Deepfake假视频往往会破坏这些模式,因为假视频中的这些模式的表达由模仿算法控制,可能导致嘴巴与脸部的其他部分不自然的分离。

本文构建了高度个人化的“软生物识别指标”,并利用这些指标来区分真实和虚假视频。与以前的方法不同,这种方法能够有效应对laundering,因为该方法依赖于不易破坏的相对粗略的量度。

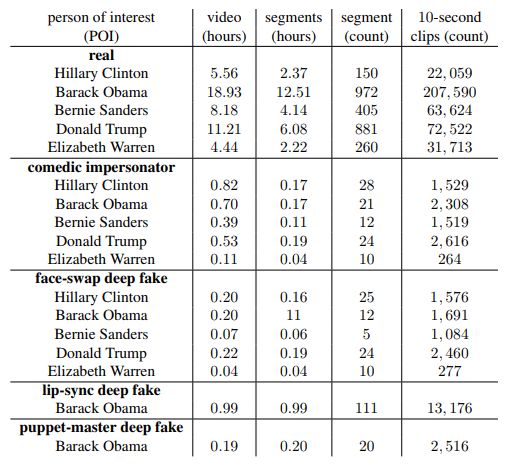

表1. POI正在讲话的下载视频和段的总持续时间,以及从段中提取的段和10秒剪辑的总数。

图2.从上到下依次是原始视频,嘴唇同步Deepfake假视频、喜剧模仿视频、换脸Deepfake和木偶大师deepfake的10秒视频剪辑的五个示例帧。

图3. 希拉里·克林顿(棕色),巴拉克·奥巴马(浅灰色带框),伯尼·桑德斯(绿色),唐纳德·特朗普(橙色),伊丽莎白·沃伦(蓝色)的190-D特征的二维可视化),随机任务(粉色),以及奥巴马的Deepfake假视频(深灰色带框)

实验结果:总体识别准确率超过95%

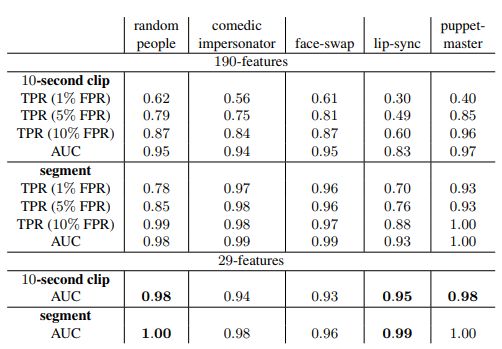

表2:奥巴马视频的三种不同假阳性率(FPR)曲线下面积(AUC)和真阳性率(TPR)的总体准确度。上半部分对应于使用完整190个特征的10秒视频片段和完整视频片段的识别准确度。下半部分为于仅使用29个特征的识别准确度。

表3:希拉里·克林顿,伯尼·桑德斯,唐纳德·特朗普和伊丽莎白沃伦的10秒视频剪辑的总体识别准确度

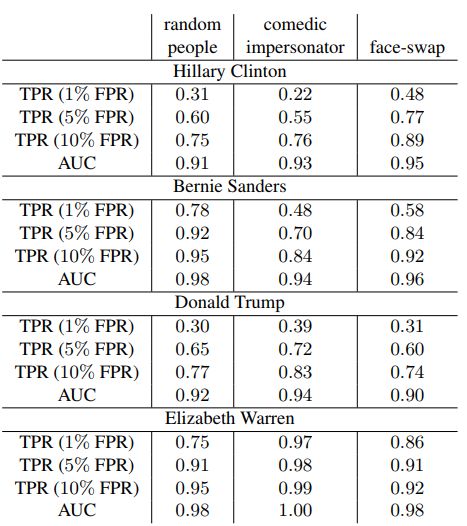

表4:对喜剧模仿假视频(黑色方块),随机人物假视频(白色方块),嘴唇同步Deepfake假视频(黑色圆圈),换脸Deepfake假视频(白色圆圈)和木偶大师Deepfake假视频(黑色菱形)的识别准确度

图5:(a)真实的样本框架; (b)喜剧模仿假视频样本框架; (c)四个名人的换脸Deepfake假视频的样本框架

研究局限与未来方向

本文提出的方法与现有的基于像素的检测方法相比,可以更好地抵御图像压缩的影响。不过我们也发现,本方法的适用性容易受到人们说话的不同背景的影响(直面镜头正式讲话,与不看镜头的现场采访)。我们建议通过以下两种方式来应对。

在各种多样化环境中收集更大、更多样化的视频集,或者构建几位名人基于特定环境下的讲话模型。除了这种背景环境效应之外,我们发现当演讲人始终远离镜头时,动作单元的可靠性可能会受到严重影响。为了解决这些局限性,建议通过语言分析来增强模型性能,更好地捕获所说内容与说法方式之间的相关性。

-

伯克利博士论文:DC-DC转换器2011-09-29 915

-

美国劳伦斯伯克利国家实验室开发出“病毒发电”元件2012-05-16 5073

-

美国加州大学伯克利分校模电资料2015-10-28 1178

-

伯克利(Berkeley)联网程序代码介绍2016-05-09 1400

-

华为投入1百万美元和伯克利合作推进 AI 技术2016-10-13 825

-

UC伯克利教授Stuart Russell:人工智能基础概念与34个误区2018-07-04 6200

-

推特公开宣布了伯克利机器人学习实验室最新开发的机器人BLUE2019-04-13 5042

-

UC伯克利新机器人成果:灵活自由地使用工具2019-04-15 2971

-

机器人遭绑架?一男子看不惯在伯克利街道上漫游的送货机器人2019-05-07 3142

-

伯克利单腿跳机器人迎来新升级 即将在ICRA2019会议上亮相2019-05-23 3381

-

加州大学伯克利分校的团队给予跳跃机器人更高目标2019-06-13 3929

-

清华、伯克利联手打造 成立RISC-V国际实验室2019-06-16 4117

-

图灵奖得主牵头推动芯片开源 清华伯克利成立RISC-V国际实验室2019-06-17 5027

-

加州大学伯克利分校研发可以操控的机器人2019-08-05 1185

-

美国伯克利市考虑2027年出台汽油车禁售令2021-01-19 1837

全部0条评论

快来发表一下你的评论吧 !