人工智能可以“读懂”人类的心情嘛?

电子说

描述

人工智能可以做的事情很多,但它们能“读懂”人类的心情嘛?近日科学家们可能找到了一种让AI学会“读心”的方法。

由于每个人走路的姿势各有不同,尽管你会认为这可能没什么,但其实你的走路姿势就可能泄露了你当时的情绪。比如,当你昂首挺胸时,你可能感到十分兴奋愉快,而当你垂头丧气时,你很可能低头或者驼背走路。

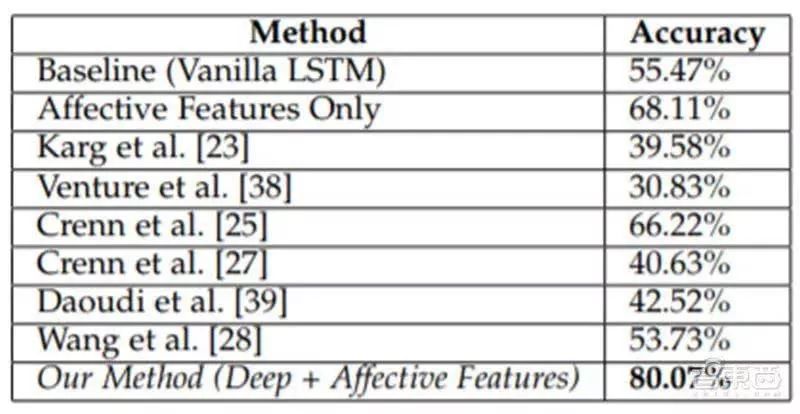

美国查佩尔希尔大学和马里兰大学的研究人员利用身体语言,研究了一种机器学习方法,这种方法可以从某人的步态中识别出他当前的情绪,包括情绪向性(消极或积极)和唤起水平(平静或充满活力)。研究人员称,这种方法识别出来的人类情绪准确率达到80.07%。

研究人员写道:“情绪在我们的生活中扮演着重要的角色,定义着我们的经历,塑造着我们看待世界和与他人互动的方式。由于感知情感在日常生活中的重要性,自动情感识别在许多领域都是一个关键问题,比如游戏和娱乐、安全和执法、购物以及人机交互等。”

于是研究人员选择了四种情绪作为分类——快乐、悲伤、愤怒和中性,以此作为测试步态分析算法的例证。然后,他们从多个步行视频语料库中提取步态来识别情感特征,并使用三维姿态估计技术提取姿态。

最后,他们利用长短时记忆(LSTM)模型——这个模型能够学习长期依赖关系,从姿态序列中获得特征,并将其与随机森林分类器(该分类器输出多个独立决策树的平均预测)相结合,将其所分析步态归入上述四种情绪类别中。

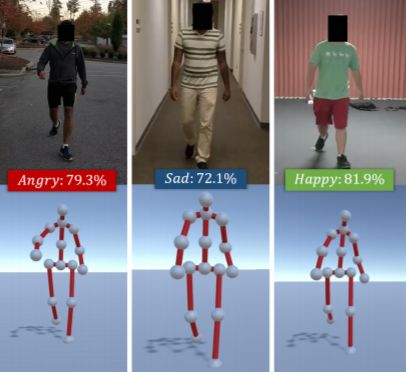

▲这个AI系统根据人们走路的方式对他们的情绪进行分类

步态的特征包括肩膀姿势、连续步数之间的距离以及手和脖子之间的抖动频率。头部倾斜角度被用来区分快乐和悲伤的情绪,而更紧凑的姿势和“身体扩张”分别代表着消极和积极的情绪。

至于唤起水平,科学家们注意到它往往与增加的动作相对应,该模型考虑了速度、加速度的大小,以及手、脚和头部关节的“运动抖动”。

AI系统处理了来自“情感漫步”(Emotion Walk,简称EWalk)的样本。EWalk是一组包含1384个步态的新数据集,这些步态是从24名受试者在大学校园(包括室内和室外)散步的视频中提取的。同时,大约700名来自亚马逊土耳其机器人公司的参与者,还给该数据集的步态情绪进行标记,以便研究人员根据这些标记来确定受试者步态情绪的效价和兴奋程度。

测试报告显示,他们的情感检测方法准确率比之前最先进的算法提高了13.85%,比不考虑情感特征的“普通”LSTM提高了24.60%。

但这些数据并不代表该机器学习方法的检测是万无一失的,因为它的准确率在很大程度上取决于3D人体姿态估计和步态提取的精确度。但尽管有这些限制,研究小组相信他们的方法将为涉及额外活动和其他情感识别算法的研究提供坚实的基础。

研究人员表示:“我们的方法也是第一个利用最先进3D人体姿态估计技术,为行走视频中的情绪识别提供实时通道的方法。作为未来工作的一部分,我们希望收集更多的数据集,并改进当前系统中存在的限制。”

-

人工智能是什么?2015-09-16 0

-

在这五件事情上 人工智能比人类更出色2016-01-15 0

-

人工智能的前世今生 引爆人工智能大时代2016-03-03 0

-

人工智能--失业将是人类面临的最大挑战2016-06-27 0

-

人工智能:革命还是伤害?2016-10-10 0

-

人工智能发展的好与坏2017-06-24 0

-

了解人工智能,30份书单不容错过(附电子版PDF下载)2017-11-02 0

-

人类与人工智能机器人合作的前景2018-04-16 0

-

解读人工智能的未来2018-11-14 0

-

人工智能医生未来或上线,人工智能医疗市场规模持续增长2019-02-24 0

-

人工智能:超越炒作2019-05-29 0

-

人工智能能否取代人类?2019-09-11 0

-

人工智能的应用领域有哪些?2020-10-23 0

-

物联网人工智能是什么?2021-09-09 0

-

《通用人工智能:初心与未来》-试读报告2023-09-18 0

全部0条评论

快来发表一下你的评论吧 !