ChatGPT带旺服务器需求,Rambus发布第三代DDR5 RCD芯片,提前卡位DDR5市场爆发

描述

电子发烧友网报道(文/黄晶晶)随着服务器CPU更多的开始支持DDR5,服务器的内存也正向DDR5渗透,Rumbus公司预计服务器DDR5将在2023年出现强劲增长。事实上,作为唯数不多的内存接口芯片供应商,Rumbus在第一代和第二代DDR5 RCD产品已经取得先机。最近,Rumbus推出第三代DDR5 RCD产品,这也是为了顺应服务器CPU性能和数据传输速率不断升级的趋势。Rambus内存互连芯片业务部门产品营销副总裁John Eble透露,从2022年第四季度开始,Rumbus第三代DDR5 RCD芯片已经送样给相关的客户进行使用。预计使用DDR5 RCD第三代的系统将在2024年开始出货,并在2025年实现量产。

内存接口芯片可以分为RCD寄存时钟驱动器和DB数据缓冲器。RCD用来缓冲来自内存控制器的地址/命令/控制信号,DB用来缓冲来自内存控制器或内存颗粒的数据信号。目前服务器采用的内存模组主要有RDIMM和LRDIMM两种形式,服务器根据CPU的数量配置几十个不等的内存模组,每个内存模组都需要搭载一颗RCD芯片,该芯片的市场需求非常可观。

DDR5的新变化

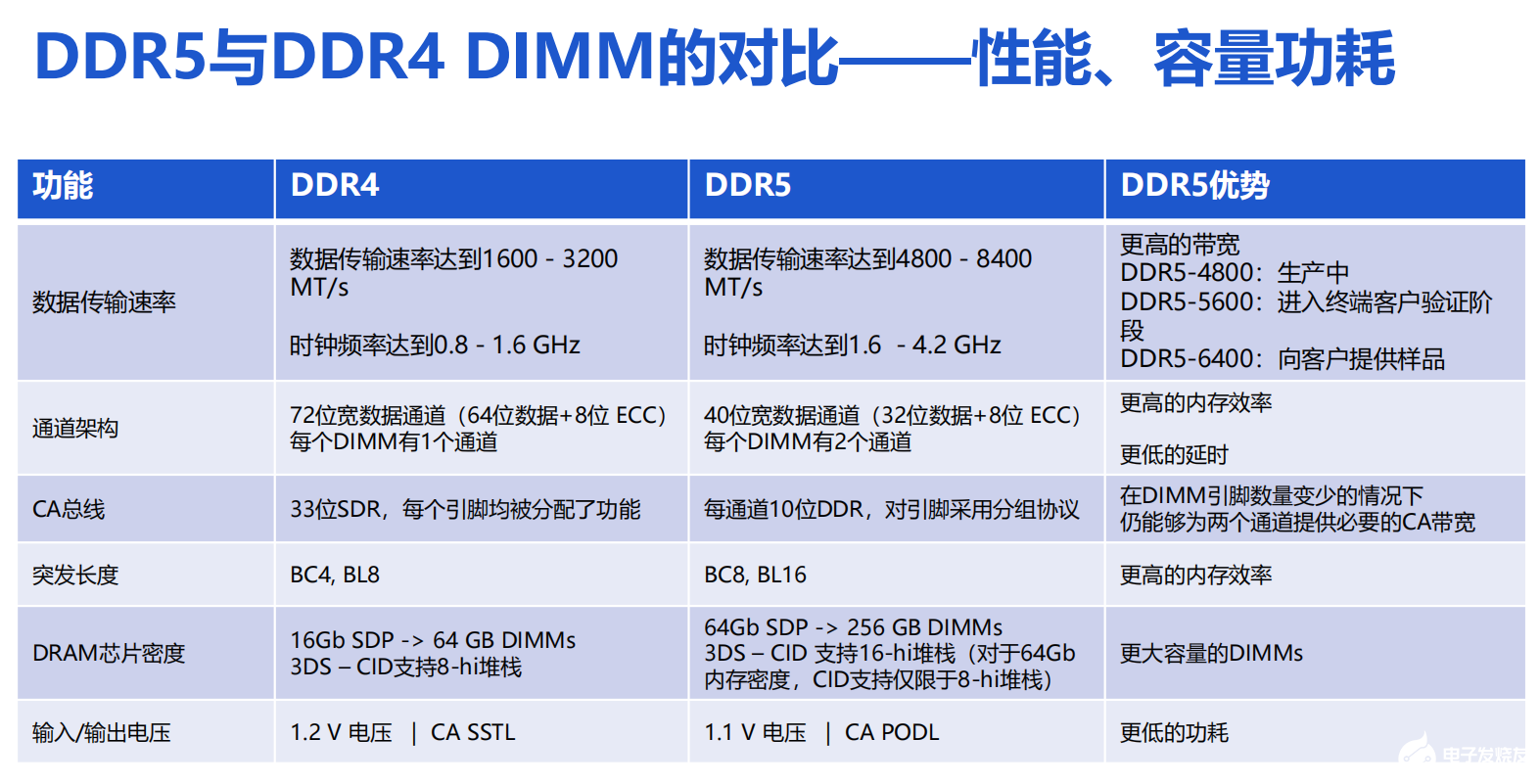

从DDR4到DDR5的升级中DIMM发生了一些变化。John Eble分析,DDR4的RDIMM通常是单通道的,采用8位子通道传输数据,在两侧配备ECC,一共具备72位宽的数据通道,包括64位数据和8位ECC。DDR5 RDIMM采用16位的突发长度,每个DIMM有两个通道,每个子通道是40位,包括32位数据和8位 ECC,分别负责不同的任务。

DDR5相比DDR4带宽有着显著的上升,DDR4最高数据传输速率是3200MT/s,DDR5基本上对比DDR4实现了带宽的翻倍,最高可达到8400MT/s以上。同时,DDR5比DDR4带来更大容量的DIMM,从64GB提高到256GB,并且支持16-hi堆栈(对于64Gb内存密度,CID支持仅限于8-hi堆栈)。在功耗上,DDR5列加优化,DIMM运行电压降到1.1伏,同时CA总线升级,对引脚采用分组协议,每个通道达到10位DDR,并采用了PODL协议。

可以看到,每次DDR迭代并不仅仅在数据传输速率上得到巨大的升级,同时带宽和容量也实现增加,时钟频率和技术也一直在进步,进一步降低客户的总体拥有成本(TCO)。

第三代DDR5 RCD芯片的特性

RCD是DIMM非常重要的一个组件,Rumbus全新推出的DDR5 RCD Gen3产品,在数据传输速率,以及带宽和时钟频率等都得到了升级。例如与第一代相比数据传输速率和带宽提高33%,DDR5 RCD Gen1速率为4800MT/s,DDR5 RCD Gen2为5600MT/s,DDR5 RCD Gen3来到6400MT/s。

RCD将命令、地址信号和时钟分配给DIMM上的DRAM设备。Rambus正在不断提高其DDR5解决方案的性能,以满足更高的带宽需求。Rambus以其信号完整性(SI)/电源完整性(PI)方面的专业技术著称。这种专长大大有利于DDR5内存接口芯片确保从主机内存控制器发送到RDIMM的命令/地址和时钟信号具有出色的信号完整性。

具体来看,John Eble解析,关于两个关键接口的信号完整性问题,第一个接口是CPU到RCD的接口,这是一个DDR接口,通过DDR5 DIMM连接器运行,在2个DIMM通道系统中可能有2个RCD负载。

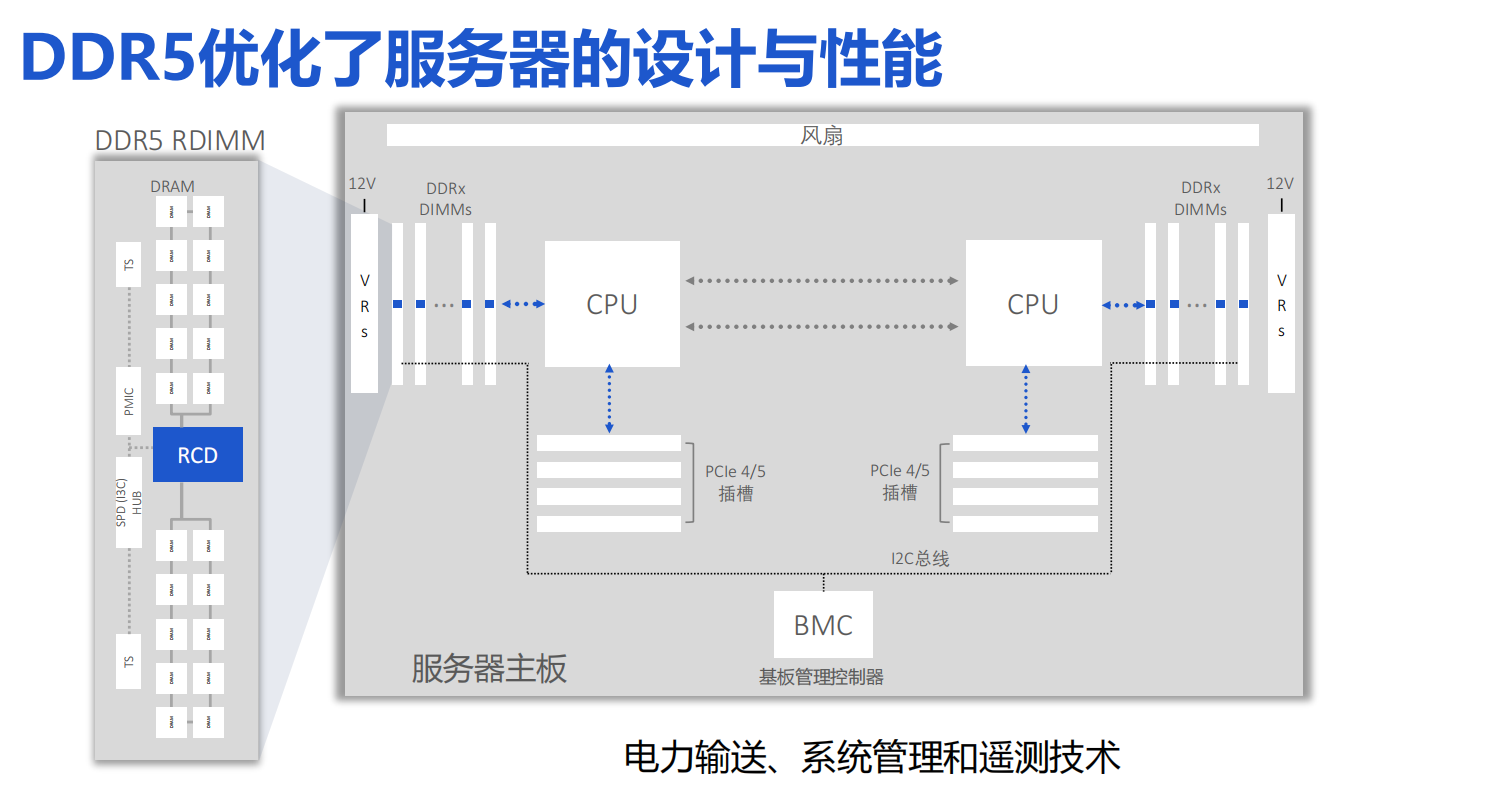

第二个接口是从RCD到DRAM,这是在DIMM上。RCD到DRAM接口不管是从布线,还是到支持最高10个相关外插式设备的总线,还是像CA总线,这些也都是这个接口非常重要的考虑方向。当我们解决这些挑战的时候,同时也要管理功率和成本。基于Rambus的RCD、SPD集线器,以及温度传感器,Rambus推出的创新解决方案可以进一步优化信号完整性,帮助客户进一步控制功耗和成本。

随着RCD产品的进一步优化以及迭代,它的信号完整性会变得更好,DIMM和CPU之间的信号完整性会更加优秀,性能更加卓越,同时也可以进一步降低DRAM的相关工作负载,为DIMM整体的电力输送,系统管理和遥测技术提供支撑,这些都是RCD和DDR5的应用方向。

ChatGPT需要怎样的内存解决方案?

对于如今大火的ChatGPT,Rambus也收到了非常多客户的方案咨询,它涉及到内存如何更好地支持类ChatGPT的数据传输与算力能力。Rambus大中华区总经理苏雷表示,首先ChatGPT需要海量的数据进行深度的机器学习,完成一个训练的模型和推理。因此它依赖于更高的算力,这方面的算力更多是趋向于矩阵类和卷积类的计算。它对内存重要的需求体现在训练和推理AI芯片,或者是对加速模块里的内存带宽有一定需求。Rambus有先进的HBM技术和解决方案,继DDR的技术之后,HBM也会是这个领域重要的推力。Rambus非常乐于助力国内ChatGPT产品的发展。

随着RCD产品的迭代和技术的进步,能够很大程度上帮助我们去克服现在像ChatGPT的应用对服务器带来的巨大挑战。Rambus从事内存创新的业务,以确保随着计算引擎的扩大,我们能够从内存中为这些计算引擎提供它所需要的数据。

John Eble认为ChatGPT这样的人工智能应用将可能需要一种多管齐下的解决方案。首先是DDR5应用的快速发展。因此,我们将扩大在DDR5内存接口芯片领域的领导地位,并定义下一代架构,以低延迟和高可靠性继续扩大内存、容量和带宽。其次,CXL也是另外一项非常重要的配合性技术,在未来的服务器中具有许多潜在的优势,可以以有效和可扩展的方式增加内存、容量和带宽。

小结:

根据IDC的调研数据表示,DDR5的拐点可能会在2024年上半年出现。显然,Rambus已经为市场的爆发提前部署了先进的内存接口方案。至于未来的技术发展,其中一个关注点是MCR DIMM,它有望为每个DIM插槽提供超越正常DRAM带宽增长节奏的加速。John Eble表示,这种类型的高带宽解决方案确实需要修改RCD,它也需要一个修改的DB,这些也是Rambus的核心竞争力所在。

-

Introspect DDR5/LPDDR5总线协议分析仪2024-08-06 4726

-

Rambus 通过 DDR5 服务器 PMIC 扩展适用于高级数据中心内存模块的芯片组2024-06-21 730

-

Rambus通过全新PMIC系列支持多代基于 DDR5 的高性能服务器2024-06-20 1565

-

澜起科技:DDR5第三子代RCD芯片将随新一代CPU平台规模出货2024-02-02 1758

-

澜起科技宣布推出DDR5第四子代寄存时钟驱动器芯片(DDR5 RCD04)2024-01-04 1509

-

Rambus 通过业界首款第四代 DDR5 RCD 提升数据中心服务器性能2023-12-28 1120

-

澜起科技在业界率先试产DDR5第三代时钟驱动器芯片M88DR5RCD032023-10-27 1749

-

新品发布 | 瑞萨电子推出业界首款客户端时钟驱动器CKD和第3代RCD,以支持严苛的DDR5客户端与服务器DIMMs应用2023-06-29 1603

-

浅谈Rambus对DDR5市场趋势的前瞻见解2023-05-06 849

-

Rambus推出6400MT/s DDR5寄存时钟驱动器,进一步提升服务器内存性能2023-02-22 1020

-

澜起科技发布业界首款DDR5第三子代寄存时钟驱动器工程样片2022-12-01 785

-

Rambus推出DDR5系列产品:串行检测集线器和温度传感器2022-11-02 1970

-

DDR5爆发前夜,Rambus再次扩充产品阵营2022-08-31 2778

-

Rambus发布业界首款5600 MT/s DDR5寄存时钟驱动器(RCD)2021-11-17 3045

全部0条评论

快来发表一下你的评论吧 !