BP神经网络的基本结构和训练过程

描述

BP神经网络,全称为反向传播神经网络(Backpropagation Neural Network),是一种在机器学习、数据挖掘和模式识别等领域广泛应用的人工神经网络模型。其工作原理基于多层前馈网络结构,通过误差反向传播算法(Error Backpropagation Algorithm)来训练网络,实现对复杂问题的学习和解决。以下将详细阐述BP神经网络的工作方式,涵盖其基本原理、训练过程、应用实例以及优缺点等多个方面。

一、BP神经网络的基本结构

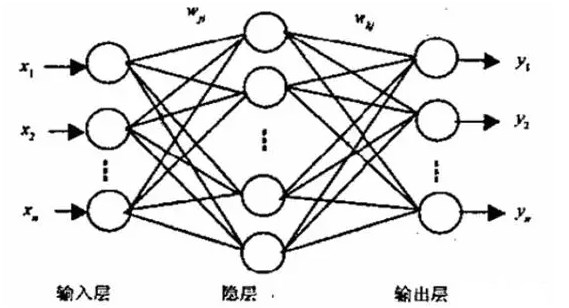

BP神经网络由多个层次组成,主要包括输入层、隐藏层(可以有多个)和输出层。每一层都包含多个神经元,这些神经元通过带有权重的连接相互连接。信息在网络中从输入层开始,逐层向前传递,通过各层的激活函数进行计算和转化,最终到达输出层。

- 输入层 :接收外部输入信号,不进行任何计算,仅作为数据输入的接口。

- 隐藏层 :对输入信号进行非线性变换,是神经网络的核心部分,负责学习输入与输出之间的复杂映射关系。隐藏层可以有一层或多层,层数和神经元数量根据具体问题而定。

- 输出层 :输出网络的处理结果,通常与问题的具体目标(如分类、回归等)相对应。

如图所示为BP神经网络的拓扑结构,一般包含三层前馈网,即输入层、中间层(也称隐层)和输出层。它的特点是:各层神经元仅与相邻层神经元之间相互全连接,同层内神经元之间无连接,各层神经元之间无反馈连接,构成具有层次结构的前馈型神经网络系统。单计算层前馈神经网络只能求解线性可分问题,能够求解非线性问题的网络必须是具有隐层的多层神经网络。

如图所示的BP神经网络,输入层包含m个节点,输出层包含n个节点,可以看做是一个m维向量到一个n维向量的映射。

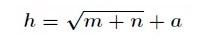

隐层节点的选择有一个经验公式:

其中h为隐含层节点数目,m为输入层节点数目,n为输出层节点数目,a为1~10之间的调节常数。

二、BP神经网络的训练过程

BP神经网络的训练过程主要分为两个阶段:前向传播和反向传播。

1. 前向传播

前向传播是信号在网络中从输入层向输出层传播的过程。具体来说,输入层的信号经过加权和运算后传递给隐藏层,隐藏层的神经元接收来自前一层的信号,经过激活函数处理后再传递给下一层,直到最终到达输出层。每一层的输出都是下一层输入的来源。

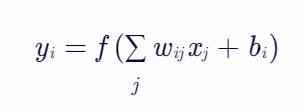

在前向传播过程中,神经元的输出计算方式通常为:

其中,yi表示当前神经元的输出,f(⋅)为激活函数,wij为从神经元j到神经元i的连接权重,xj为前一层的输入(或神经元j的输出),bi为神经元i的偏置项。

2. 反向传播

反向传播是误差从输出层向输入层反向传播的过程,用于调整网络中的连接权重和偏置项,以减小网络输出与期望输出之间的误差。

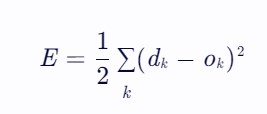

首先,计算网络输出与期望输出之间的误差,常用的误差函数为均方误差(Mean Squared Error, MSE):

其中,dk为期望输出,ok为实际输出。

然后,利用链式法则计算误差关于各层权重的梯度,即误差信号在各层之间的反向传播。梯度表示了权重变化对误差减少的影响程度,通过梯度下降法更新权重,使误差逐步减小。

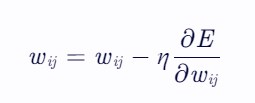

权重更新公式为:

其中,η为学习率,决定了权重更新的步长。

三、BP神经网络的算法实现

BP神经网络的算法实现包括网络初始化、前向传播、误差计算、反向传播和权重更新等步骤。以下是一个简化的算法流程:

- 初始化网络 :随机初始化网络中所有连接的权重和偏置项。

- 前向传播 :根据输入数据,通过加权和和激活函数计算每一层的输出,直至得到输出层的输出。

- 误差计算 :计算输出层的误差,并将其反向传播到隐藏层。

- 反向传播 :根据误差和梯度下降法,计算每一层权重的梯度,并更新权重。

- 迭代训练 :重复步骤2-4,直到满足停止条件(如达到最大迭代次数、误差小于预定阈值等)。

四、BP神经网络的应用实例

BP神经网络在多个领域有着广泛的应用,如模式识别、分类、回归、预测等。以下列举几个具体的应用实例:

- 手写数字识别 :通过训练BP神经网络,可以实现对手写数字图像的分类识别。网络输入为数字图像的像素值,输出为数字类别。

- 人脸识别 :在人脸识别系统中,BP神经网络可以学习人脸图像的特征,实现人脸的检测和识别。

- 语音识别 :通过训练BP神经网络,可以提取语音信号的特征,实现对语音的识别和理解。

- 股票价格预测 :利用历史股票价格数据训练BP神经网络,可以预测未来股票价格的走势,为投资者提供决策支持。

五、BP神经网络的优缺点

优点:

- 非线性映射能力 :BP神经网络通过隐藏层的非线性激活函数,能够学习和逼近复杂的非线性映射关系,解决传统方法难以处理的问题。

- 自学习和自适应能力 :网络在训练过程中能够自动调整权重和偏置项,以适应不同输入数据的特性,表现出较强的自学习和自适应能力。

- 容错能力强 :BP神经网络具有一定的容错性,即当输入数据存在噪声或缺失时,网络仍能给出较为合理的输出。

- 并行处理能力 :神经网络的计算是高度并行的,每个神经元都可以独立进行计算,这使得网络在处理大规模数据时具有较高的效率。

缺点:

- 训练时间长 :由于BP神经网络采用梯度下降法来更新权重,而梯度下降法本身可能陷入局部最小值,导致训练过程耗时较长,且可能无法找到全局最优解。

- 过拟合问题 :当网络结构过于复杂或训练数据不足时,BP神经网络容易出现过拟合现象,即网络对训练数据过度拟合,而对新数据的泛化能力较差。

- 权重初始化敏感 :BP神经网络的性能对权重的初始值较为敏感,不同的初始值可能导致网络收敛到不同的局部最小值。

- 参数选择困难 :网络中的学习率、隐藏层数、神经元数量等参数需要人工设定,且这些参数的选择对网络的性能有较大影响,缺乏统一的选择标准。

六、BP神经网络的改进方法

为了克服BP神经网络的上述缺点,研究者们提出了多种改进方法,包括但不限于以下几种:

- 优化算法 :引入更高效的优化算法,如动量法、共轭梯度法、牛顿法等,以加快训练速度并减少陷入局部最小值的风险。

- 正则化技术 :通过添加正则化项(如L1正则化、L2正则化)到误差函数中,限制网络权重的复杂度,从而减轻过拟合问题。

- 早停法 :在训练过程中监控网络在验证集上的性能,当性能开始下降时停止训练,以避免过拟合。

- Dropout技术 :在训练过程中随机丢弃一部分神经元及其连接,以减少神经元之间的共适应性,提高网络的泛化能力。

- 批量归一化 :在每个隐藏层之后添加批量归一化层,对输入数据进行归一化处理,以加速训练过程并提高网络的稳定性。

- 深度学习框架 :利用深度学习框架(如TensorFlow、PyTorch等)来构建和训练BP神经网络,这些框架提供了丰富的工具和库,使得网络的设计、训练和评估变得更加简单和高效。

七、结论

BP神经网络作为一种经典的人工神经网络模型,在多个领域展现了其强大的学习和适应能力。然而,它也存在一些固有的缺点和挑战。通过不断优化算法、引入正则化技术、采用Dropout和批量归一化等方法,可以进一步提高BP神经网络的性能和稳定性。随着深度学习技术的不断发展,BP神经网络及其改进版本将在更多领域发挥重要作用,推动人工智能技术的持续进步。

-

在Ubuntu20.04系统中训练神经网络模型的一些经验2025-10-22 116

-

如何训练BP神经网络模型2025-02-12 1541

-

脉冲神经网络怎么训练2024-07-12 1722

-

BP神经网络的学习机制2024-07-10 1881

-

bp神经网络算法过程包括2024-07-04 1454

-

BP神经网络算法的基本流程包括2024-07-03 1446

-

卷积神经网络的基本原理、结构及训练过程2024-07-02 4968

-

如何训练和优化神经网络2024-07-01 1445

-

基于BP神经网络的PID控制2021-09-07 2587

-

BP神经网络概述2018-06-19 45163

-

粒子群优化模糊神经网络在语音识别中的应用2010-05-06 2445

全部0条评论

快来发表一下你的评论吧 !