美光高管看2024年AI数据中心、AI PC的存储趋势

美光高管看2024年AI数据中心、AI PC的存储趋势

描述

电子发烧友网报道(文/黄晶晶)生成式AI带来的产业技术革新不仅在于性能越来越强大的GPU,它同时正在推进存储产品的变化和技术的进步。近日,美光副总裁暨客户端存储事业部总经理Prasad Alluri在接受包括电子发烧友网在内的少数媒体采访时指出,与过往不同,闪存和内存曾各自为政,主要致力于提高密度。AI的兴起带来了两大转变,一是与系统架构的协同优化;二是将能效作为关键优化参数。为此,美光科技正积极优化存储产品、赋能AI在数据中心、PC、智能手机乃至汽车等各领域的应用与发展。

AI数据中心:两大存储池的不同存储策略

Prasad Alluri表示,在探讨AI基础设施对数据中心存储的具体影响时,我们可以将其视为两个独立的存储池来分析。

首先,存在一个庞大的数据池,用于存储供模型训练所需的数据。以GPT-4为例,据估算,其训练过程消耗了互联网上约四分之一的数据,这足以说明大模型所需数据的庞大规模。为了训练这类模型,必须具备存储海量数据的能力,我们可以形象地称之为“数据湖”,即所有待训练数据均汇聚于此。

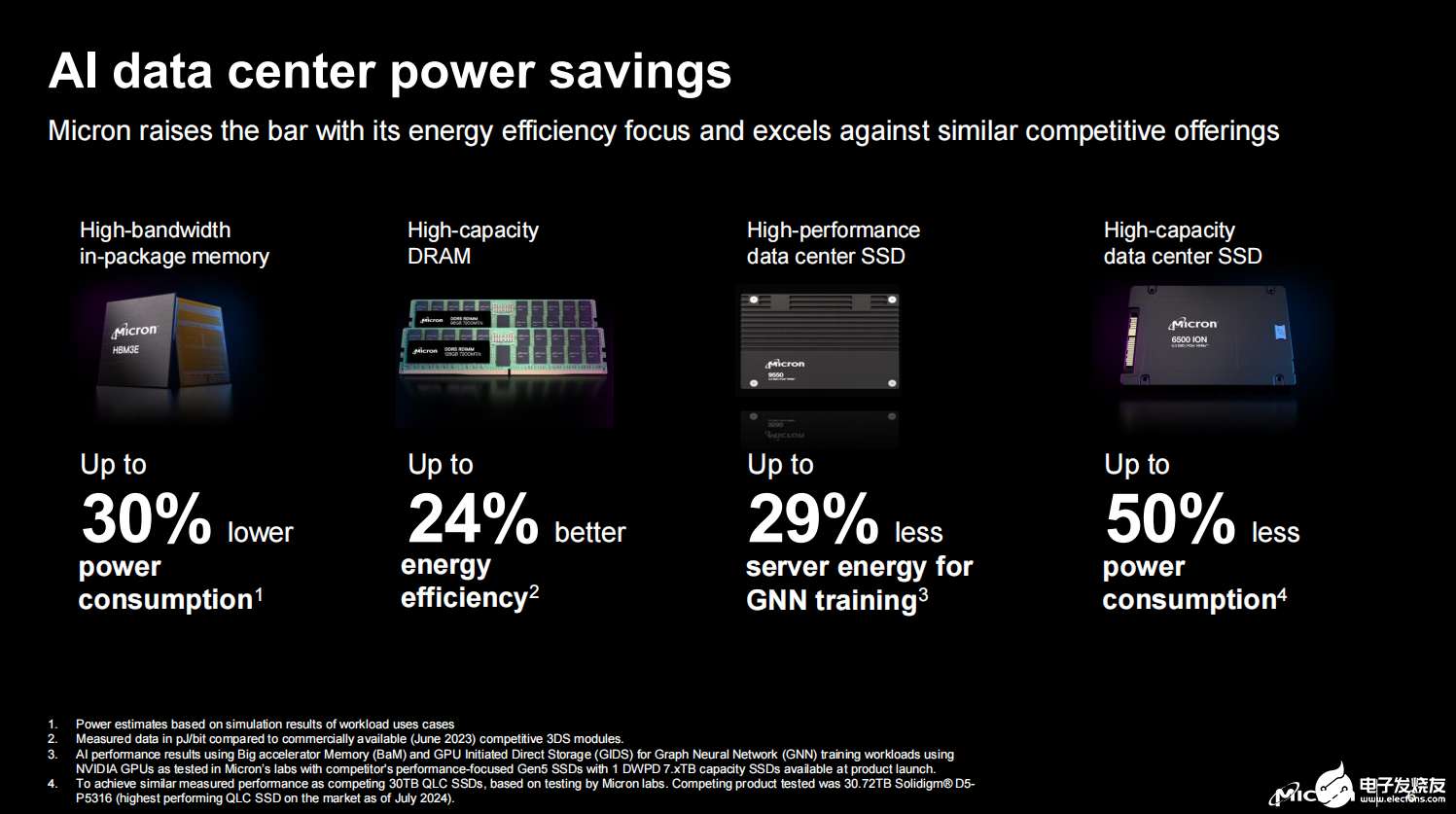

对于这一存储场景,最关键的属性在于能够高效且经济地传输数据。将容量与经济性相结合,意味着需要摒弃主要依赖大容量硬盘驱动器的传统架构,转而采用大容量SSD。此举不仅能减少物理占用空间,还能降低能耗,从而提升整体能源经济性。在此方面,美光科技推出的6500 ION系列产品正是针对大容量存储需求而优化的理想解决方案。

另一方面是训练过程实际发生的存储池,即紧邻GPU的存储池。此时,需考虑的是如何将数据湖中的数据高效送入GPU内存以供训练。在此过程中,设备的读写性能至关重要,尤其是随机读取性能。对于这类靠近GPU训练集群的存储,美光9550 SSD从设计之初便旨在满足这些需求。9550 SSD随机读取性能领先业界,速率高达3,300 KIOPS,这正是训练集群所亟需的。

此外,美光9550 SSD提供业界领先的能效,并在支持各类AI工作负载方面表现出众,包括使用大规模存储加速器(BaM)进行图神经网络(GNN)训练(SSD平均功耗降低高达43%,整体系统能耗减少高达29%)、NVIDIA Magnum IO GPUDirect Storage(每传输1TB数据,SSD能耗降低高达81%)、MLPerf(SSD能耗降低高达35%,系统能耗降低高达13%)以及使用Microsoft DeepSpeed对Llama 大语言模型(LLM)训练进行微调(SSD能耗降低高达 21%)。

AI PC的存储需求,将远超微软的“基准要求”

微软为AI PC产品Copilot+设定了基准要求,其中NPU的算力起始于40 TOPS,内存方面则规定了至少16GB的容量,以及256GB的存储空间作为最低配置。不过,Prasad Alluri表示,这些仅是基础指导线,并未全面界定AI PC的真正内涵。

“要深入理解AI PC,我们需将焦点放在用户体验上。AI PC的核心在于通过诸如翻译或图像编辑等任务来提升生产力,且这些任务需在设备上高效完成。正是这种整体体验定义了AI PC,而非单纯的技术规格。为了满足用户的这些期望,我们认为所需的内存量远超最低指导线。事实上,当前多数OEM在打造AI PC时,已配备了24GB至32GB的DRAM。”

从存储角度来看,尽管OEM目前提供的最低容量为512GB,但我们认为对于AI工作负载而言,更理想的容量应接近1TB。

不过,这不仅仅关乎容量大小,功耗效率和性能同样至关重要。在存储领域,目标是以最高效的方式将AI模型从存储加载到内存中。为此,需要在不增加功耗的前提下,获得尽可能高的吞吐量。美光高性能客户端3500 SSD在相同功耗下提供了业界领先的性能。

针对于AI PC,美光科技加速了LPDDR5X在AI PC中的应用普及。与同类SODIMM产品相比,LPDDR5X的性能提升了约1.5倍。此外,还专为AI个人电脑设计了一种新型内存模块——LPCAMM2。与传统SODIMM产品相比,LPCAMM2不仅性能提升1.5倍,而且功耗降低高达58%,空间节省达64%。这款新产品于今年早些时候推出,主要围绕三大目标设计:提升性能、降低功耗以及减小体积。在标准PC中,通常需要两个SODIMM并排放置,占用主板大量空间。而LPCAMM2则将这些功能集成到一个DIMM中,从而显著提升了电源效率和性能。

在当前的PC环境中,以我们内部使用的Microsoft Copilot为例,它高度依赖云计算,将大部分复杂任务卸载到云端。然而,未来的AI个人电脑将能够在本地处理部分工作负载,减少对云端的依赖。这样,模型复杂性将降低,AI个人电脑能在保持高性能的同时,实现更高效的能源利用,提高数据处理的灵活性和速率。

在PC的本地存储中完全可以放置多个模型,并根据用户查询的上下文加载这些模型。例如,如果用户需要语音转文本服务,您可以加载相关模型;如果用户需要图像创建,您可以加载相应的模型。在此过程中,关键在于以节能方式从存储中加载数据,因此,SSD的性能至关重要,它需在最低功耗下实现最高吞吐量,即充分利用PCIe 4.0 的四通道。

为此,美光科技的3500 SSD不仅在最低功耗下提供行业领先的性能。同时,该SSD中内置了启发式算法。当检测到AI工作负载时,驱动器可以主动加载所需的正确模型或数据。这些就是为实现高效能和电源效率所做的优化。

QLC越发重要,闪存层数应从纵横向提升

当本网记者问及当前QLC对于AI存储越来越重要,美光的看法与规划,以及3D NAND闪存的层数将如何发展等问题时,Prasad Alluri也给出了详细的分析。

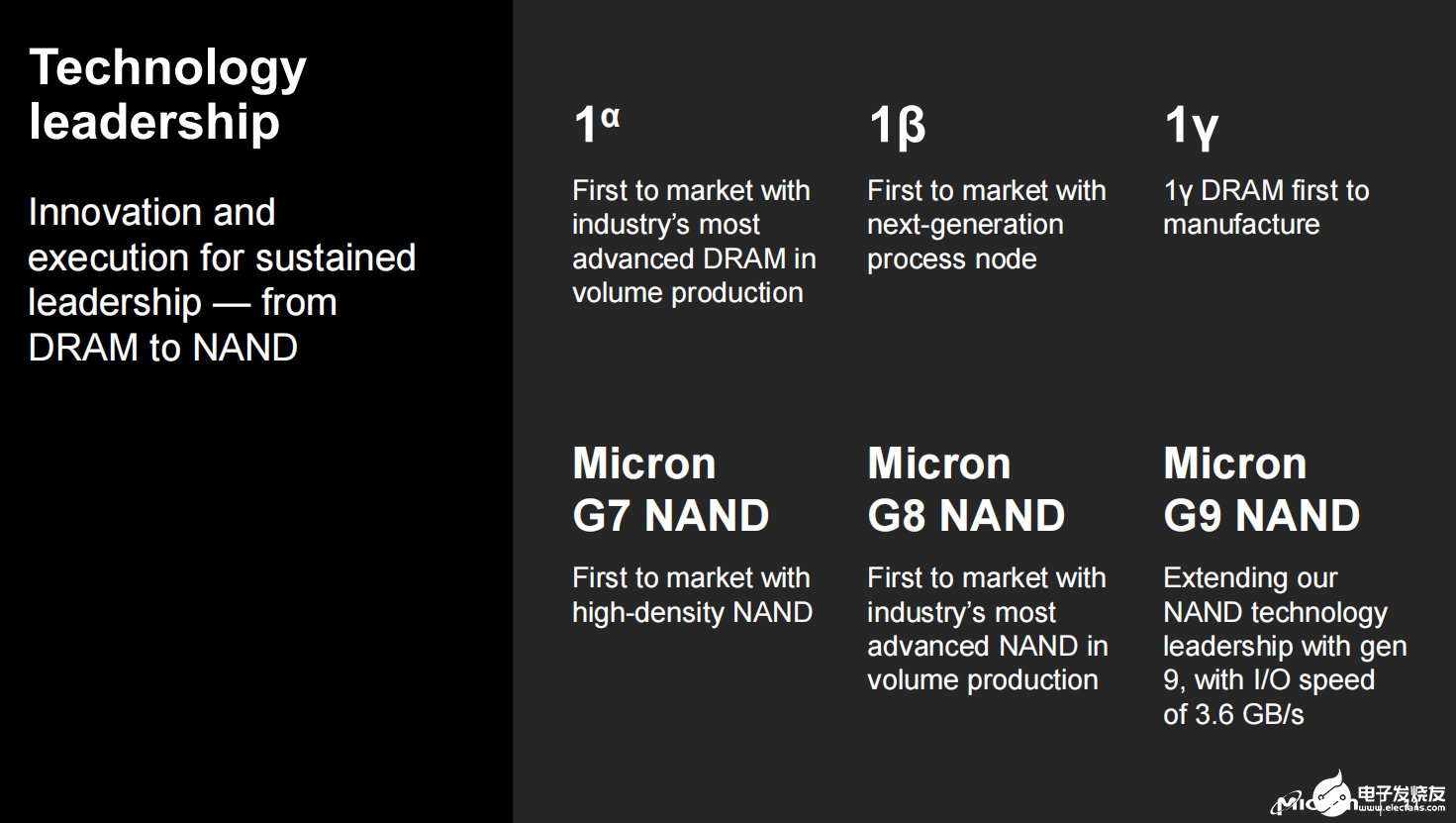

Prasad Alluri表示,从NAND技术的视角来看,最关键的因素在于每平方毫米的容量密度。也就是我们最终追求的是比特面密度(Bit Areal Density),因为这将有助于降低成本。

但是,有多种方法可以实现这一目的。其中一种是对单个物理单元提升容量。这正是四阶存储单元(QLC)技术大显身手的地方,而我们在这一领域始终保持领先地位,特别是在PC市场率先推出了这一技术。目前,美光科技在该领域的市场占有率位居前列。尽管我们尚未宣布针对数据中心的具体计划,但我们仍在持续投资QLC技术,并致力于提高容量密度,这是推动技术进步的重要途径之一。

另外,在NAND技术中可以通过堆叠更多层来增加单位面积内的容量。美光科技最近推出了第九代(G9)TLC NAND技术。虽然目前尚不清楚3D NAND的层数何时会达到极限,但在未来的几代产品中,美光的闪存层数将继续增加。

但他也强调,层数并非实现比特面密度提升的唯一关键因素,因为横向扩展同样至关重要。除了关注3D堆叠层的数量外,还需要考虑单元之间水平位置的接近程度。这种横向优化是美光提高比特面密度的另一个关键领域。

-

加速AI未来,睿海光电800G OSFP光模块重构数据中心互联标准2025-08-13 1996

-

DeepSeek推动AI算力需求:800G光模块的关键作用2025-03-25 935

-

华为全新升级星河AI数据中心网络2025-03-24 911

-

美光高管:AI PC存储远超“基准要求”,两大策略应对数据中心“存储池”2024-10-18 3815

-

美光发布全新数据中心SSD2024-07-30 1158

-

美光推出全新数据中心 SSD,性能业界领先2024-07-29 1389

-

HNS 2024:星河AI数据中心网络,赋AI时代新动能2024-05-15 1308

-

让数字世界坚定运行 | 华为发布2024数据中心能源十大趋势2024-01-17 882

-

美光推出面向数据中心的6500 ION SSD与XTR SSD,再创存储新高2023-05-19 4821

-

美光推出高性能数据中心 SSD,应对最严苛的工作负载挑战2023-01-10 764

-

未来数据中心与光模块发展假设2020-08-07 2860

-

云数据中心市场的十大趋势2018-12-31 2562

全部0条评论

快来发表一下你的评论吧 !