硬盘分区方式MBR和GPT的区别

大模型如何快速构建指令遵循数据集?

GPT-4已经会自己设计芯片了吗?

由浅入深的图解机器学习和GPT原理

基于交互环境的生成式预训练和指令微调方法

GPT-4处于一个什么样的编码地位

DeepSpeed里面和Zero相关技术教程

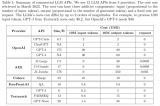

性能媲美同时成本降低98%,斯坦福提出FrugalGPT,研究却惹争议

Transformer结构及其应用详解

从大模型中蒸馏脚本知识用于约束语言规划

微软提出Control-GPT:用GPT-4实现可控文本到图像生成!

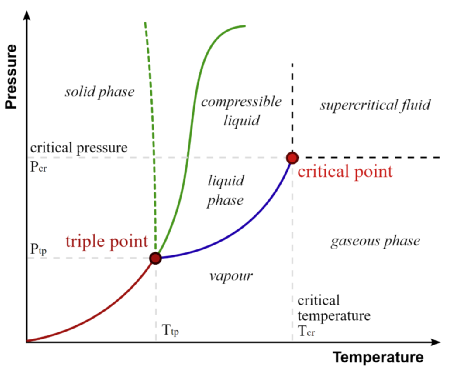

GPT4技术原理之相变与涌现

GPT-4推理提升1750%!清华姚班校友提出全新ToT框架

LLM性能的主要因素

数字波束如何形成完整代码

LLM底座模型:LLaMA、Palm、GLM、BLOOM、GPT结构对比

浅析推理加速引擎FasterTransformer

追赶GPT-4的多模态大模型对比分析

GPT-4拿下最难数学推理数据集新SOTA!新型Prompting让大模型推理能力狂升!

OpenAI用GPT-4解释了GPT-2三十万个神经元:智慧原来是这个样子