PyTorch教程-13.6. 多个 GPU 的简洁实现

PyTorch教程-13.5。在多个 GPU 上进行训练

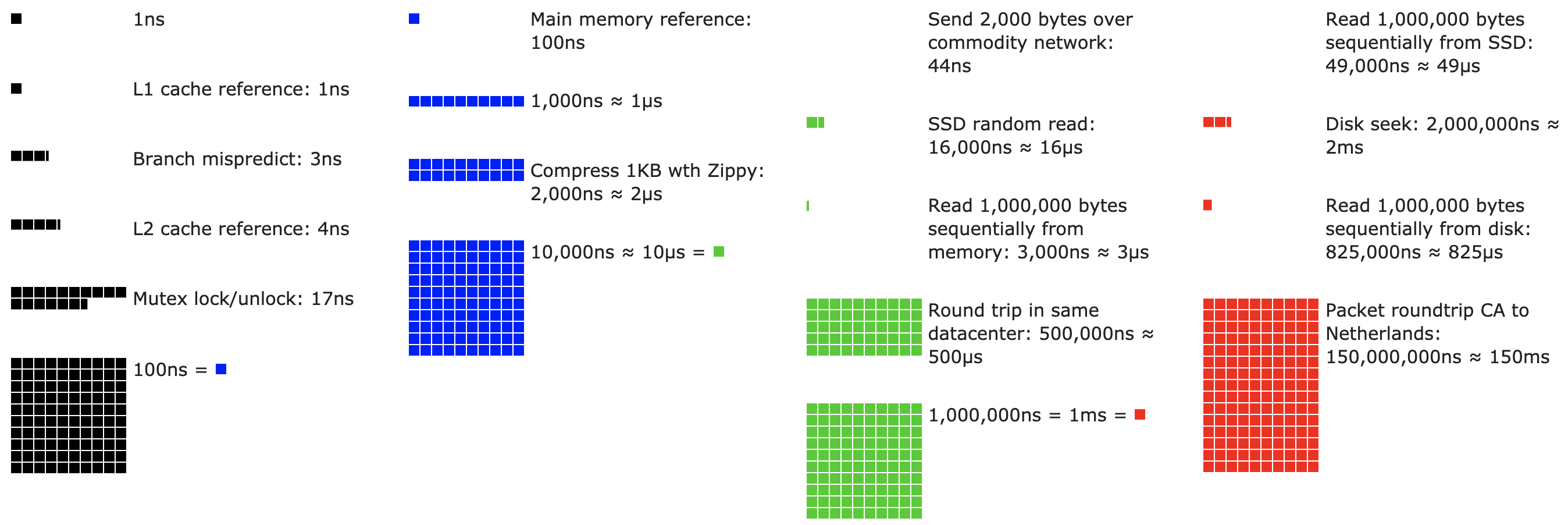

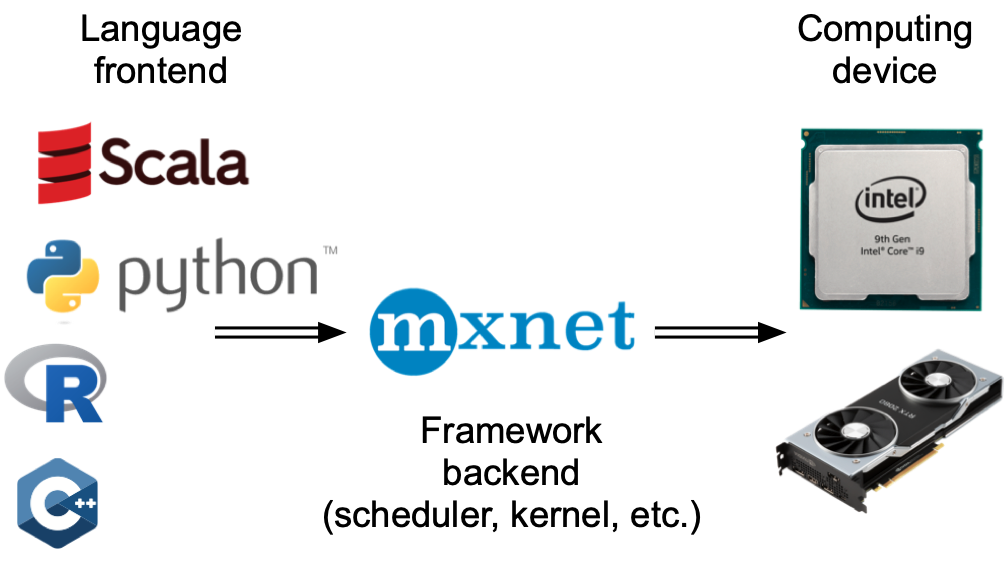

PyTorch教程-13.4. 硬件

PyTorch教程-13.3. 自动并行

PyTorch教程-13.2. 异步计算

PyTorch教程-12.11。学习率调度

PyTorch教程-12.7。阿达格拉德

PyTorch教程-12.6. 势头

PyTorch教程-12.5。小批量随机梯度下降

PyTorch教程-12.4。随机梯度下降

PyTorch教程-12.2. 凸度

PyTorch教程-12.1. 优化和深度学习

PyTorch教程-11.9. 使用 Transformer 进行大规模预训练

PyTorch教程-11.6. 自注意力和位置编码

PyTorch教程-11.5。多头注意力

PyTorch教程-11.4. Bahdanau 注意力机制

PyTorch教程-10.8。波束搜索

PyTorch教程-10.7. 用于机器翻译的编码器-解码器 Seq2Seq

PyTorch教程-10.6. 编码器-解码器架构

PyTorch教程-10.5。机器翻译和数据集