如何入门面向自动驾驶领域的视觉Transformer?

基于 Transformer 的分割与检测方法

2D Transformer 可以帮助3D表示学习吗?

端到端自动驾驶到底是什么?

单张图像超分辨率和立体图像超分辨率的相关工作

基于Transformer的大型语言模型(LLM)的内部机制

Transformer在下一个token预测任务上的SGD训练动态

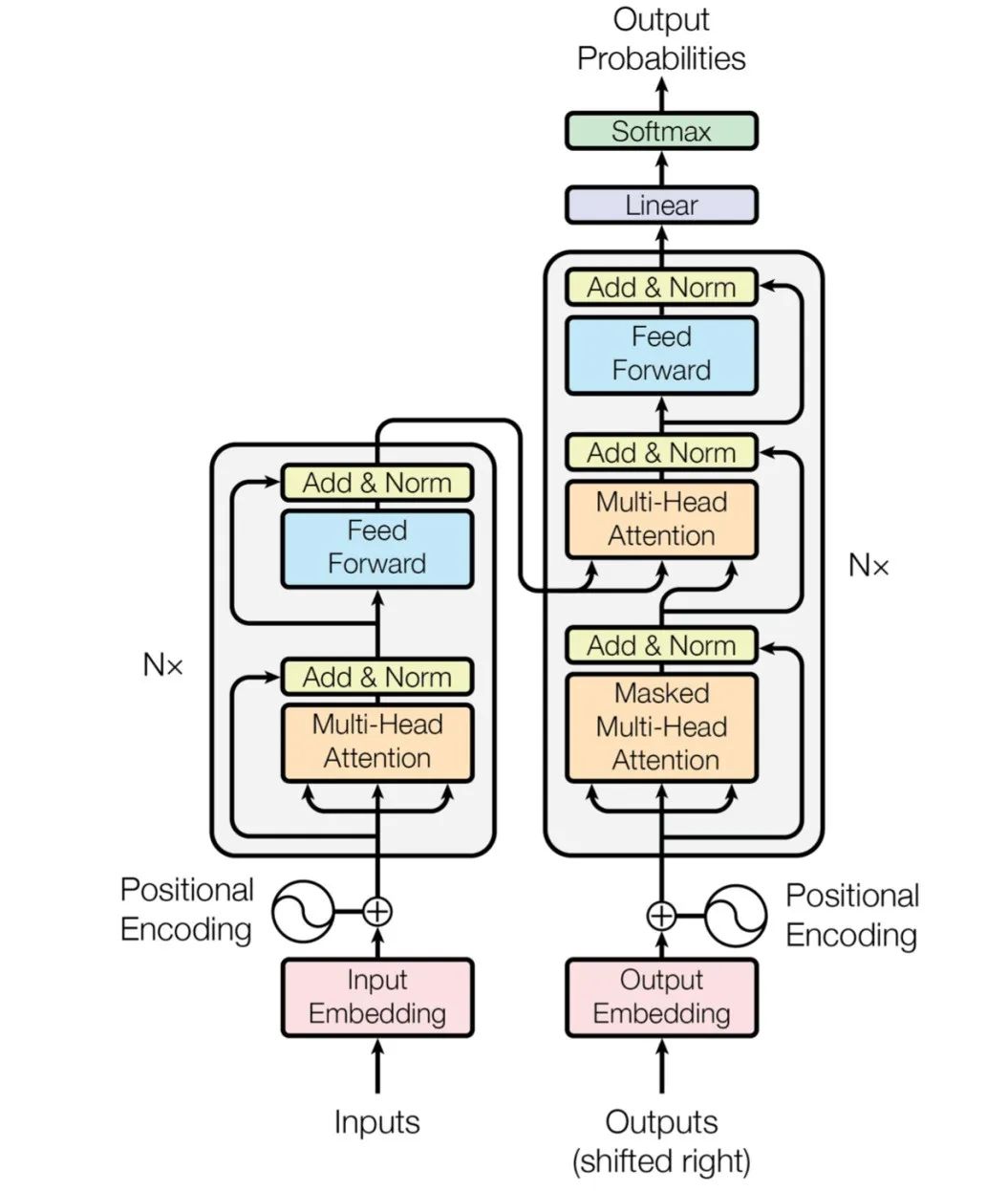

基于transformer的编码器-解码器模型的工作原理

PyTorch教程-11.9. 使用 Transformer 进行大规模预训练

基于Transformer做大模型预训练基本的并行范式

目标跟踪新的建模方式

关于Transformer的核心结构及原理

ChatGPT语言模型核心技术之Transformer

如何利用Transformers了解视觉语言模型

如何让Transformer在征程5上跑得既快又好?以SwinT部署为例的优化探索

一个给NLP领域带来革新的预训练语言大模型Bert

ChatGPT的技术成份有多高

浅谈ChatGPT的技术架构

ChatGPT的特点及原理

ChatGPT的核心要点