资料下载

过应用程序远程关闭车库开门器

描述

我的妻子对我不断地打开车库门感到沮丧。老鼠会在一夜之间进来,我们会在房子的陷阱里找到它们。当然,我可以为我的车库开门器买一个便宜的 Wifi 适配器,然后通过应用程序远程关闭它们,但那有什么乐趣呢?我想我可以使用我新购买的 Google AIY Vision 套件,看看我可以用计算机视觉做什么!

对于那些想要熟悉 Vision Kit 的人,它由一个 Raspberry Pi Zero WH、一个 Raspberry Pi V2 相机和一个 Vision Bonnet(一个 Myriad 2450 ML 加速器)以及其他一些东西(LED、蜂鸣器)组成。在尝试了微笑检测器和其他示例之后,我想使用该套件。

我将套件放在一个小架子上,该架子安装在车库中,面向车库门。完全可选,但我将套件插入智能插头,因此它可以在晚上断电并在早上启动(它在一夜之间运行有什么意义?)。

首先,我需要为计算机视觉模型收集一些数据。我编写了一个简单的 Python 脚本来拍摄照片并使用时间戳保存。然后我设置了一个 cron 作业,从日出到日落每小时运行一次该脚本。我这样做了大约一周,以获得模型的良好照明范围和不同状态(一扇门打开,两扇门打开,两扇门都关闭,车库空,车库里有 1 或 2 辆车)。Python脚本代码如下:

#!/usr/bin/env python3

#Take some photos of the garage to further improve the image classifier

#Run hourly as a cron job during daylight hours

from datetime import datetime

from picamera import PiCamera, Color

#set the filename path for the garage photos

timenow = datetime.now()

timeStr = timenow.strftime("%m-%d-%Y-%H%M%S")

file_path = '/home/pi/garage_screenshots/garage_' + timeStr + '.jpg'

with PiCamera(sensor_mode=4, resolution=(1640, 1232), framerate=30) as camera:

camera.capture(file_path)

一旦我有足够的照片,我就利用了 Vision Kit教程中的Google Colab 。它运行一个默认的花卉分类模型,所以我不得不用我车库里的照片替换花卉照片。鉴于 Colab 只是一个临时实例,您必须在每次运行时将照片上传到 Colab。能够使用 Google GPU 来训练您的模型需要付出很小的代价。我创建了一个带有 2 个子文件夹的garage_photos 文件夹:打开和关闭。这些子文件夹与您将从模型中获得的推理标签对齐。我在打开的文件夹中填充了至少一个车库门打开的照片,并在关闭的文件夹中填充了两扇门都关闭的照片这是我在 Colab 中所做的更改:

python scripts/retrain.py \

--bottleneck_dir=tf_files/bottlenecks \

--how_many_training_steps=500 \

--model_dir=tf_files/models/ \

--summaries_dir=tf_files/training_summaries/$ARCHITECTURE \

--output_graph=tf_files/retrained_graph.pb \

--output_labels=tf_files/retrained_labels.txt \

--architecture=$ARCHITECTURE \

--image_dir=tf_files/garage_photos

所有其他步骤保持不变。我将 Google Colab 的本地副本保存到我的 Google Drive,这样我就不必每次运行 Colab 时都更新它。根据输出,我的模型在验证和测试数据方面的准确度低于 90 年代。对我来说已经足够好了,我可以不断添加更多照片来改进模型结果。

Colab 完成后,我下载了模型(创建了两个文件:retrained_graph.binaryproto 和 retrained_labels.txt)并将它们复制到 Raspberry Pi Zero。

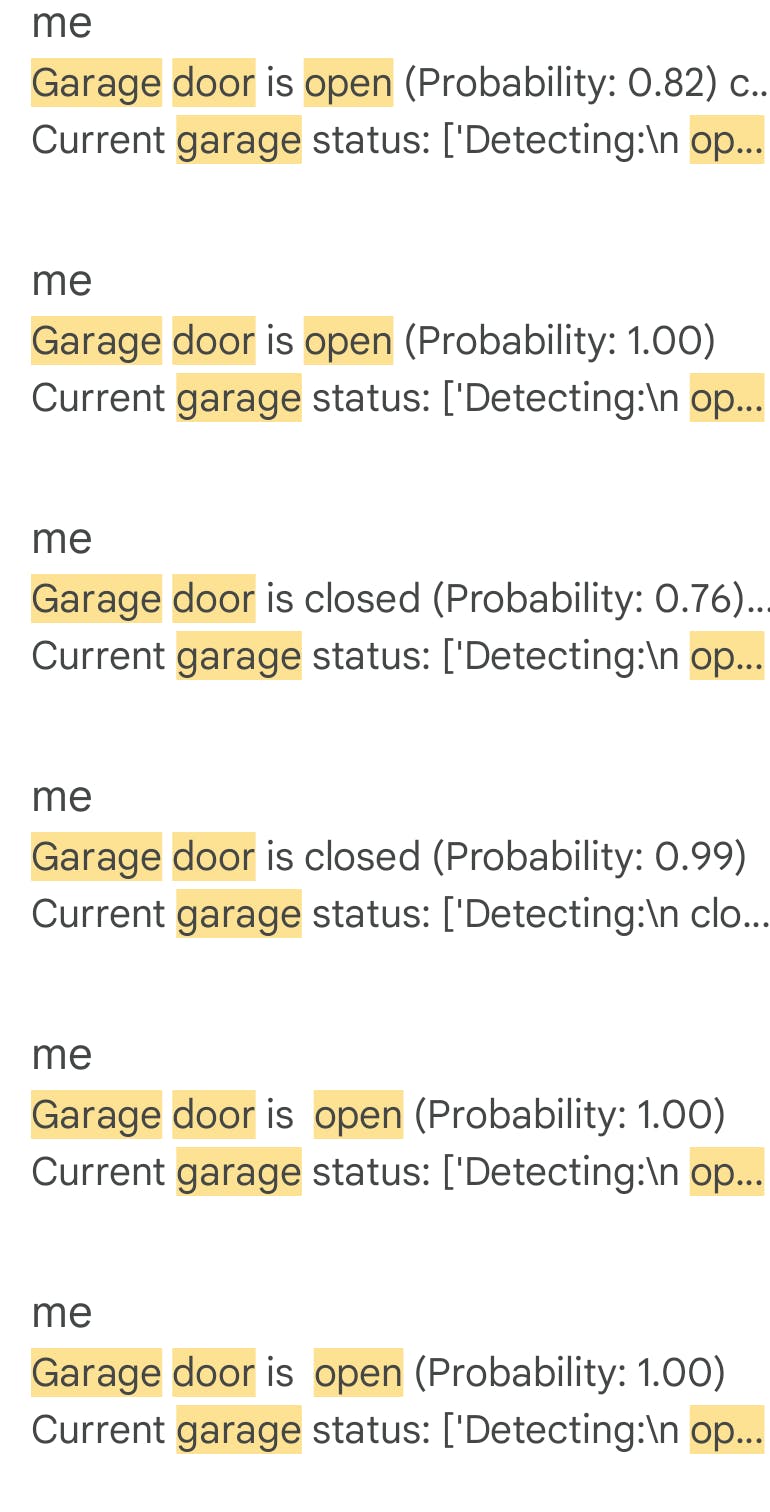

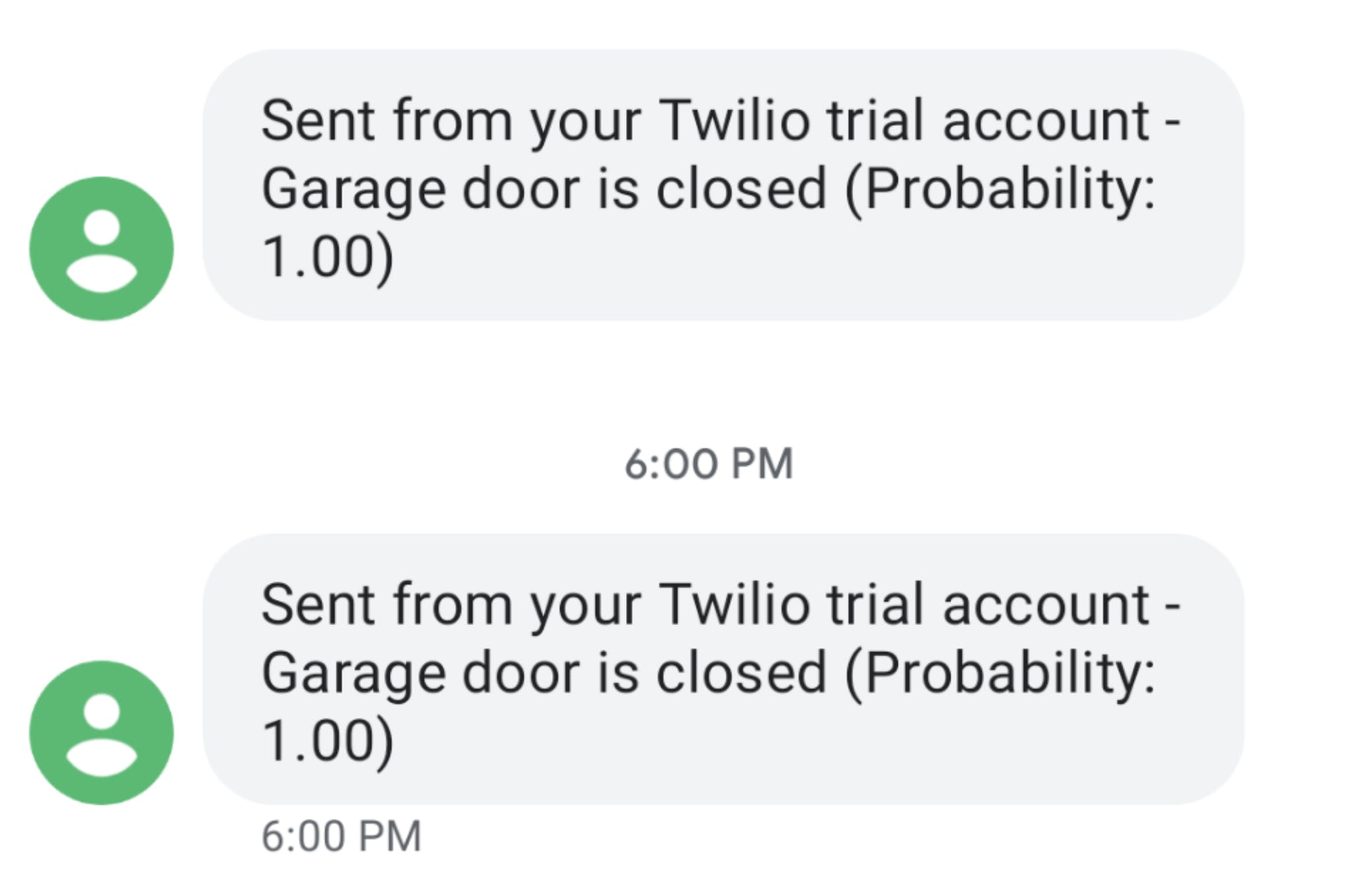

现在,检查车库门状态的脚本!我也保持这个简单,添加一个 cron 作业来只运行一次脚本(接近黄昏,所以我改变时间,因为我们得到更多或更少的阳光)。我*大量*利用 Google 的mobilenet_based_classifier.py Python 脚本来输入模型参数并运行推理。结果出来后,我拍摄了一张相机(只是为了验证推理结果)并使用 smtplib 将车库门的状态和照片通过电子邮件发送给我和我的妻子。我还设置了一个 Twilio 试用帐户,以使用 Twilio API 发送车库门状态的文本消息(虽然没有图像,以保持更便宜)。当 cronjob 运行时,成功!

未来的改进?

下一个是什么?我认为下一步对我来说是自动化它!如果车库门是开着的,我还是得下楼把它关上。那是多大的痛苦?:) 如果程序检测到车库门是打开的,为什么不让程序关闭它呢?

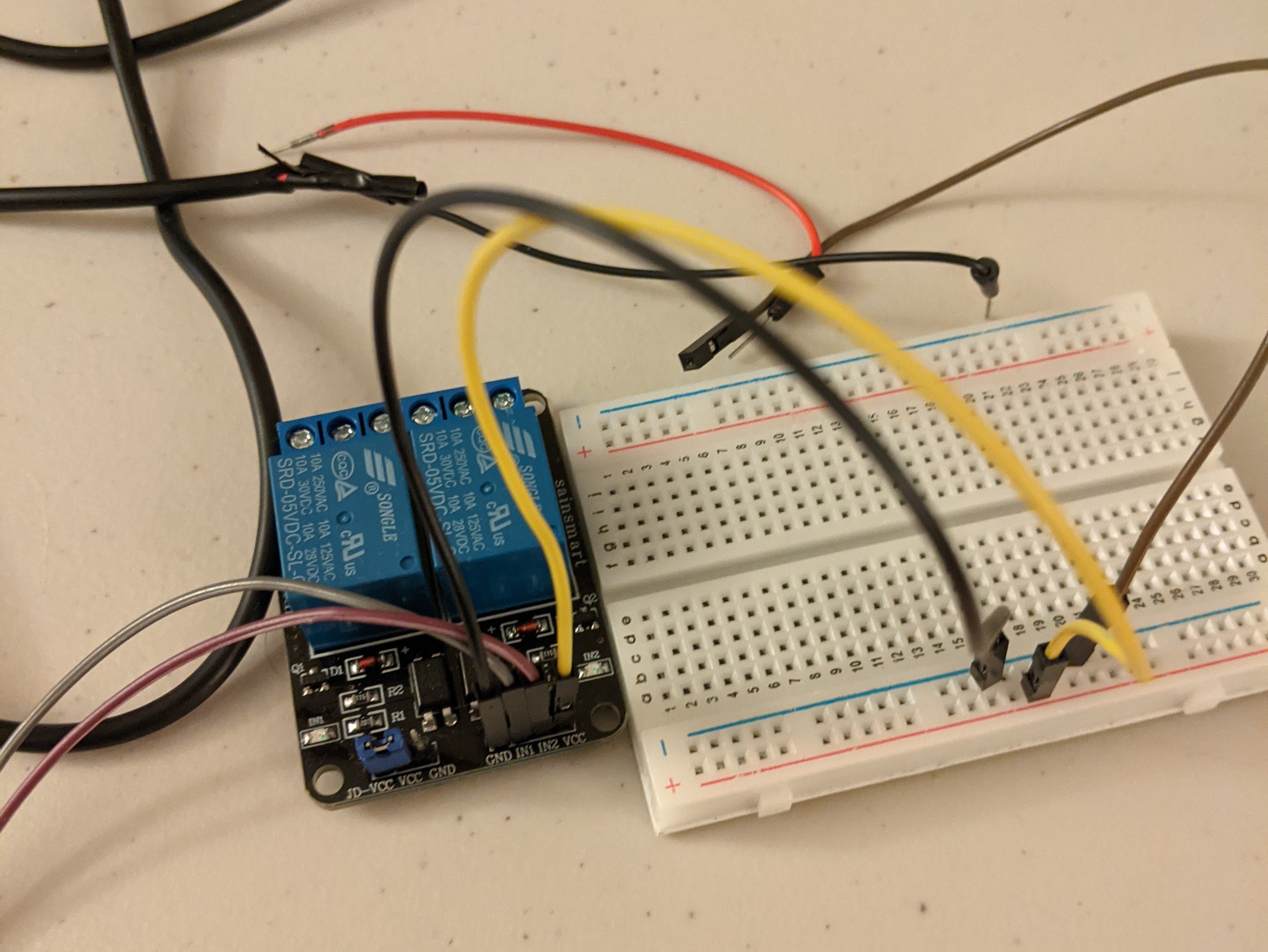

这将是该项目的第 2 版。我开始使用视觉套件测试一个 2 通道继电器开关,并且我能够运行一个简单的脚本来打开和关闭每个继电器(但是男孩,鉴于它是一个Raspberry Pi 上带有 3.3V 逻辑的 5V 继电器!)。我计划将继电器的电线连接到车库门开启器的按钮,并在程序检测到门打开时触发它们。我还必须更新模型以区分两个车库门。现在我的模型只关心一扇门是开着还是关着。

我希望你喜欢这个项目。了解 Vision Kit 的内部工作原理,然后将其重新用于我家的实用工具,这很有趣。随时给我留下任何评论和/或反馈。谢谢!

声明:本文内容及配图由入驻作者撰写或者入驻合作网站授权转载。文章观点仅代表作者本人,不代表电子发烧友网立场。文章及其配图仅供工程师学习之用,如有内容侵权或者其他违规问题,请联系本站处理。 举报投诉

- 相关下载

- 相关文章