在RTX 4090被限制的时代下,让大模型使用RLHF更高效的方法来了

谷歌重磅新作PaLI-3:视觉语言新模型!更小、更快、更强

高性能计算与多模态处理的探索之旅:英伟达GH200性能优化与GPT-4V的算力加速未来

CPU后端和CUDA后端的执行代码和效果

ChatGPT是怎么实现的

行人摔倒检测-在英特尔开发套件上基于OpenVINO™ C# API部署PP-Human

清华&港大提出LanguageMPC:将大语言模型和MPC相结合的新型类人智驾系统

DISC-LawLLM:复旦大学团队发布中文智慧法律系统,构建司法评测基准,开源30万微调数据

华为提出Sorted LLaMA:SoFT代替SFT,训练多合一大语言模型

DreamLLM:多功能多模态大型语言模型,你的DreamLLM~

最新研究综述——探索基础模型中的“幻觉”现象

实现移动版GPT有哪些方法?

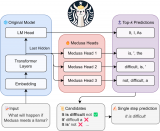

Medusa如何加速大型语言模型(LLM)的生成?

TextBind:在开放世界中多轮交织的多模态指令跟随

Falcon-7B大型语言模型在心理健康对话数据集上使用QLoRA进行微调

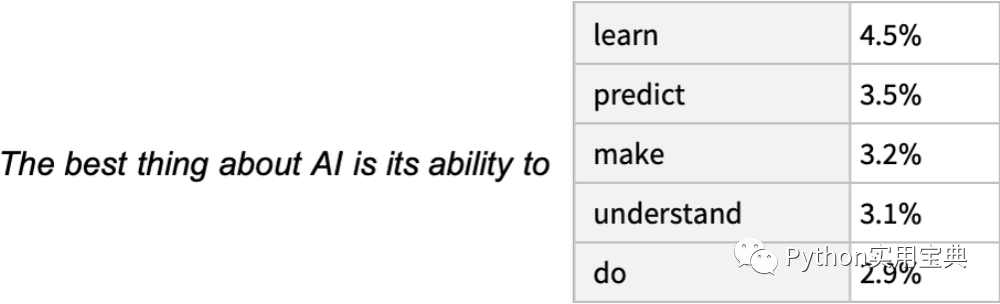

从原理到代码理解语言模型训练和推理,通俗易懂,快速修炼LLM

开源大模型FLM-101B:训练成本最低的超100B参数大模型

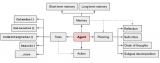

AI Agents的框架构成以及LLMs的基础知识

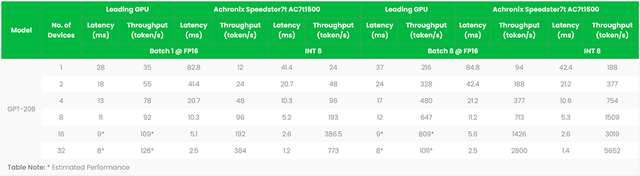

FPGA加速器支撑ChatGPT类大语言模型创新

中科大&字节提出UniDoc:统一的面向文字场景的多模态大模型