资料下载

修补Edge Impulse为MCU创建图像、音频和运动分类模型

描述

当我还是个孩子的时候,我对毒藤的反应非常糟糕:疼痛、发痒的皮疹需要去看医生以获得强效药物。毒藤很难识别,并且在难以接收手机信号的地方(森林、远足小径、偏远地区)被发现。拥有一个可以识别低功耗且不需要互联网连接的毒藤(或其他坏东西)的边缘设备不是很酷吗?

在过去的一年里,我开始尝试使用 TinyML,最近从 Arducam 购买了 Pico4ML 。我很感兴趣,因为它配备了 Raspberry Pi RP2040 MCU、单色摄像头、小型 LCD 显示器、麦克风和 IMU,所有这些都在一个小尺寸中。我慢慢开始玩这些演示以了解它可以做什么。我还开始修补 Edge Impulse,为各种 MCU 创建图像、音频和运动分类模型。

当“ Eyes on Edge: tinyML Vision Challenge ”宣布时,我决定尝试测试我的新技能!

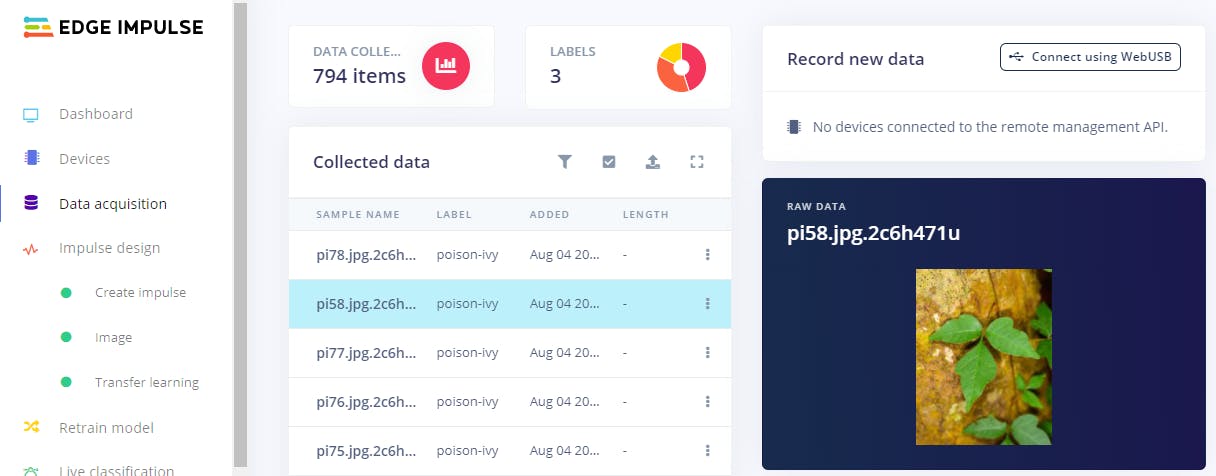

我从 Edge Impulse 开始并拍摄照片来填充我的图像分类模型。我开发了 3 个类别:毒藤、非毒藤植物和未知植物(不是植物的随机物品的照片)。我遵循了 Edge Impulse关于如何开发模型的指导。我使用我女儿的小型数码相机拍照并将图像批量上传到我的 Edge Impulse 项目。

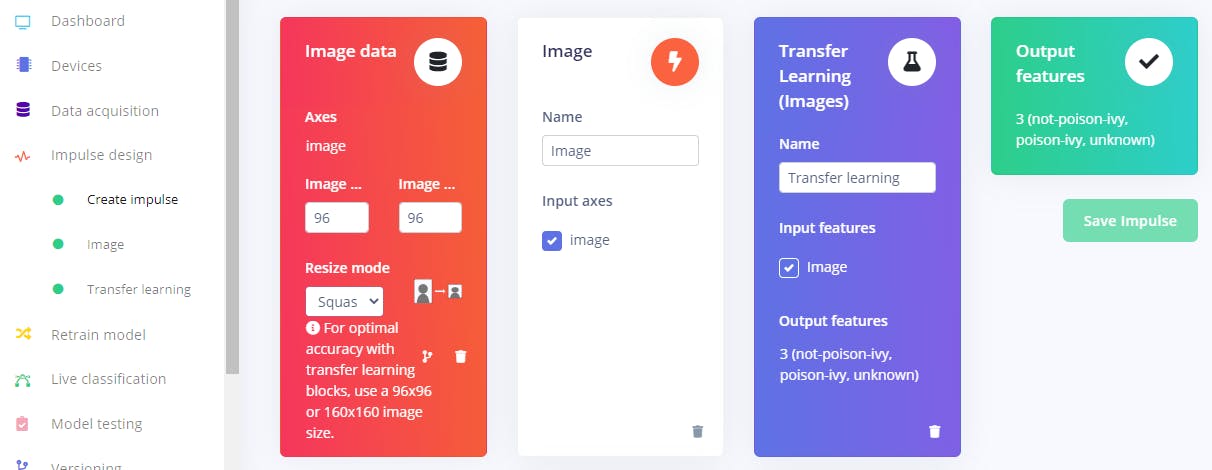

之后我设计了冲动。为了与 Pico4ML 的约束保持一致,我选择了 96x96 单色图像并使用 Edge Impulse 建议的默认图像和迁移学习块。

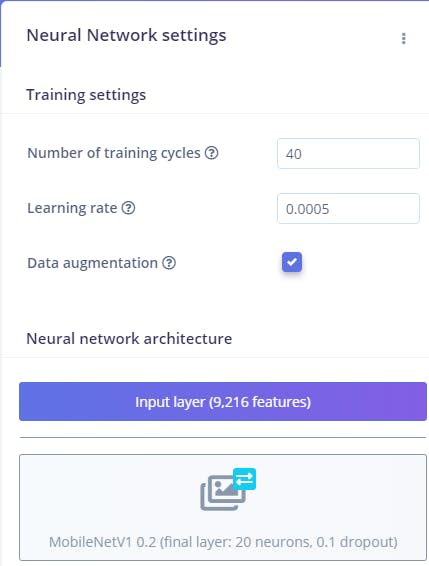

我选择 MobilenetV1 0.2 作为模型,同样是因为 Pico4ML 的内存限制。虽然不理想,也不是最准确的,但对于应用程序和硬件来说已经足够了。二十个神经元似乎产生了最好的结果。我还为更多样化的数据集选择了数据增强。

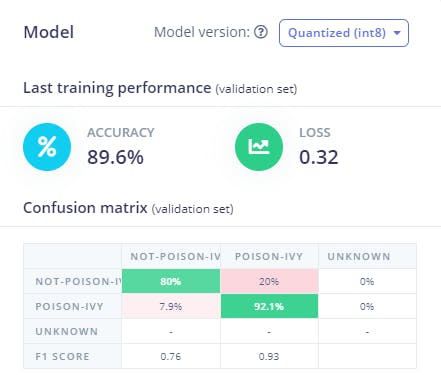

选择这些参数后,我训练了模型。结果如下:

对于几百张图片来说还不错!这当然不是最好的模型,对于看起来像毒藤但不是的植物有些混淆。我认为通过毒藤和类似植物(即荆棘叶和黑莓叶)的附加质量图像可以进一步改进模型。

构建并测试模型后,我将其导出到 C++ 库以集成到我的项目中。现在,我没有在 1 次迭代中完成这项工作。在要使用的照片数量/质量和模型类型方面进行了大量试验(我使用的第一个模型对于 Pico4ML 来说太大了,而且内存不足)。我没有意识到我必须经历多少次迭代!

我在 Raspberry Pi 4B 上进行了开发,因为那似乎是最简单的界面。我处理了 Pico4ML github上的代码/指令。我使用 person_detection 演示作为起点,这样我就可以了解图像是如何被接收的,以及它们是如何传递给 ML 算法的。这是我花费*大量*时间的地方,我感谢 Edge Impulse 团队一直支持我并在他们的论坛上为我回答问题。

该演示使用 tensorflow lite 微型模型,因此在设置和推理方面,界面与 Edge Impulse 模型有很大不同。对于那些合法的编码员来说,这可能不是什么大问题,但对于那些十多年没有编码的人来说,让 Edge Impulse 模型与硬件正常工作是一个漫长的过程(请参阅上面的注释我的原始模型对于硬件来说太大并且导致内存问题)。

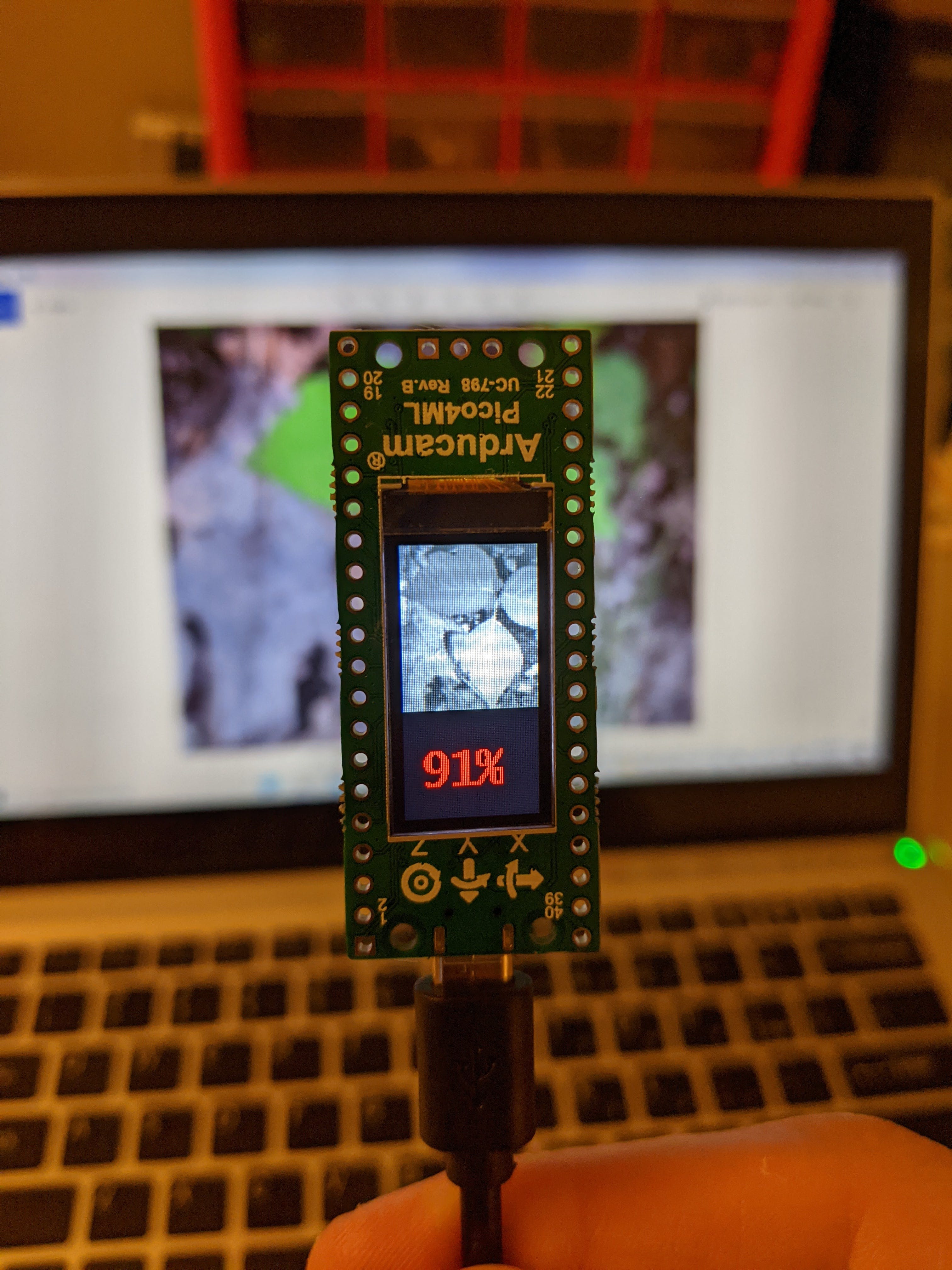

一旦我确信我让它工作了,我的现场结果并不像我希望的那样令人印象深刻,所以我继续改进模型,直到我觉得它“足够好”。下图显示了从相机接收到的图像,以及该图像是毒藤的概率。如果概率大于 60%,数字变为红色:小心!

这是一个有趣的练习,我真的觉得它处于 TinyML 的流血“边缘”。Pico4ML 是低功耗的,所以我可以用一个简单的 5V 手机电池充电器给它断电。我的 USB 数据线有一个开/关开关,因此只需点击一下,对图像进行分类,然后点击关闭。对于电力和互联网不可用的偏远地区非常有效。

该项目的未来扩展可能是对您在远足露营时想在偏远地区了解的其他“坏”东西进行分类:“这种浆果有毒吗?这种蘑菇怎么样?” 随着 MCU 变得更强大,可以使用具有更好输入的更好模型(例如,使用彩色图像而不是单色图像)。其他改进可能是多个类(而不是我这里的二进制分类),最终是对象检测!

这是我提交给 hackster.io 的第一个项目,希望你喜欢它!

声明:本文内容及配图由入驻作者撰写或者入驻合作网站授权转载。文章观点仅代表作者本人,不代表电子发烧友网立场。文章及其配图仅供工程师学习之用,如有内容侵权或者其他违规问题,请联系本站处理。 举报投诉

- 相关下载

- 相关文章