资料下载

使用Edge Impulse识别大象活动

描述

在这个项目中,我使用Edge Impulse Studio创建了一个深度学习模型来检测大象的活动。训练使用 3 轴加速度计和 3 轴陀螺仪数据。最终模型部署到 Arduino Nano 33 BLE Sense,并使用移动应用程序通过 BLE 连接显示推理结果。

数据采集

我找不到任何可在公共领域自由使用的大象活动/运动/方向数据。我使用了一个Goat Sheep Dataset来训练一个模型,该模型可以免费下载,并且可以与引用以下论文一起使用:

Jacob W. Kamminga、Helena C. Bisby、Duv V. Le、Nirvana Meratnia 和 Paul JM Havea。项圈标签上的通用在线动物活动识别。在2017 年 ACM 普适和普适计算国际联合会议 (UbiComp/ISWC'17) 论文集上。2017年 9 月

有关数据集链接,请参阅上面的论文。

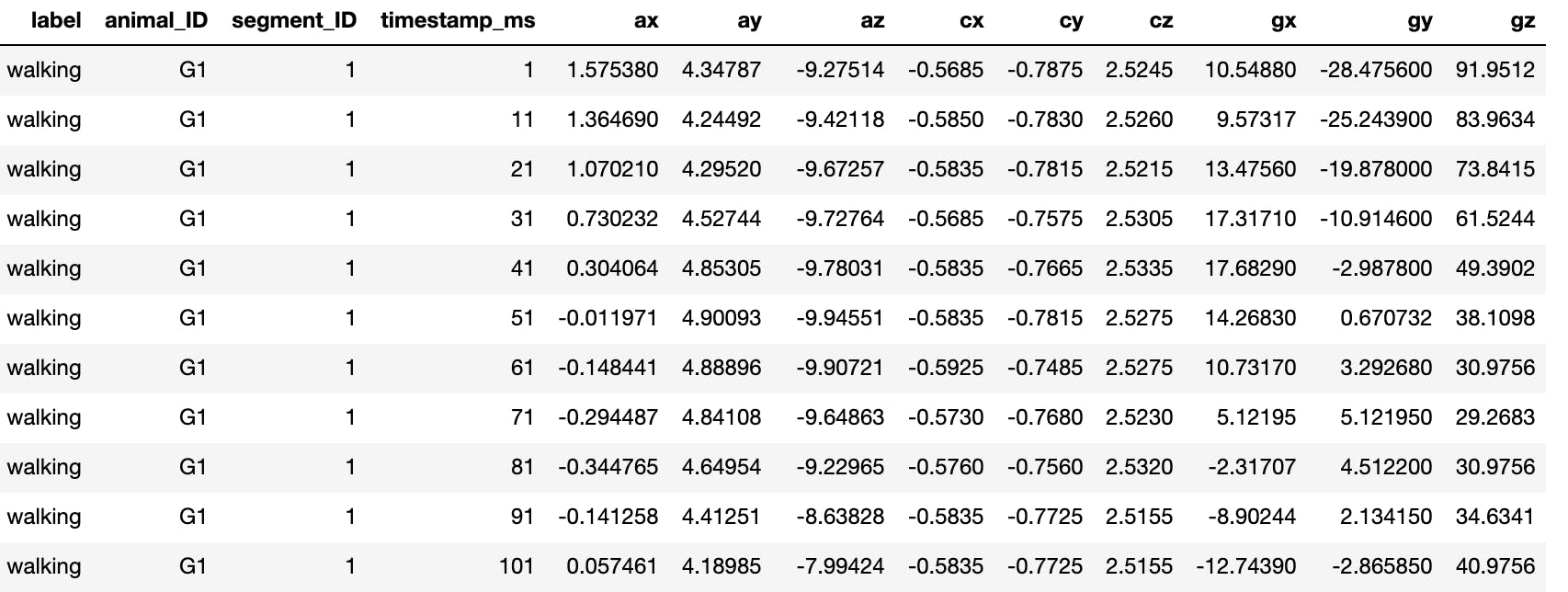

他们收集了这个数据集,其中包含来自四只山羊和两只绵羊的多个传感器数据。这些动物的体型、体重和年龄各不相同,但属于同一个山羊亚科。他们在每只动物身上随机放置不同方向的传感器。传感器总是放在脖子上。白天,项圈容易绕着动物的脖子旋转。所有传感器均以 200 个样本/秒的速度进行采样。他们收集了以下运动传感器:3 轴加速度计、3 轴高强度加速度计、3 轴陀螺仪、3 轴磁力计、温度、气压。

我只使用了 3 轴加速度计和 3 轴陀螺仪数据。由于我计划将模型部署到 Arduino Nano 33 BLE Sense(加速度计和陀螺仪的默认采样率为 119 Hz),因此我必须删除交替行以将数据保持在 100 个样本/秒。

白天观察到的活动是:躺着、站立、放牧、打架、摇晃、抓挠、走路、小跑和跑步。

我只选择了以下 5 项与大象相关的活动。

躺着:动物躺在地上。

站立: 动物静止不动,偶尔移动头部或非常缓慢地迈步。

放牧:动物正在吃新鲜的草、一堆干草或地上的树枝。

行走:动物在行走。

奔跑:动物在奔跑。

数据样本

与其他活动相比,跑步活动的数据非常少。它出现了训练数据集不平衡的问题。我将小跑(走得非常快)活动与跑步相结合来克服这个问题。

我创建了一个 Jupyter Notebook 来清理、过滤和生成数据采集格式的 json 文件,以将数据上传到 Edge Impulse Studio。

示例 Json 文件(文件:running.S2_605.json)

生成文件名以制作示例的标签,在本例中为运行.

{

"protected": {

"ver": "v1",

"alg": "HS256",

"iat": 1603881609.210776

},

"signature": "13b115654acabe82e12872097c66cbdaf46a3acce4c5eb863a0c50b171fa5a80",

"payload": {

"device_name": "" ,

"device_type": "ARDUINO_NANO33BLE",

"interval_ms": 10,

"sensors": [{

"name": "accX",

"units": "m/s2"

},

{

"name": "accY",

"units": "m/s2"

},

{

"name": "accZ",

"units": "m/s2"

},

{

"name": "gyrX",

"units": "d/s"

},

{

"name": "gyrY",

"units": "d/s"

},

{

"name": "gyrZ",

"units": "d/s"

}

],

"values": [

[

1.03669,

3.9241,

-4.20182,

-16.9512,

-4.87805,

-43.7195

],

[

0.567426,

4.97515,

-3.44286,

-14.878,

-10.7927,

-47.8659

],

[

0.292093,

5.95199,

-2.9329,

-16.2195,

-14.939,

-49.1463

],

[

0.141258,

6.84502,

-2.6575599999999997,

-17.8049,

-18.3537,

-45.0

],

[

0.23702600000000001,

7.62074,

-2.73418,

-17.2561,

-22.561,

-34.6341

],

[

0.5841850000000001,

8.22887,

-3.4811699999999997,

-13.1098,

-26.3415,

-20.7317

],

[

1.13006,

8.781930000000001,

-4.69264,

-3.04878,

-24.6341,

-7.195119999999999

],

[

5.18345,

6.75404,

-7.54413,

-99.2073,

26.2805,

-17.5

]

]

}

}

数据上传

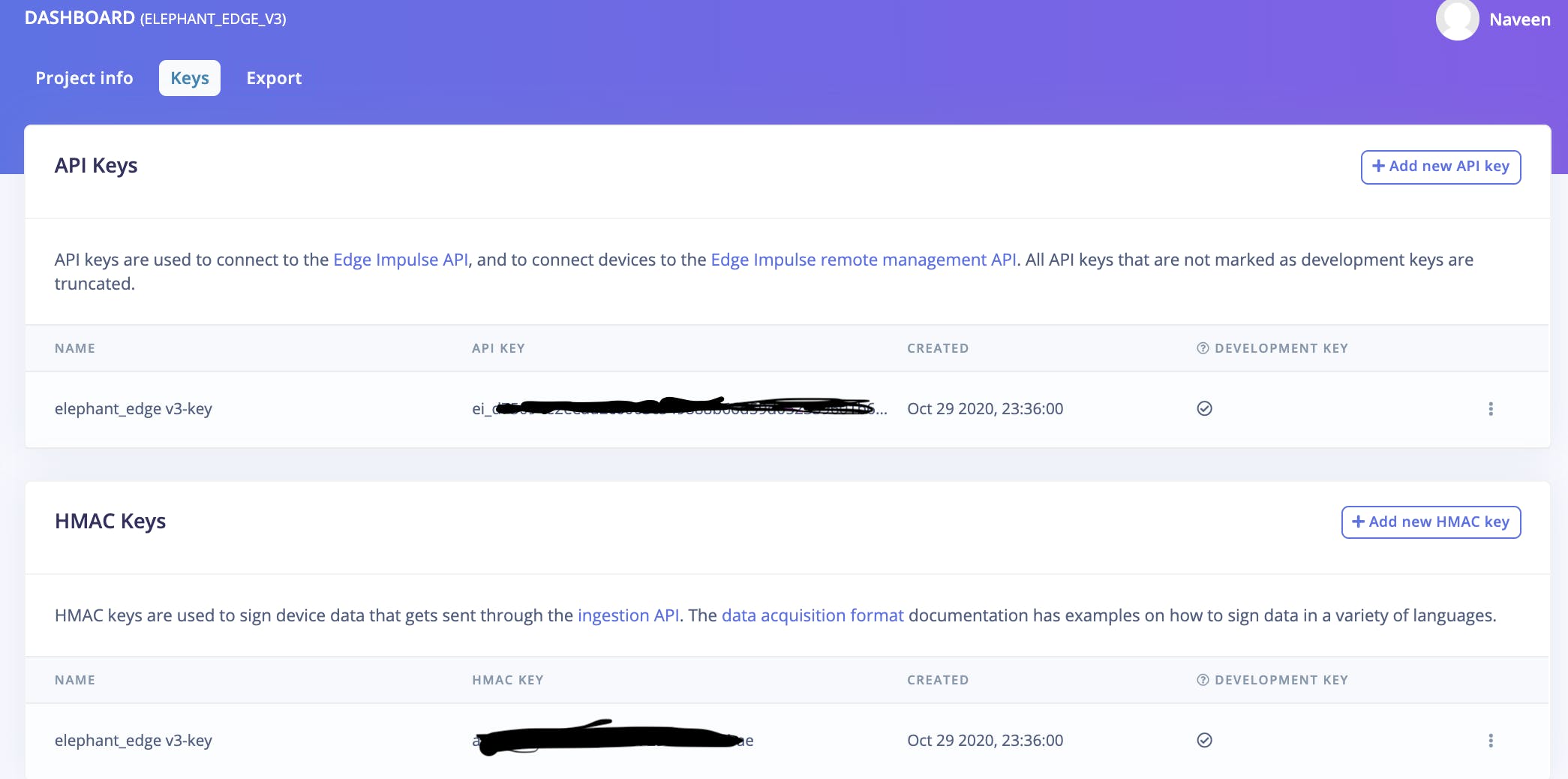

将数据上传到 Edge Impulse 有多种方法,但我使用了 CLI,我觉得这很方便。但首先我们需要在 Edge Impulse Studio 中创建一个帐户,并且需要复制 HMAC KEY,它可以在 Dashboard > Keys 选项卡中找到,如下所示。

Edge Impulse CLI 安装

$ npm insall -g edge-impulse-cli

上传到 Edge Impulse

将目录更改为生成的 json 文件所在的路径,然后执行以下命令。命令行有一个参数--category split ,它会自动将数据拆分为训练和测试数据集。

$ edge-impulse-uploader --category split *.json

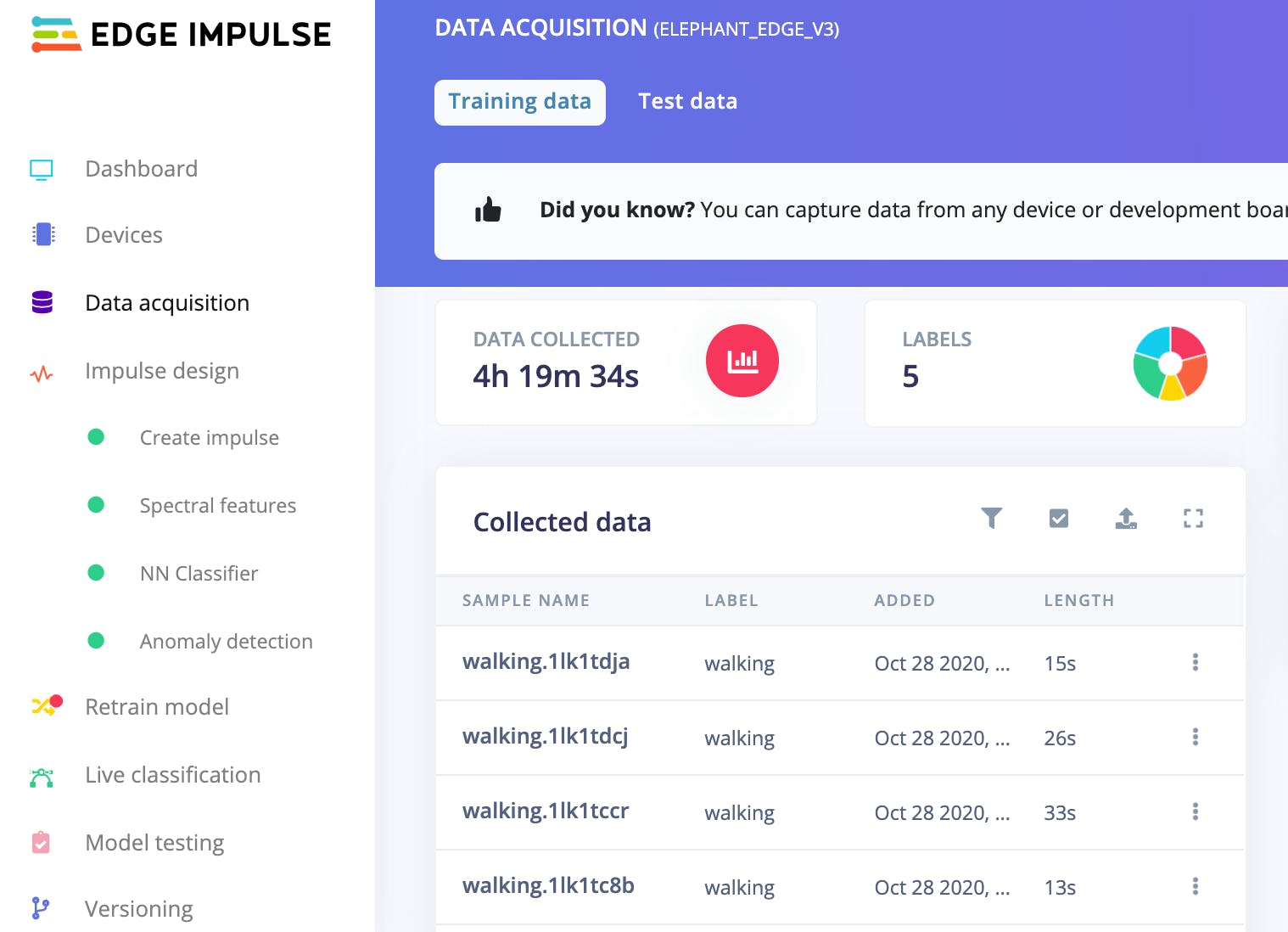

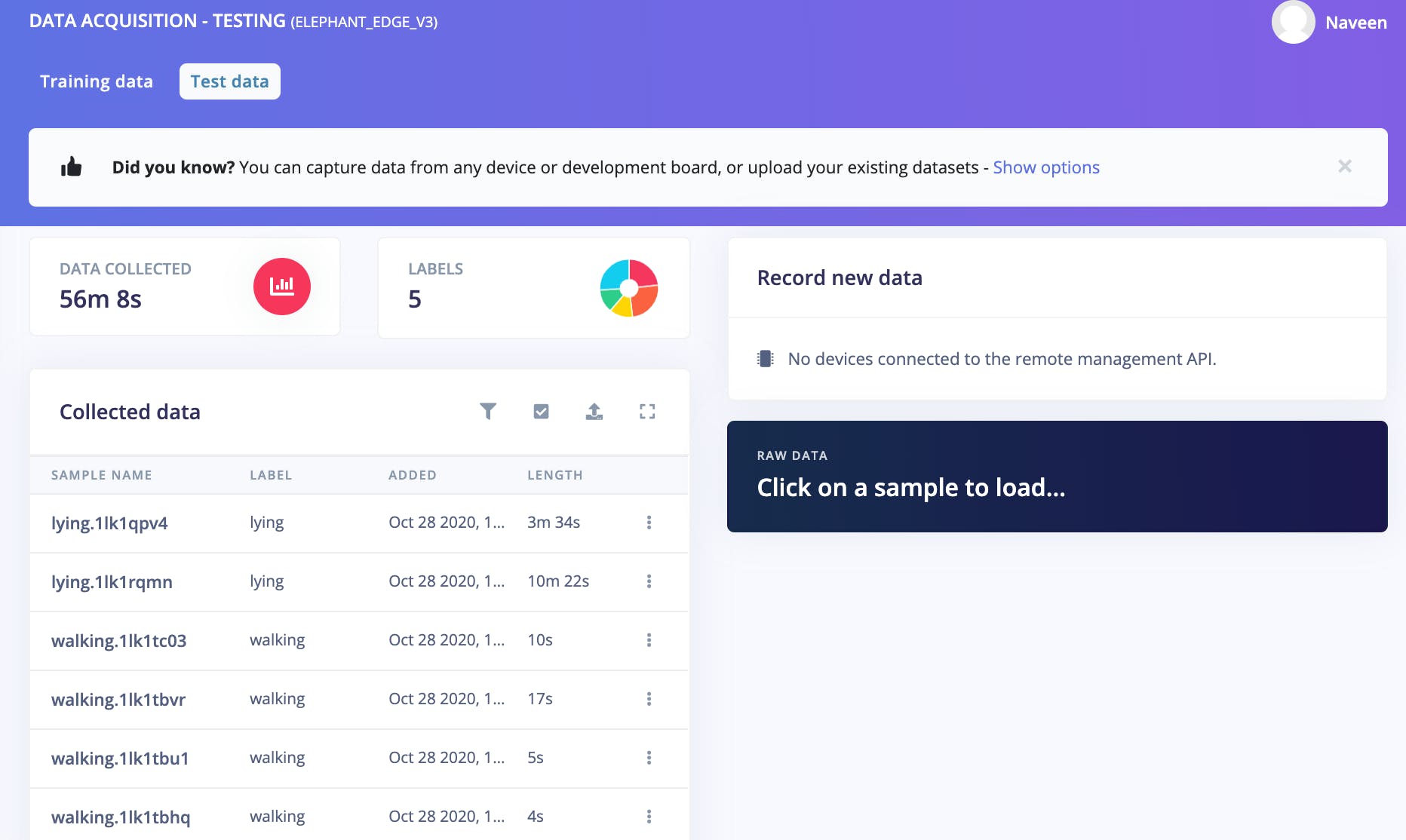

成功上传数据后,我们可以在 Edge Impulse Studio 的 Data Acquisition 选项卡中看到它们,如下所示。

训练数据(4h 19m 34s):

测试数据(56m 8s):

数据是平衡的(80% 训练对 20% 测试),因此我们不需要任何操作,否则我们可以手动拆分数据并可以移动到任一侧。

冲动设计

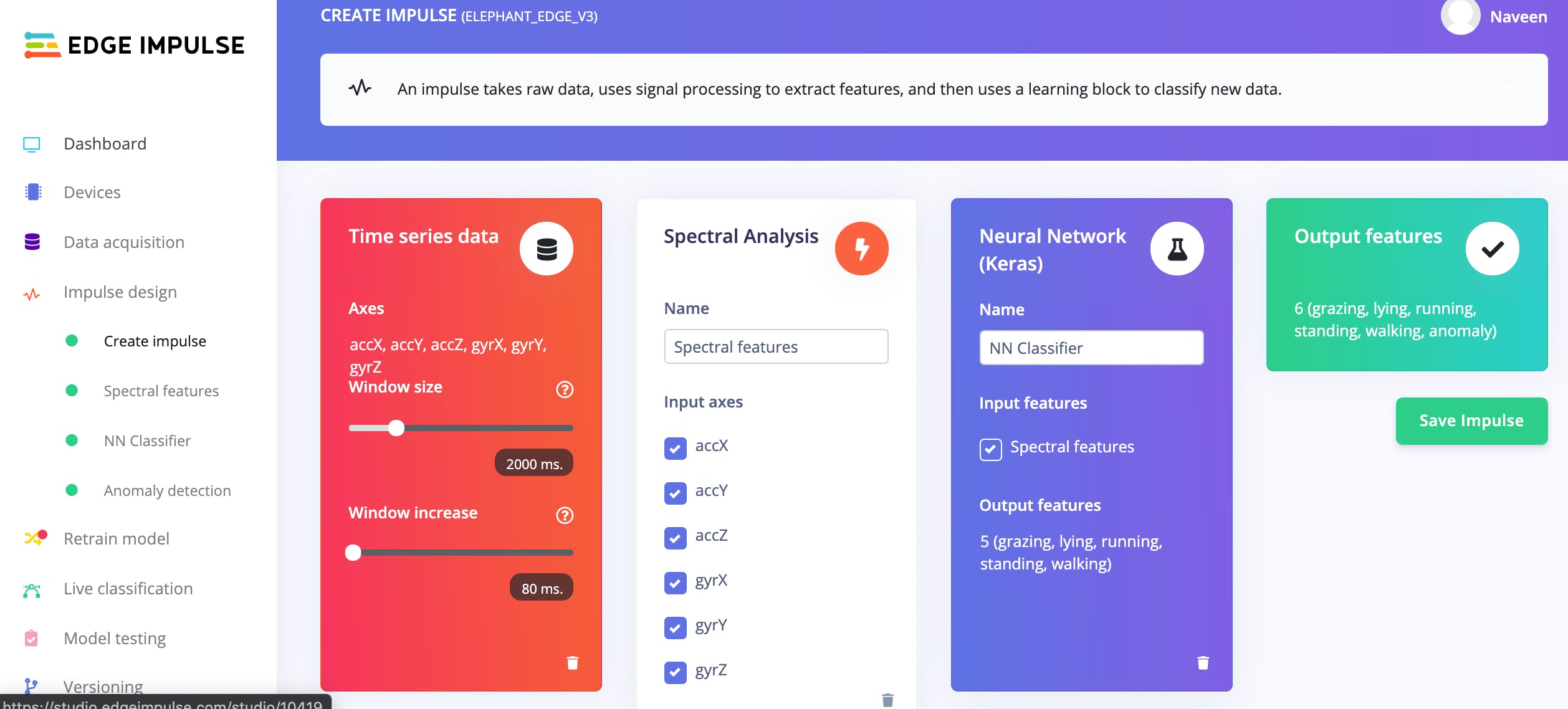

在 Edge Impulse 工作室中,在开始训练之前,我们必须设计一个 Impulse,它是一组预处理块和神经网络分类器。我设计了 Impulse 使用信号分析作为预处理块,它从原始数据和深度神经网络分类器生成特征,如下所示。

特征生成

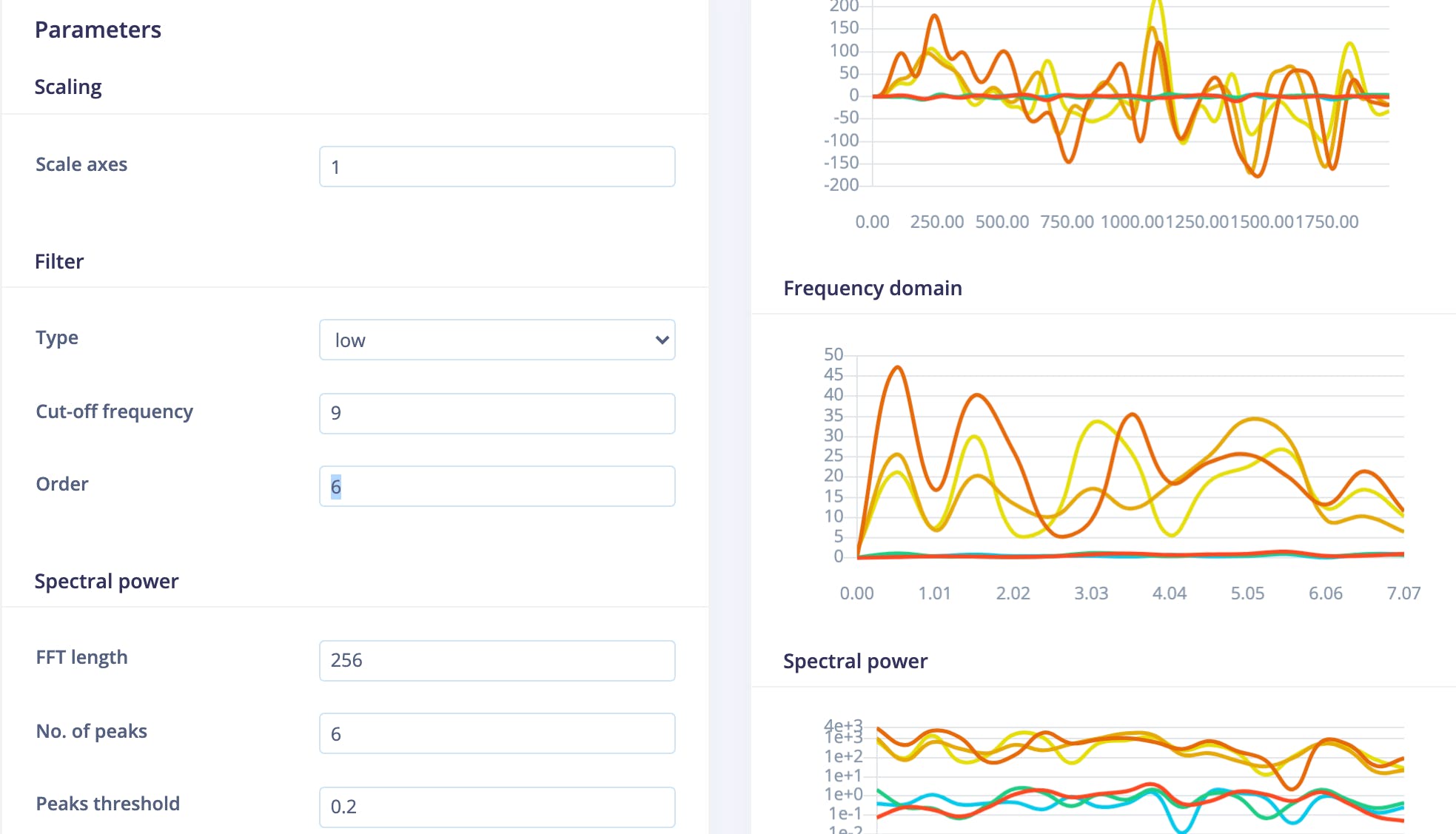

要生成特征,我们必须转到 Spectral Features 选项卡,我们可以在那里配置许多可用选项。一开始我选择了默认配置,在每次训练迭代后,根据实现的模型精度,我必须返回此选项卡并重新配置选项并重新生成特征。下面是我最终模型的配置。我选择了具有 9 Hz 截止频率和 256 FFT 长度的低通滤波器,具有 6 个峰值和 0.2 个峰值阈值。

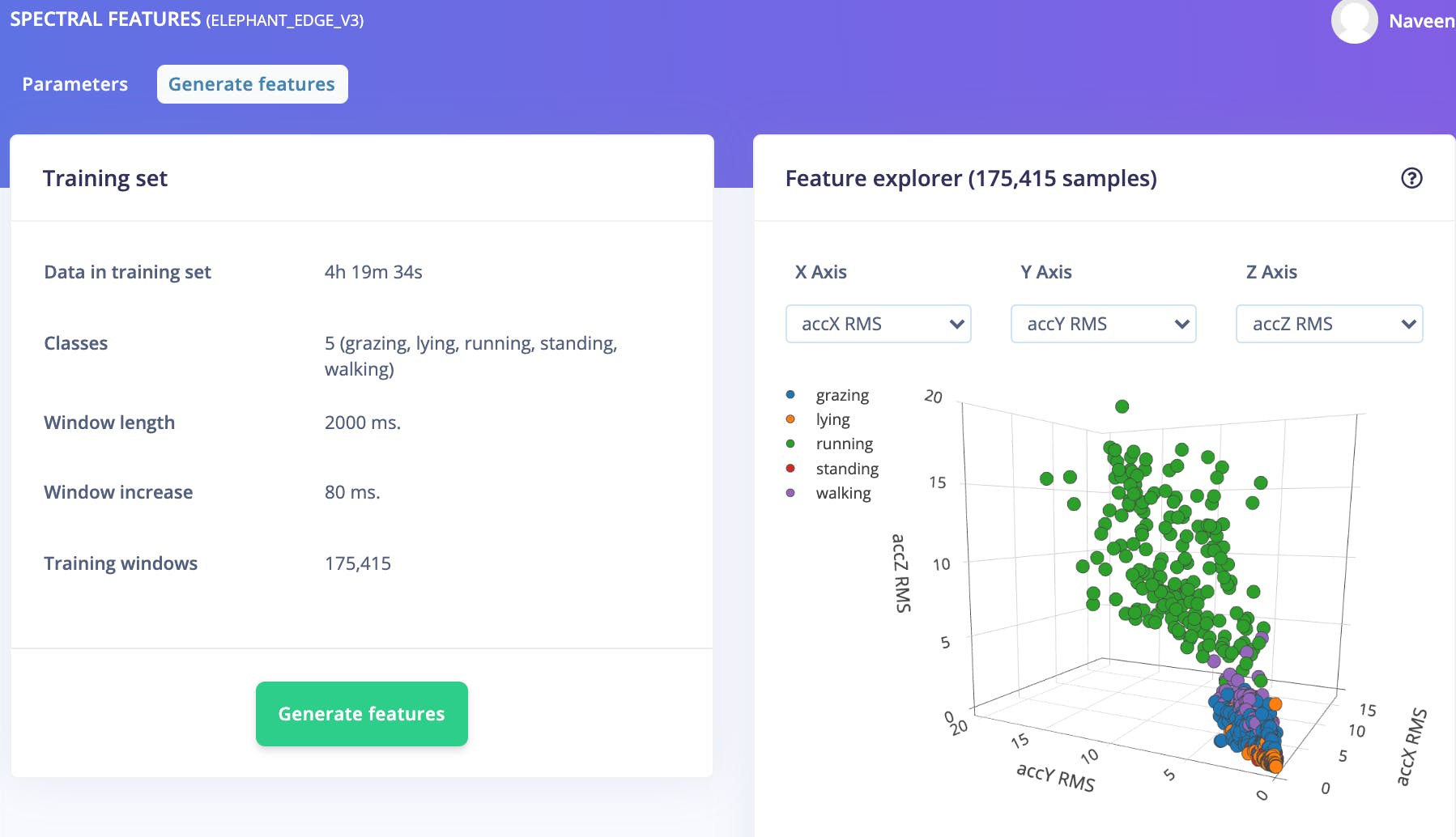

设置好上面的参数后,页面会自动重定向到生成功能页面,我们可以在其中启动作业来完成任务。完成后,我们可以使用 Feature Explorer 通过鼠标指针拖动图像来查看不同 3D 方向的数据。下面是最终模型生成的特征图的图像。

神经网络分类器

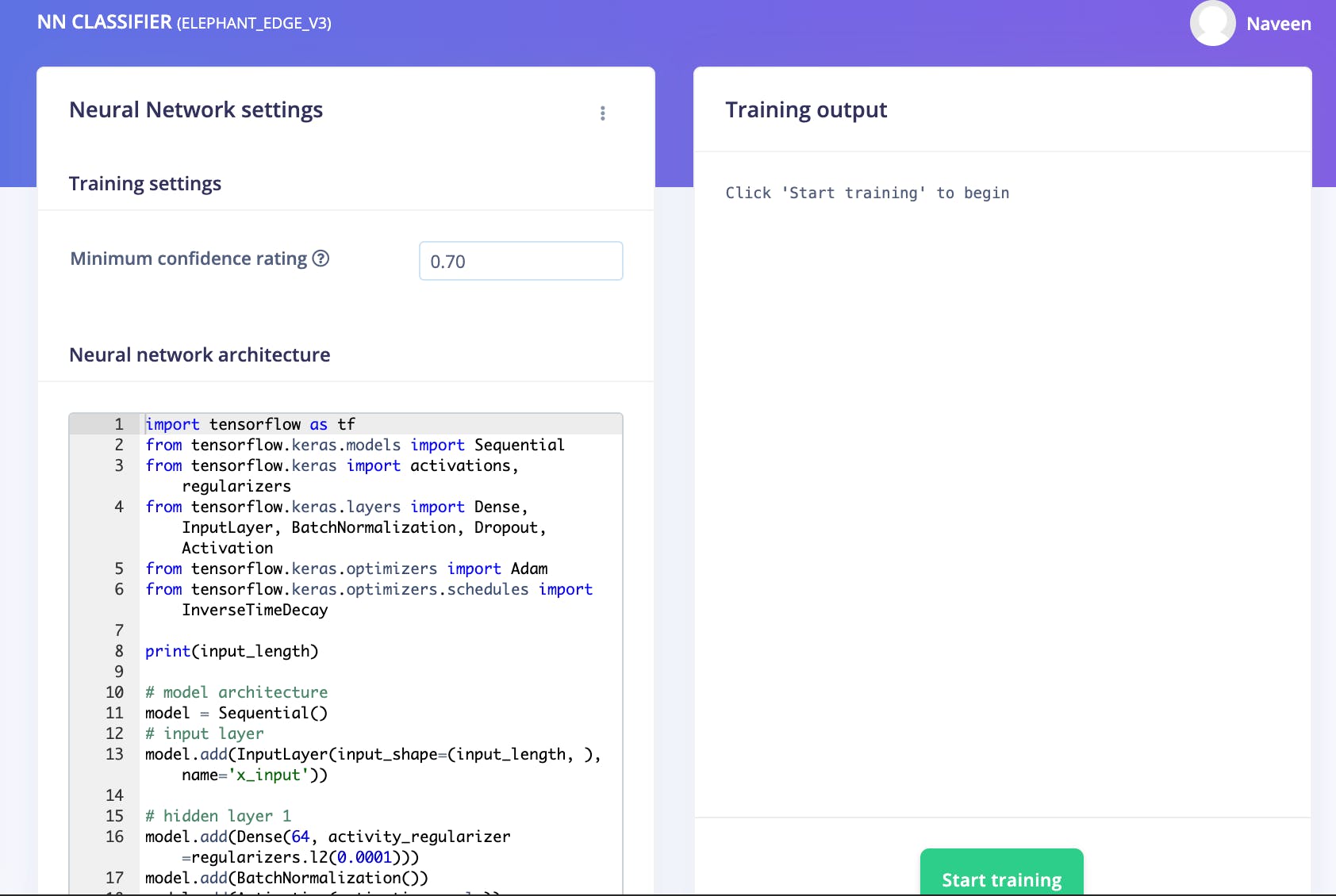

现在我们需要在 NN Classifier 选项卡中创建一个神经网络分类器。我们可以使用默认的可视模式添加多层深度神经网络,也可以使用专家模式直接编写代码来创建 Keras 模型。我使用了专家模式,因为我想要创建的模型需要一些在可视模式下不可用的层,并且我还包含了一些自定义代码来配置学习率并打印一些调试消息。下面是分类器页面的截图:

模型摘要

该模型有 1 个输入层、12 个全连接密集隐藏层和 1 个输出层。每个隐藏层都有 Activation、Dropout 和 BatchNormalization 层。以下是从 Edge Impulse 最终培训课程中摘录的模型摘要。

Model: "sequential"

_________________________________________________________________

Layer (type) Output Shape Param #

=================================================================

dense (Dense) (None, 64) 6592

_________________________________________________________________

batch_normalization (BatchNo (None, 64) 256

_________________________________________________________________

activation (Activation) (None, 64) 0

_________________________________________________________________

dropout (Dropout) (None, 64) 0

_________________________________________________________________

dense_1 (Dense) (None, 64) 4160

_________________________________________________________________

batch_normalization_1 (Batch (None, 64) 256

_________________________________________________________________

activation_1 (Activation) (None, 64) 0

_________________________________________________________________

dropout_1 (Dropout) (None, 64) 0

_________________________________________________________________

dense_2 (Dense) (None, 64) 4160

_________________________________________________________________

batch_normalization_2 (Batch (None, 64) 256

_________________________________________________________________

activation_2 (Activation) (None, 64) 0

_________________________________________________________________

dropout_2 (Dropout) (None, 64) 0

_________________________________________________________________

dense_3 (Dense) (None, 64) 4160

_________________________________________________________________

batch_normalization_3 (Batch (None, 64) 256

_________________________________________________________________

activation_3 (Activation) (None, 64) 0

_________________________________________________________________

dropout_3 (Dropout) (None, 64) 0

_________________________________________________________________

dense_4 (Dense) (None, 64) 4160

_________________________________________________________________

batch_normalization_4 (Batch (None, 64) 256

_________________________________________________________________

activation_4 (Activation) (None, 64) 0

_________________________________________________________________

dropout_4 (Dropout) (None, 64) 0

_________________________________________________________________

dense_5 (Dense) (None, 64) 4160

_________________________________________________________________

batch_normalization_5 (Batch (None, 64) 256

_________________________________________________________________

activation_5 (Activation) (None, 64) 0

_________________________________________________________________

dropout_5 (Dropout) (None, 64) 0

_________________________________________________________________

dense_6 (Dense) (None, 32) 2080

_________________________________________________________________

batch_normalization_6 (Batch (None, 32) 128

_________________________________________________________________

activation_6 (Activation) (None, 32) 0

_________________________________________________________________

dropout_6 (Dropout) (None, 32) 0

_________________________________________________________________

dense_7 (Dense) (None, 32) 1056

_________________________________________________________________

batch_normalization_7 (Batch (None, 32) 128

_________________________________________________________________

activation_7 (Activation) (None, 32) 0

_________________________________________________________________

dropout_7 (Dropout) (None, 32) 0

_________________________________________________________________

dense_8 (Dense) (None, 32) 1056

_________________________________________________________________

batch_normalization_8 (Batch (None, 32) 128

_________________________________________________________________

activation_8 (Activation) (None, 32) 0

_________________________________________________________________

dropout_8 (Dropout) (None, 32) 0

_________________________________________________________________

dense_9 (Dense) (None, 32) 1056

_________________________________________________________________

batch_normalization_9 (Batch (None, 32) 128

_________________________________________________________________

activation_9 (Activation) (None, 32) 0

_________________________________________________________________

dropout_9 (Dropout) (None, 32) 0

_________________________________________________________________

dense_10 (Dense) (None, 32) 1056

_________________________________________________________________

batch_normalization_10 (Batc (None, 32) 128

_________________________________________________________________

activation_10 (Activation) (None, 32) 0

_________________________________________________________________

dropout_10 (Dropout) (None, 32) 0

_________________________________________________________________

dense_11 (Dense) (None, 32) 1056

_________________________________________________________________

batch_normalization_11 (Batc (None, 32) 128

_________________________________________________________________

activation_11 (Activation) (None, 32) 0

_________________________________________________________________

dropout_11 (Dropout) (None, 32) 0

_________________________________________________________________

y_pred (Dense) (None, 5) 165

=================================================================

Total params: 37,221 Trainable params: 36,069 Non-trainable params: 1,152

现在我们可以点击训练按钮并等待它完成。

训练数据的验证准确性

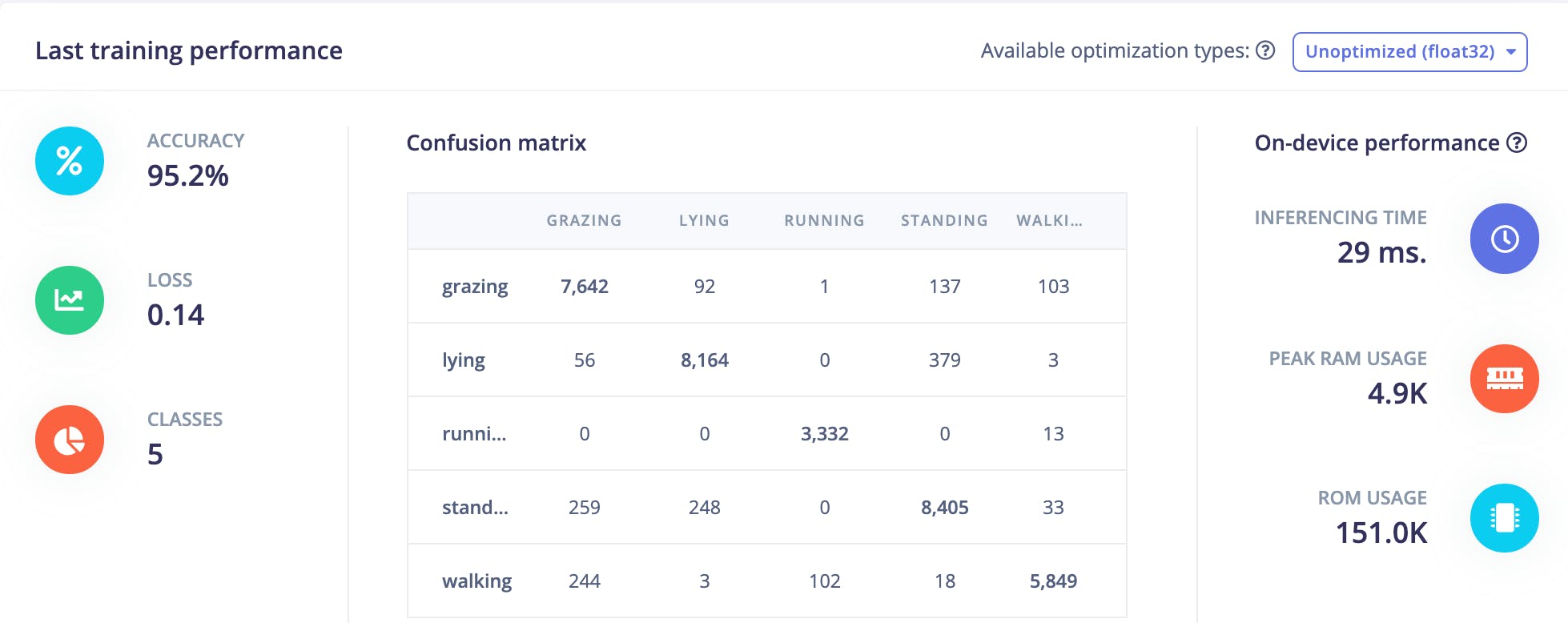

我在训练验证数据上获得了95.2%的准确率。

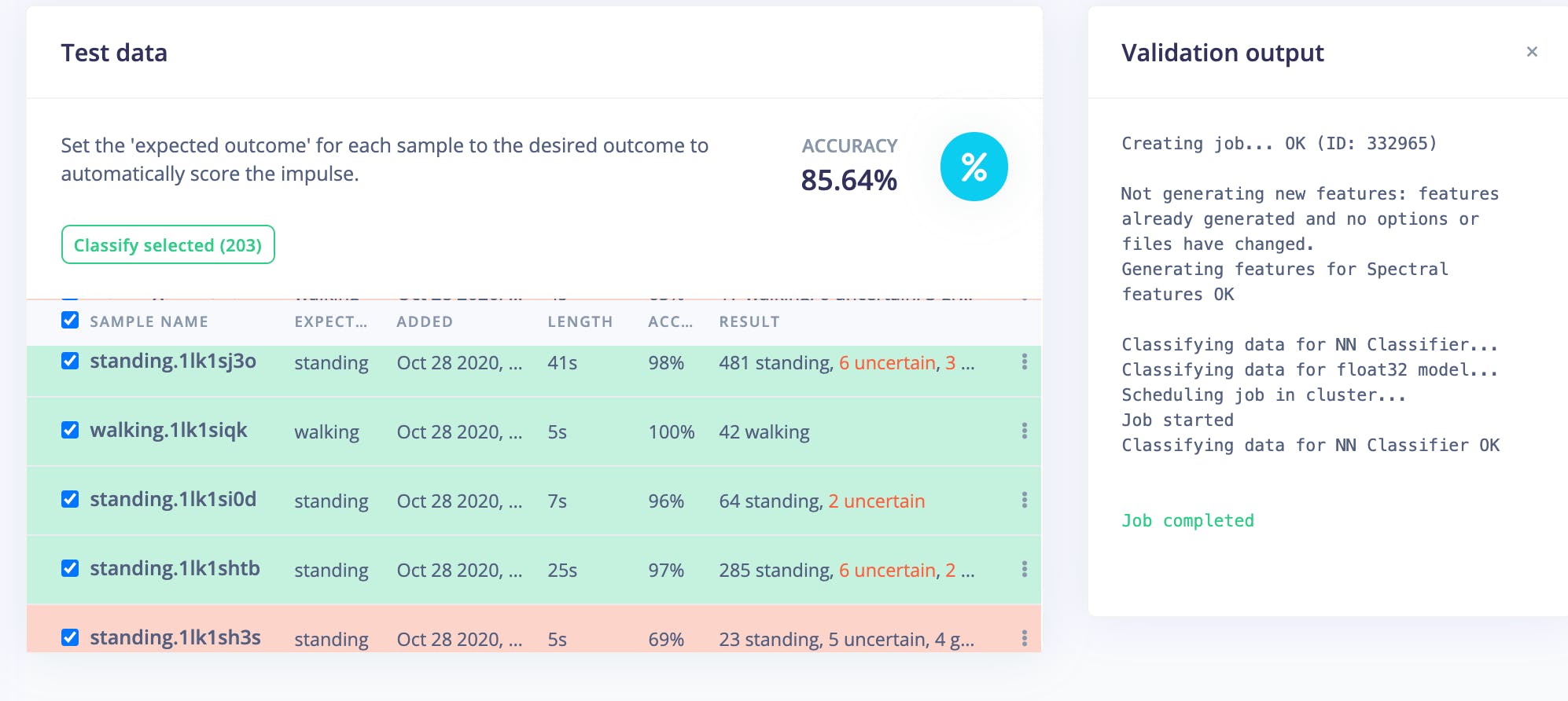

测试数据的验证准确性

我在测试数据上获得了85.64%的准确率,这是非常有希望的。

部署

我已将使用 Arduino 库创建的模型部署到 Arduino Nano 33 BLE Sense。Edge Impulse Studio 创建 Arduino 库包,可以下载并导入 Arduino IDE。我使用了加速度计(连续)示例之一,并对其进行了定制以读取加速度计和陀螺仪数据。我使用 Flutter 开发了一个移动应用程序,用于通过 BLE 连接连接 Arduino Nano 33 BLE Sense 并显示推理结果。

结论

经过多次迭代和参数调整,模型已经达到了很高的准确性。尽管训练数据取自 Goat/Sheep 数据集,但该模型是通用的,并且对于跟踪大象的运动肯定有用。如果我们可以使用大象项圈收集更多数据并使用迁移学习重新训练模型,则模型可以实现更高的准确度。所有代码和说明都在 GitHub 存储库中提供,可以在最后的代码部分找到。我在 Edge Impulse 的项目是Naveen/elephant_edge_v3。我要感谢 Edge Impulse 的人们,他们在 Edge Impulse 论坛上回答了我的问题并帮助解决了问题。

声明:本文内容及配图由入驻作者撰写或者入驻合作网站授权转载。文章观点仅代表作者本人,不代表电子发烧友网立场。文章及其配图仅供工程师学习之用,如有内容侵权或者其他违规问题,请联系本站处理。 举报投诉

- 相关下载

- 相关文章