资料下载

Dexter独立语音助手开源分享

描述

这个项目的目标是创建一个保护隐私的语音助手来控制我的物联网设备,即我的灯和电视。自从我发现即使是我的智能灯也一直试图与中国的服务器通信以发挥作用,我决定尽量将我的数据保存在本地。我建立了一个基于家庭助理的服务器来本地控制所有这些设备,并为语音助理提供一个界面。因此,语音助手本身会在被唤醒词唤醒后将一些语音片段转录为文本,然后通过 MQTT 将转录内容发送到服务器,由我的基本意图引擎解析,之后服务器会将预期的命令发送给我的设备。语音助手本身是完全独立的,不需要与任何其他计算机持续连接即可运行。

Dexter 的工作流程中有很多步骤——我将通过每一步解释我为使它们发挥作用所做的工作。

工作流程:

1. 使用永远在线的程序监听唤醒词

2. 监听命令并转录

3. 将命令发送到本地服务器进行处理

4. 解析命令并执行所需功能

我的主程序是一个 python 脚本——它运行一个无限循环,通过脚本调用唤醒词检测程序,并在检测到唤醒词时移动以收集音频,最后转录并将该命令发送到我的服务器。然后,循环再次开始,并调用唤醒词检测程序。

为了使设备正常工作,我首先需要将其连接到 wifi,并

在启动时连接。我最初尝试使用 cron 作业并使用 wpa_supplicant,但 cron 作业不可靠。相反,network-manager 是即时无线连接的无忧解决方案。为 Pocketbeagle 分配一个静态本地 IP 意味着我也可以始终通过 SSH 访问它以使用命令行,或者简单地使用 Web 浏览器连接到 cloud9 IDE。一个

顺便说一句 - 如果您尝试复制它,请不要使用任何基于 RealTek 芯片组的 WiFi 卡。安装一些社区编译的驱动程序以使其正常运行是非常痛苦的。谢天谢地,我最终找到了这个 GitHub 项目来处理它。

听唤醒词

对于设备上的唤醒词检测,我使用的是 Porcupine,这是一个非常轻量级的程序,也设计用于在 BeagleBone 设备上运行。首先,我们需要在picovoice.ai上创建一个帐户(不用担心,它是免费供个人使用的)以获得访问密钥。虽然 Porcupine 是完全本地的,但它在初始化时确实需要访问密钥。接下来,我们需要在 picovoice 控制台上为我们选择的唤醒词训练一个模型。Dexter 是唤醒词的绝佳选择,因为它不包含常见的声音,换句话说,减少了误报的机会。出于这个原因,Dexter(甚至 Alexa)中的“x”非常有用。

立刻,这个项目变得相当 hacky——Porcupine 的 python 实现在 PocketBeagle 上遇到了重大问题,在我放弃之前抛出了各种错误。相反,我尝试了 C 实现,并且能够让他们的命令行演示工作。但是,我使用 C 的经验为零,并且无法充分利用他们的 SDK。给定的演示文件被设计为从命令行调用,并运行启动指令检测的无限循环,检测时仅返回“检测到启动指令”。我修改了演示文件,改为在检测到启动指令后退出,并从 python 脚本(实际上称为名为 wakeword 程序的 bash 脚本)调用它。此脚本仅在唤醒词程序结束后才会继续,因此这是一个功能齐全的解决方法,可避免不熟悉 C 语言编程。

要获得演示功能,需要使用 cmake 对其进行编译,并识别功能麦克风,可以在他们的github 页面上找到更多说明。

听命令并转录

这里的子工作流程相当简单——调用 3s 的 arecord 流程创建一个 .wav 文件,然后上传该 .wav 文件以供 IBM Watson 处理。与 Porcupine 类似,IBM 也需要一个帐户和一个访问密钥。有关如何设置的更多说明可以在他们的网站上找到。我的麦克风帽以 44100 Hz 录制音频,这是传递给 arecord 的调用的重要参数,这是通过一个简单的脚本调用完成的。

在音频文件被记录并存储在 PocketBeagle 上之后,另一个 python 程序使用他们的 ibm-watson api 将其上传到 IBM,并等待接收转录。

向本地服务器发送命令

一旦命令被转换为文本,系统就会通过 MQTT 协议向本地服务器发送一条消息。我已经为服务器分配了一个静态本地 IP,并使用 Mosquitto 设置了一个 MQTT 代理服务。我不打算解释如何设置它,因为有很多资源。我使用 Mosquitto 的 Home Assistant 集成来尽可能轻松地完成此操作。

为了从 python 发送命令,我使用了 paho-mqtt 库。

解析命令和执行功能

为了理解发送的命令,我编写了一个基本的意图引擎。对于每个语句,引擎都会尝试识别一个实体(在我的房间中,灯 1、3 或 3 中的一个,电视,或像整个房间这样的自定义组)。然后,它会尝试识别意图。这就像打开,变红或变亮。它通过检查命令字符串并查看它是否包含实体关键字以及查看它是否包含意图关键字来执行此操作。因此,就引擎确认而言,命令“打开电视”和“打开电视”在功能上是相同的。默认情况下,如果没有找到实体或意图,则将实体设置为整个房间,并将意图设置为将它们变为白色。

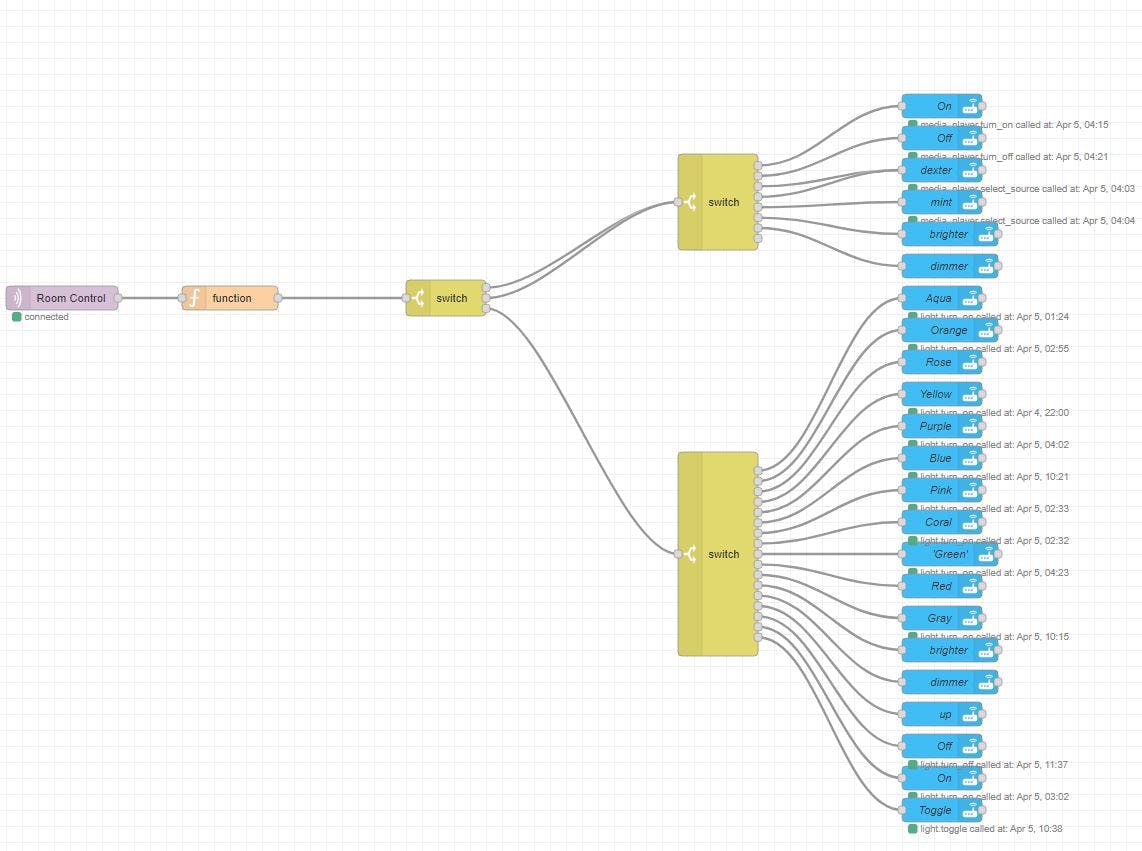

为了实现它,我使用了 Node-RED,它是 Home Assistant 中的一个集成,允许使用 javascript 程序来执行功能。下图显示了程序的流程,左侧有一个 MQTT 输入,进入一个实体标识符,然后根据实体是灯还是电视拆分为意图类型。

这是 parsed 命令的可选用法 - MQTT 可以以您认为合适的任何方式使用。

用法

使用系统很简单——系统启动后,您可以通过浏览器登录 IDE,或使用 PuTTY SSH 进入终端。然后,运行RunDexter.sh脚本将 Dexter 启动到永久的活跃状态。说“Dexter”将激活录音,由绿色 LED 指示。然后,您将有三秒钟的时间发出命令,之后绿色 LED 将熄灭,表示录制完成。然后,此记录会在后台上传到 IBM,系统会负责其余的工作,按照您的命令执行命令。

使用像 IBM 这样的基于 AI 的语音识别的一个怪癖是语音到文本系统倾向于寻找有意义的完整短语。因此,像“浅紫色”之类的东西可能对 AI 没有意义,它可能会返回一些没有意义的荒谬解释,并且由于上述默认设置,您将触发“房间白色”结果。因此,更像“把灯变成紫色”的短语将有更高的机会被正确识别。然而,在我的测试中,如果你说得清楚并且对你的陈述很聪明,那么系统的反应方式是非常好的。

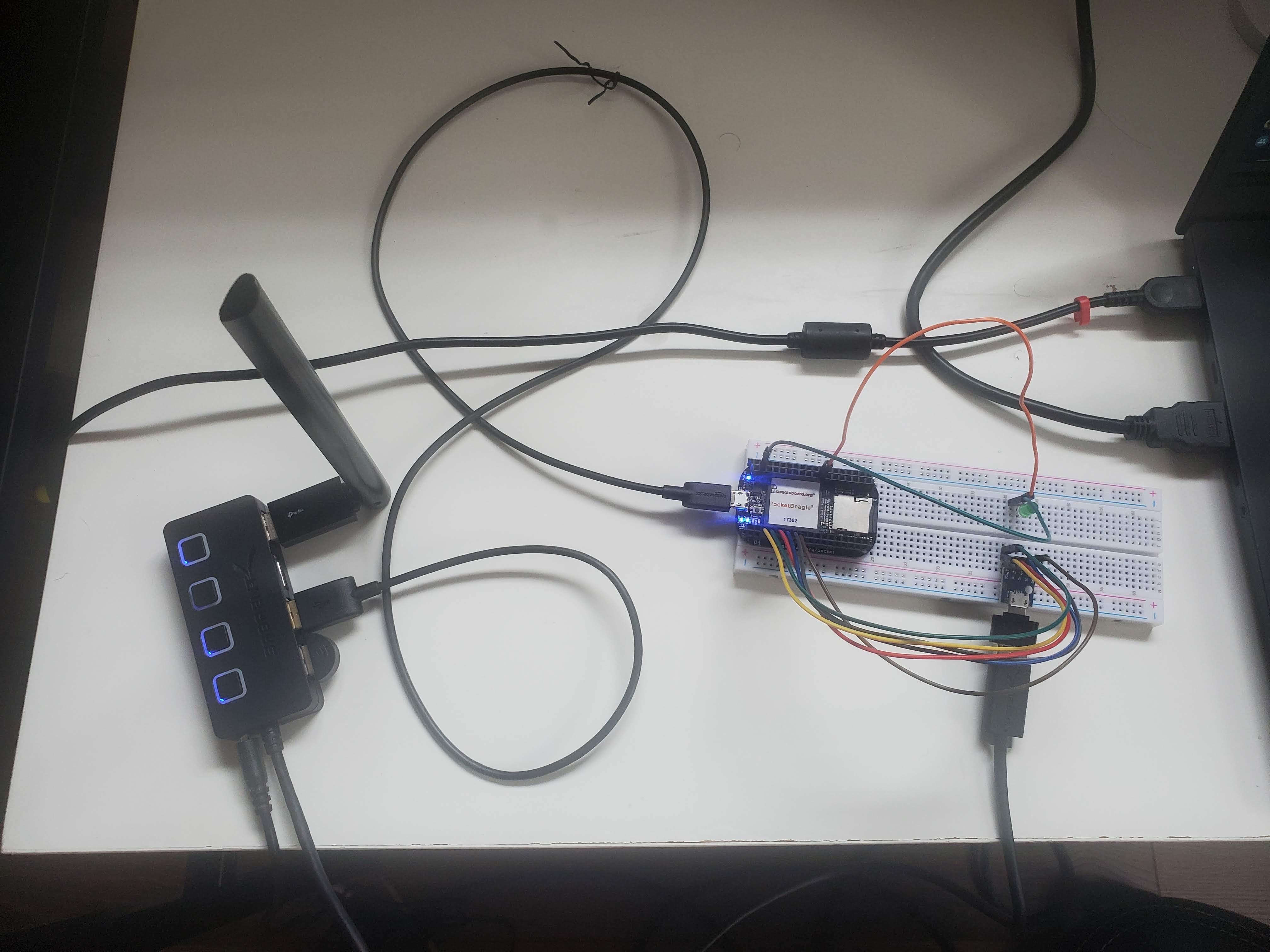

系统接线

这主要是一个编码项目,涉及许多 hacky 脚本。但是,下图显示了 PocketBeagle 的接线设置。

未来目标

将来,我打算扩展系统的功能。就目前而言,Dexter 不会回复你,也不能在一个语句中执行多个命令。这两个都是我很快就会做的事情。

声明:本文内容及配图由入驻作者撰写或者入驻合作网站授权转载。文章观点仅代表作者本人,不代表电子发烧友网立场。文章及其配图仅供工程师学习之用,如有内容侵权或者其他违规问题,请联系本站处理。 举报投诉

- 相关下载

- 相关文章